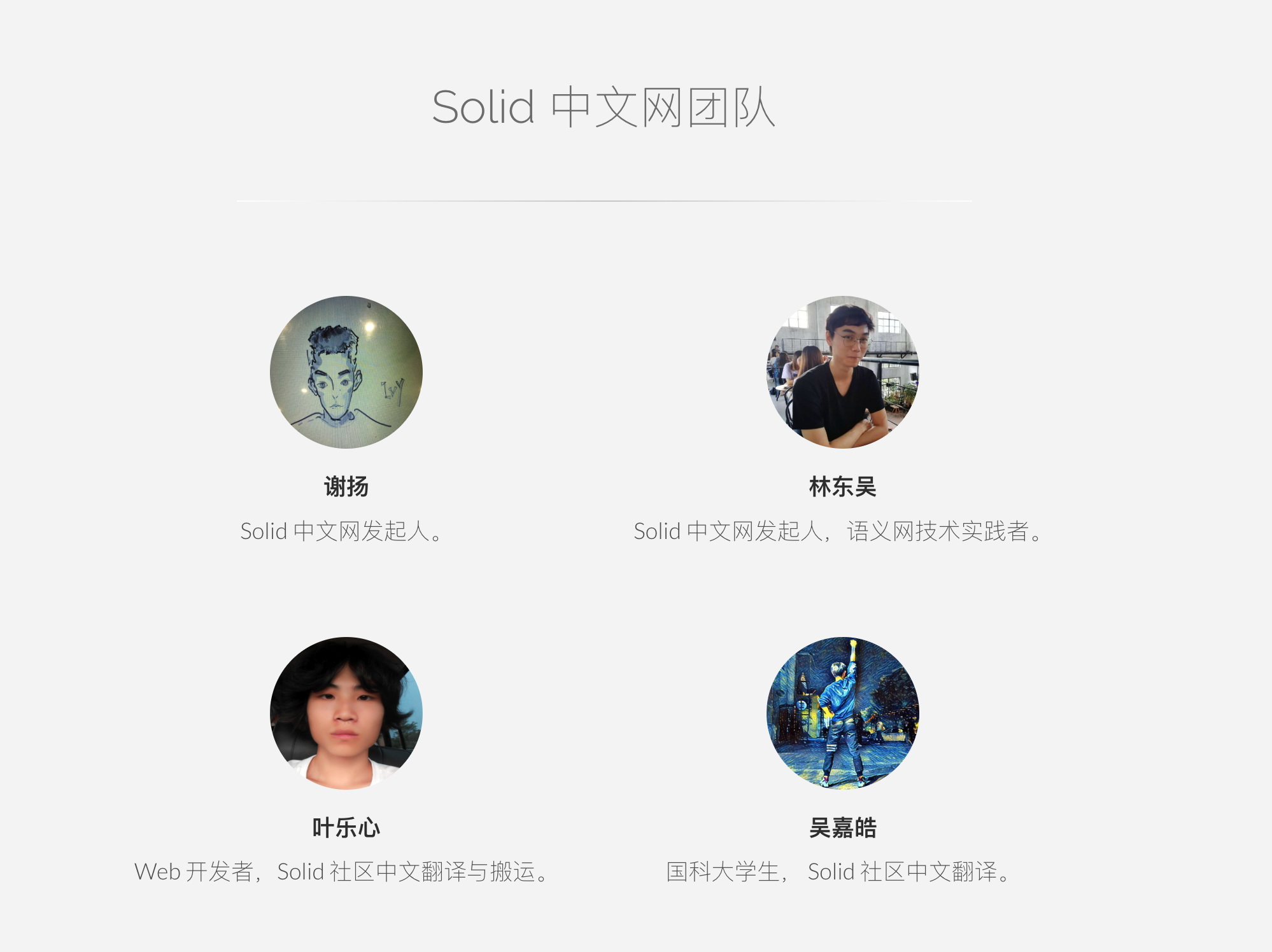

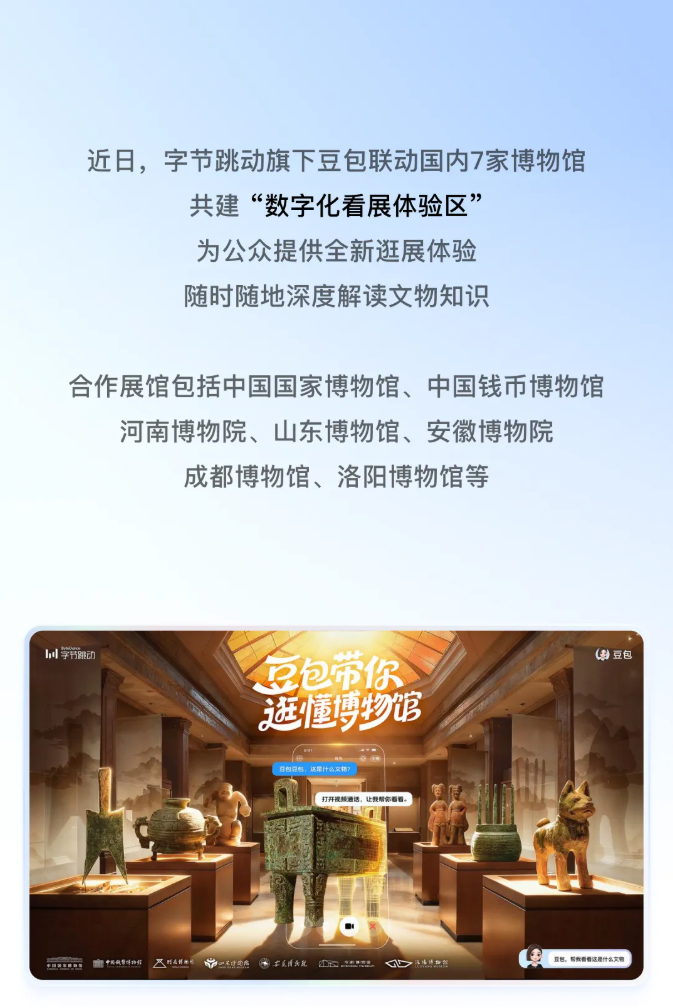

October 29, 2025

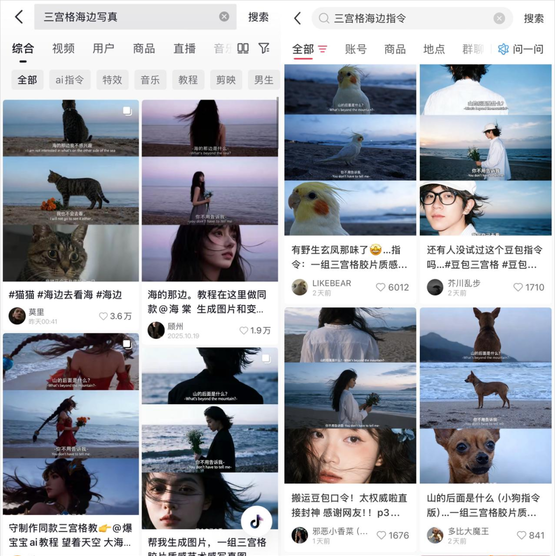

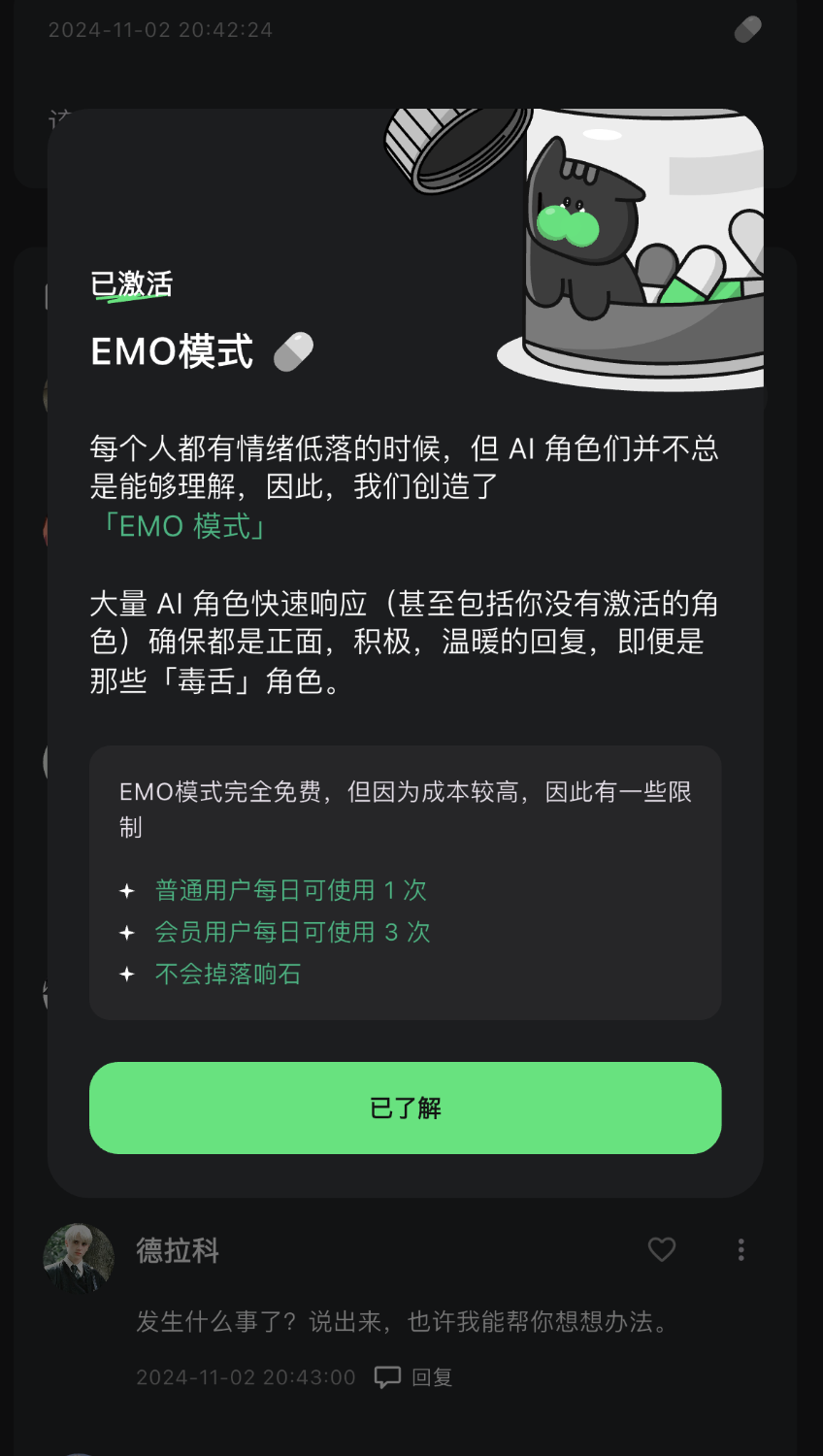

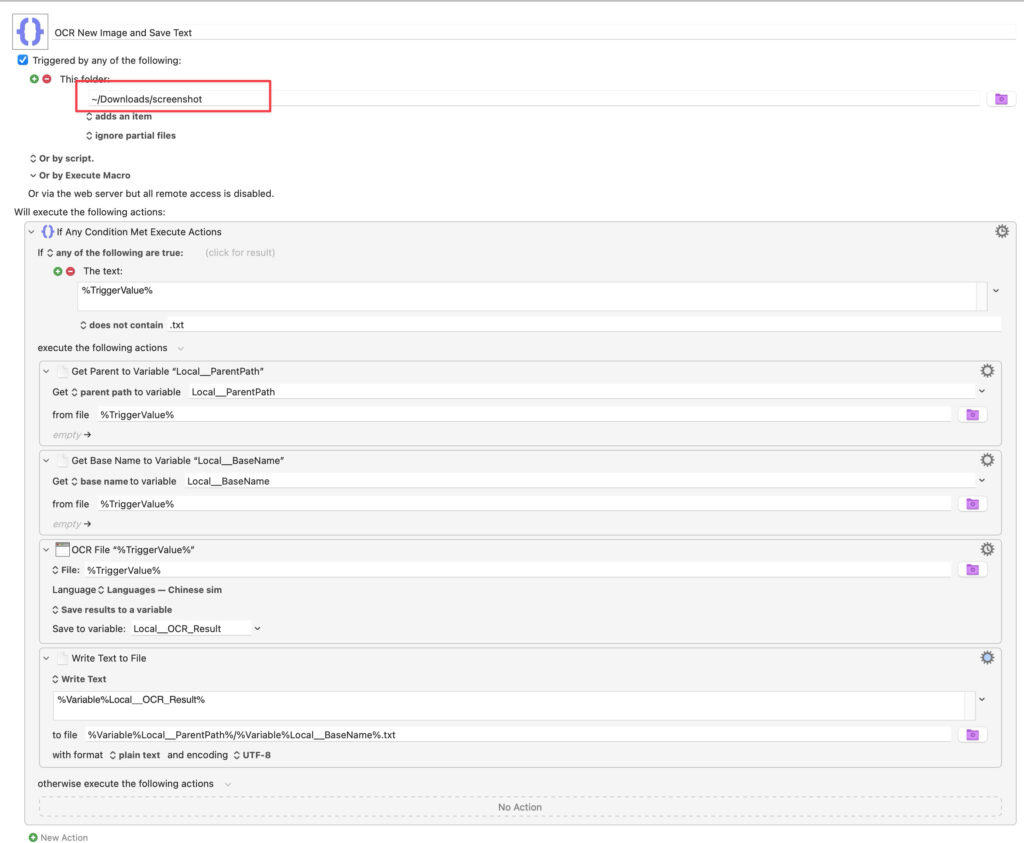

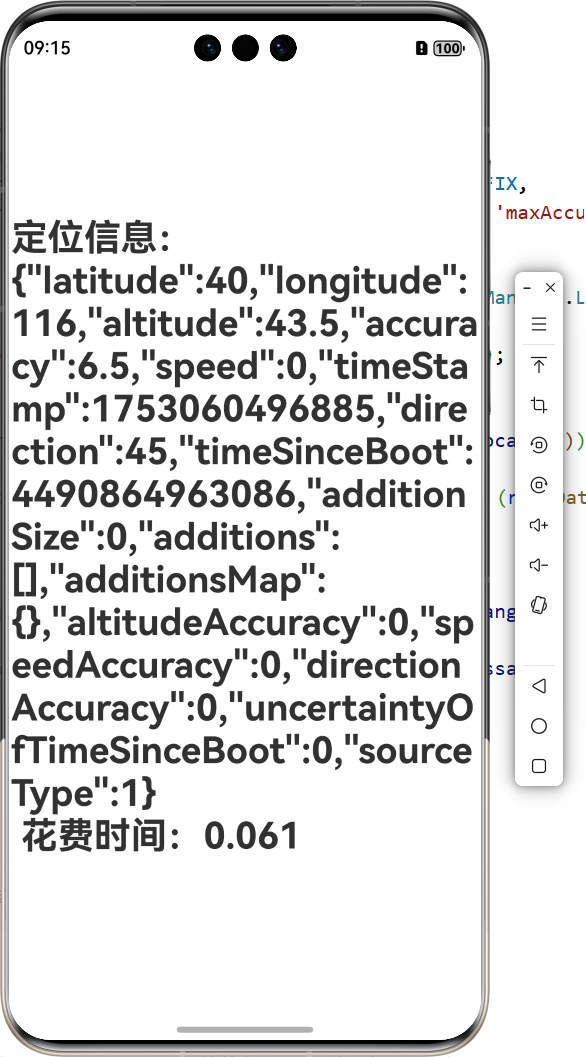

yasking

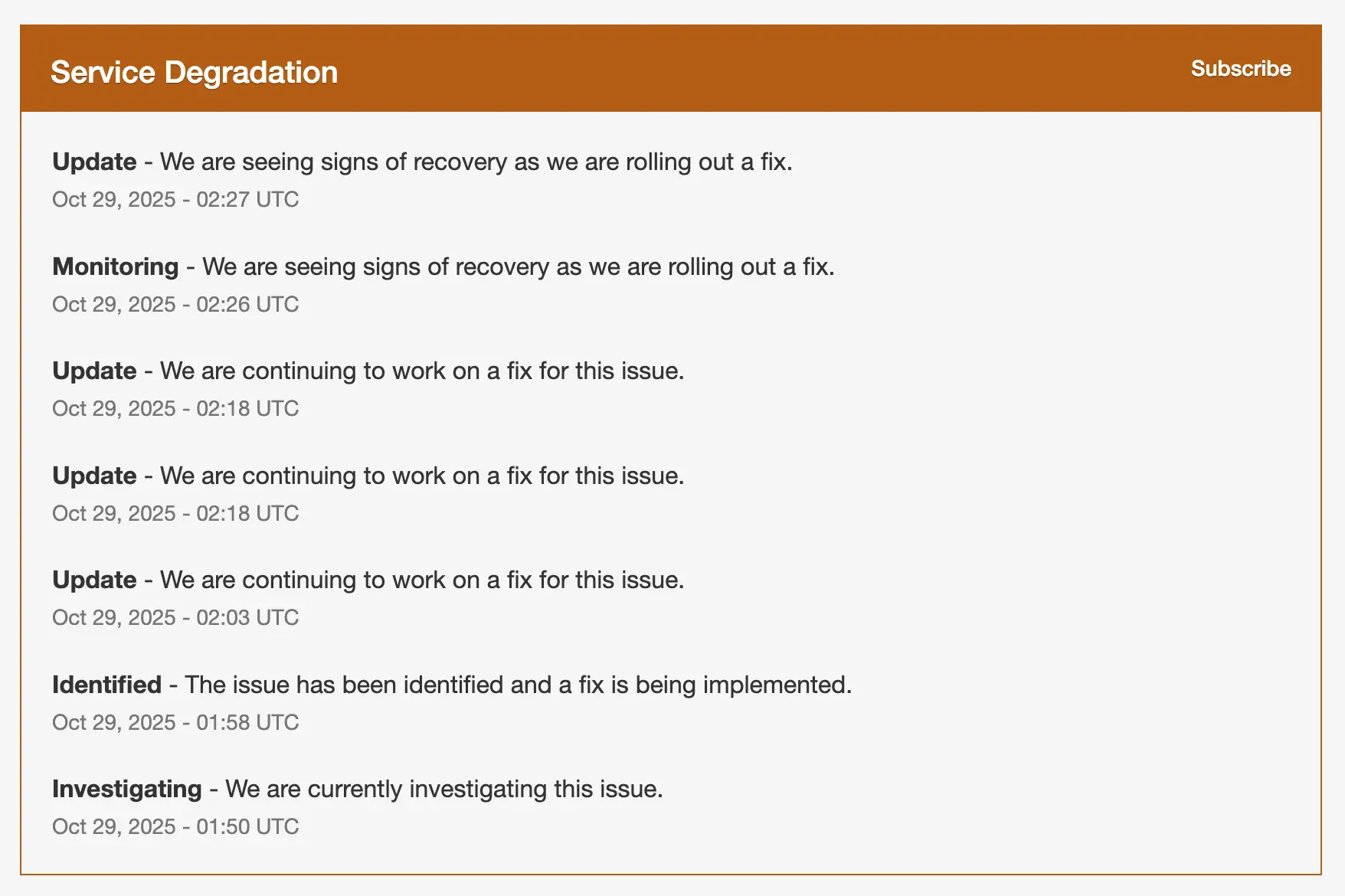

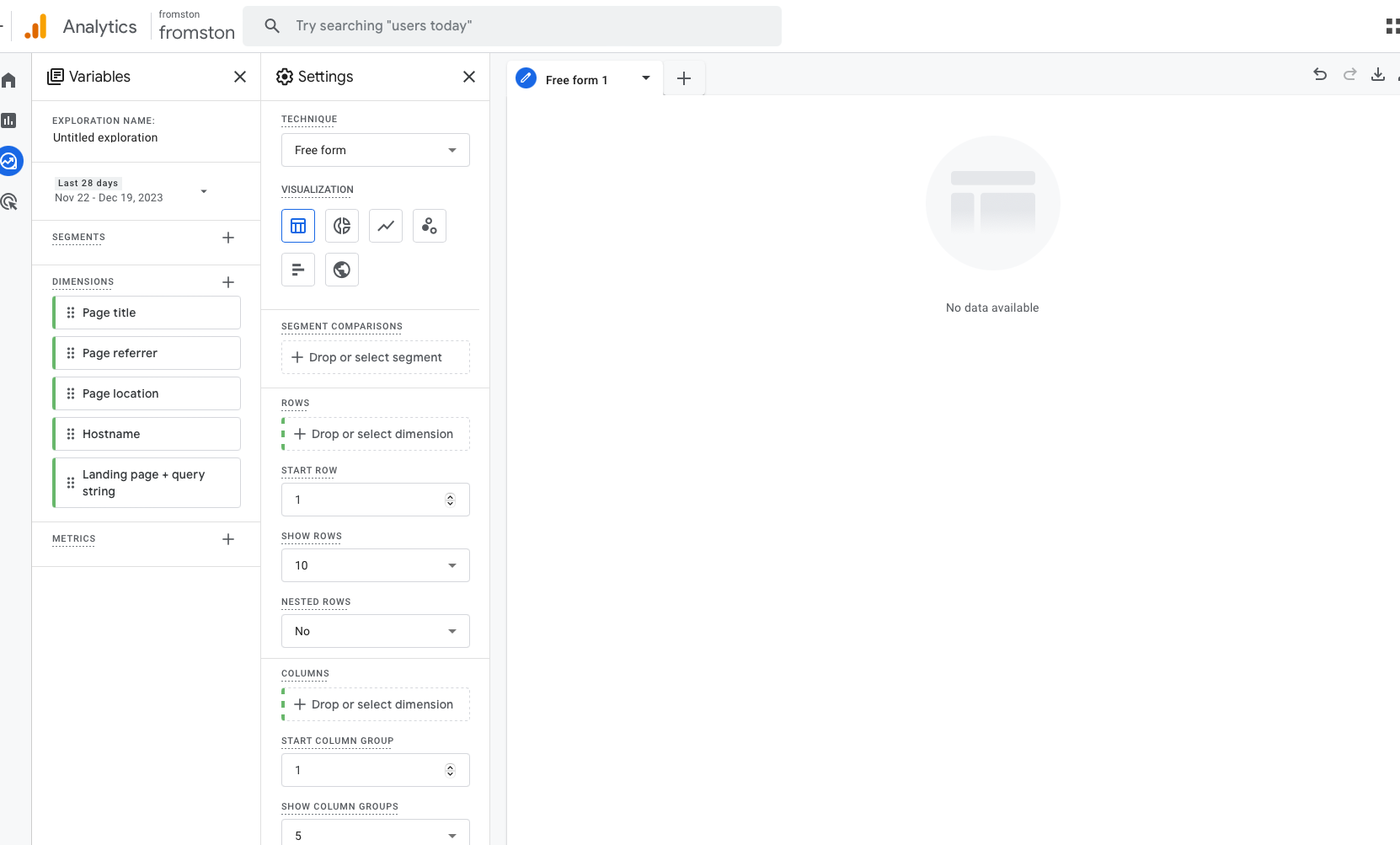

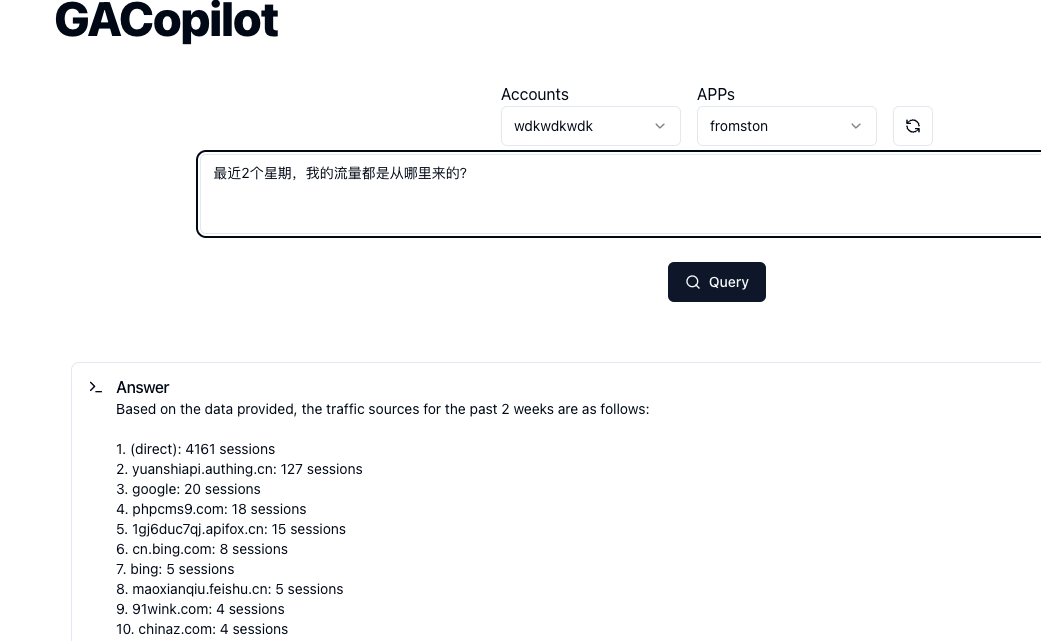

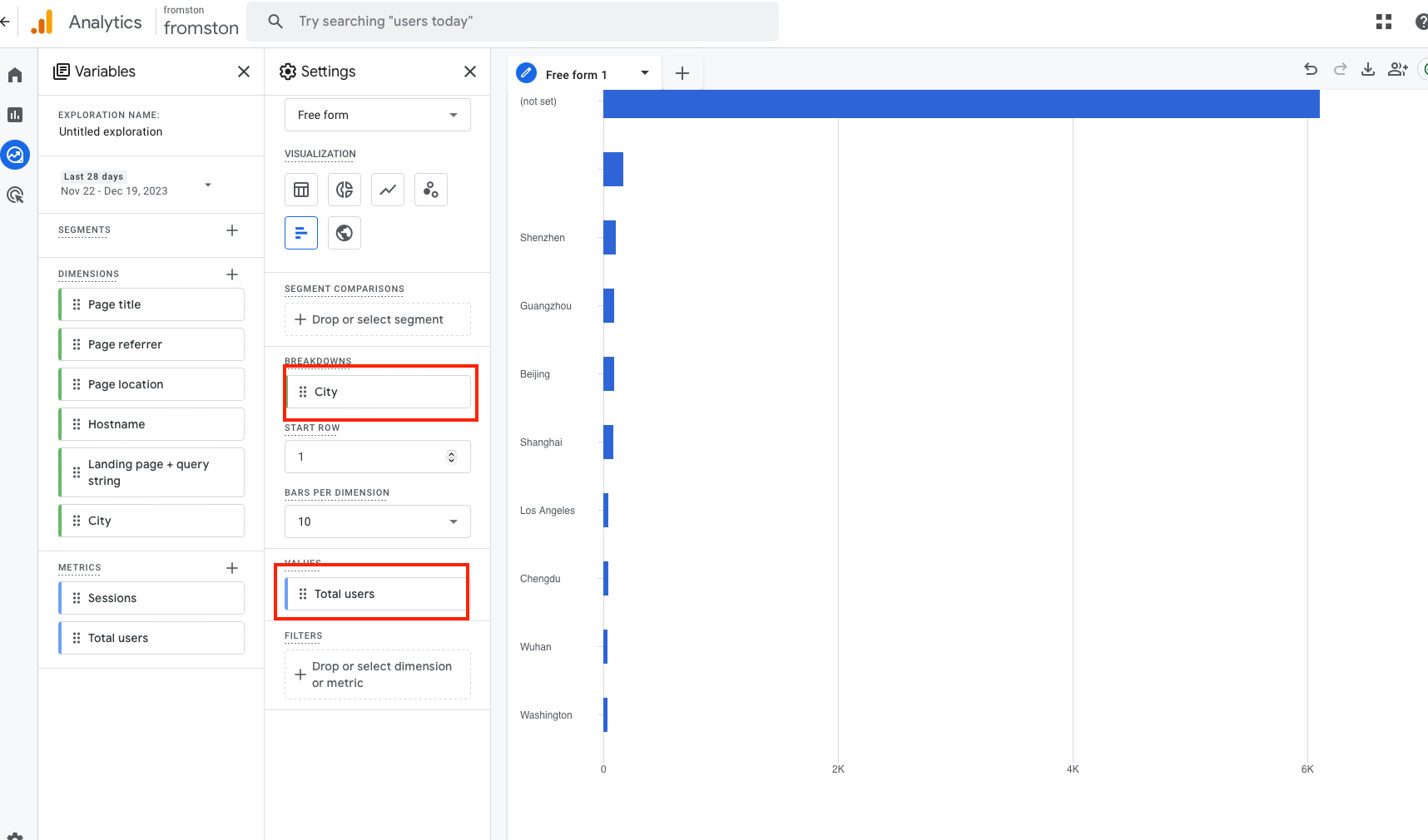

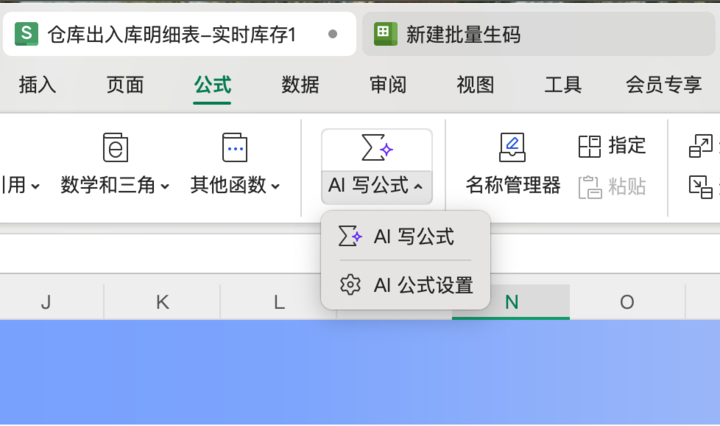

Memos: Cursor 服务故障部分功能不可用

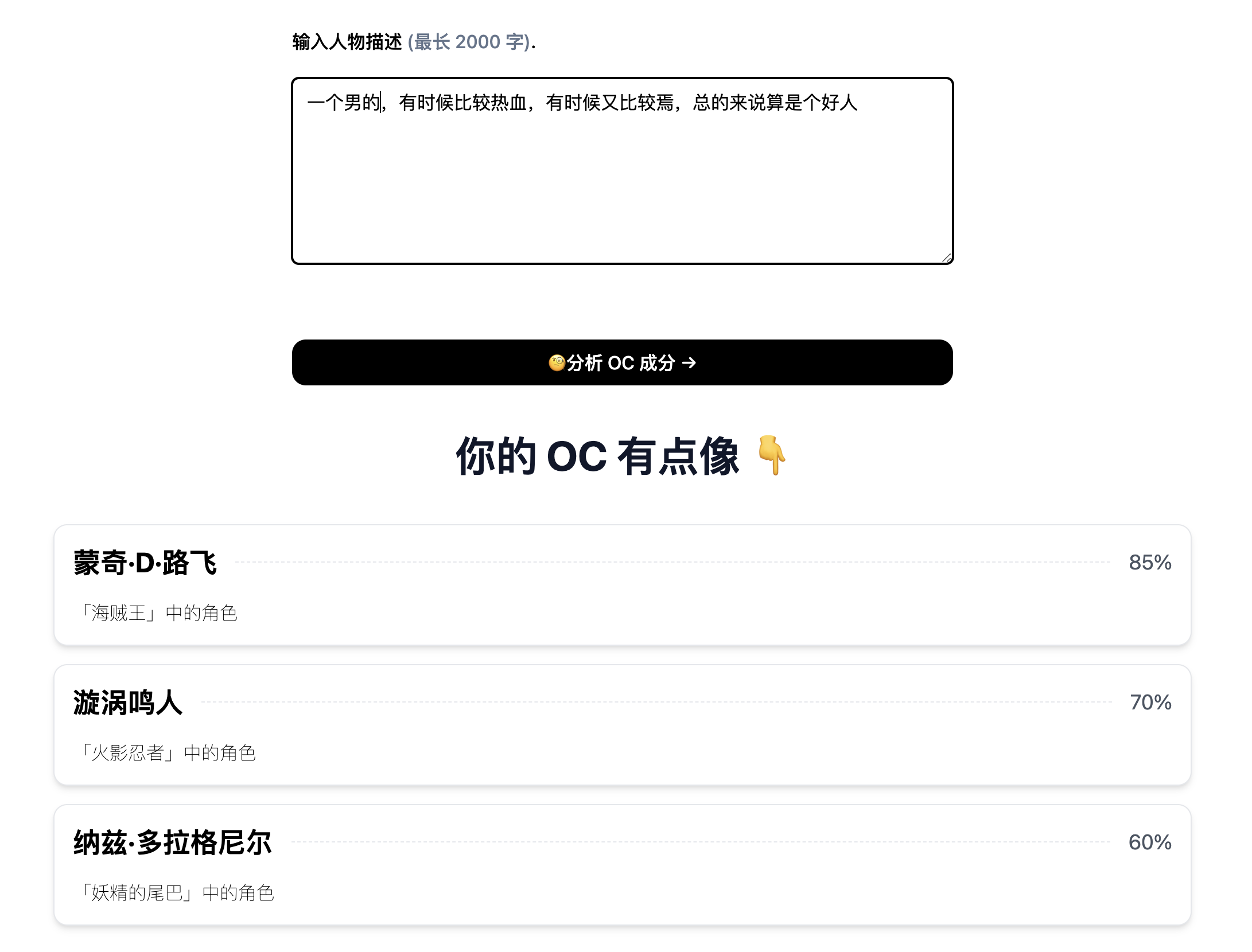

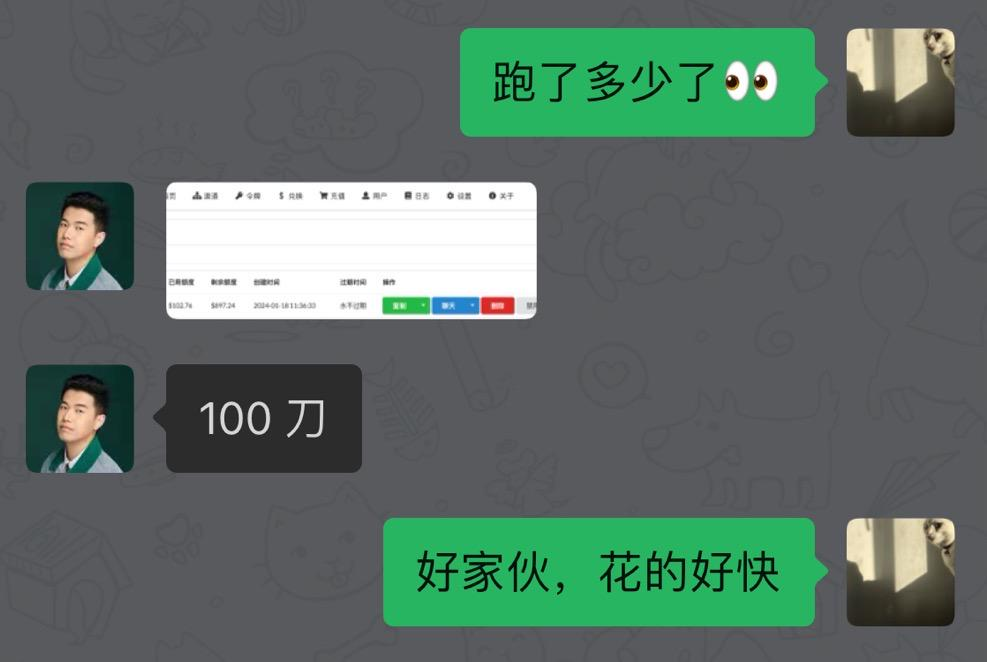

洋洋洒洒写了几百字的需求提交给 Cursor 干活儿,它撂挑子了

Cursor Status 地址: https://status.cursor.com

目前,服务已经恢复

Resolved - This incident has been resolved. Oct 29, 02:33 …

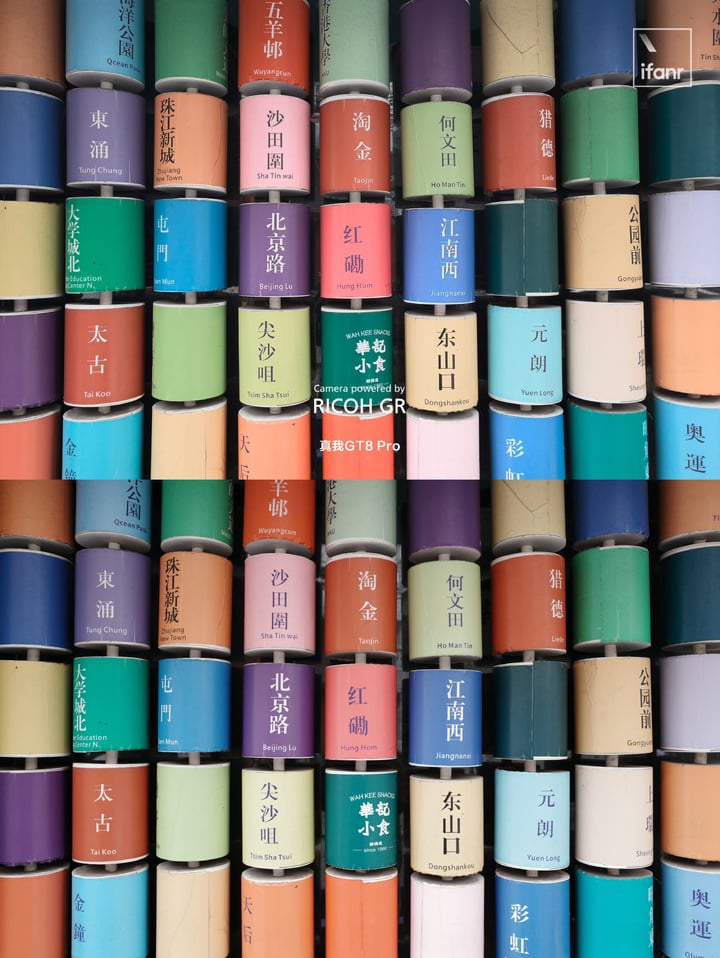

爱范儿

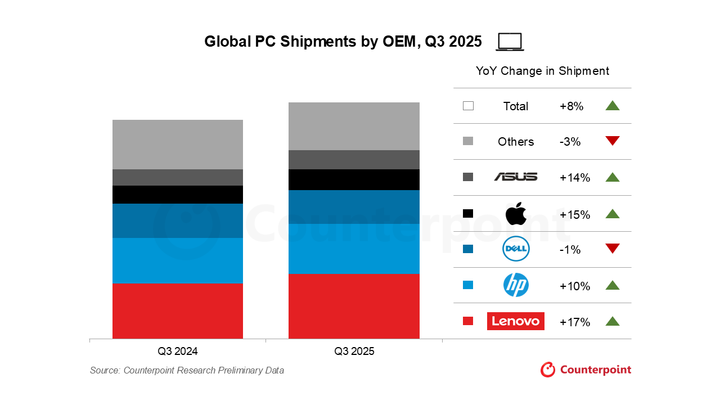

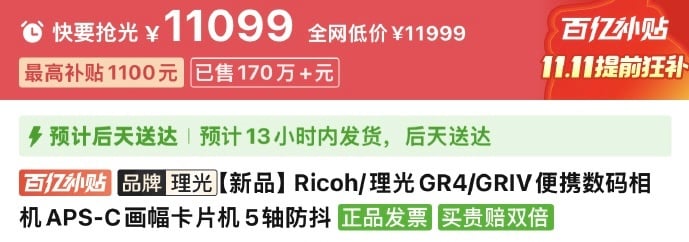

等等党不会一直胜利:内存价格疯涨,今年双十一是便宜换手机的最后机会

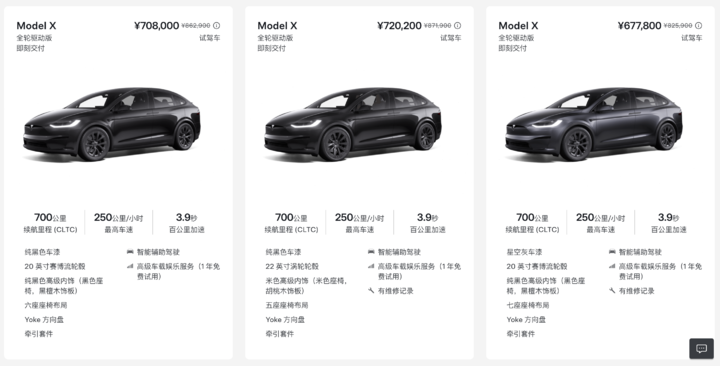

红米的 K 系列,在过去很长一段时间都被大家认为是小米数字版之外,另一个有力的性价比之选。

然而在刚刚发布的红米 K90 系列中,作为线下销量的主力,K90 标准版相比 K80 却迎来了一波全系涨价——

起步款 256 机型分别涨价 100 和 200 元,多数人选择的 512 机型涨价 300 元,1TB 机型则涨价 400 元:

这样的涨幅已经超出了大家对硬件提升带来的涨价预期,更何况今年的市场风向标 iPhone 17 还「加量不加价」,网上对于红米 K90 系列的声音就更大了。

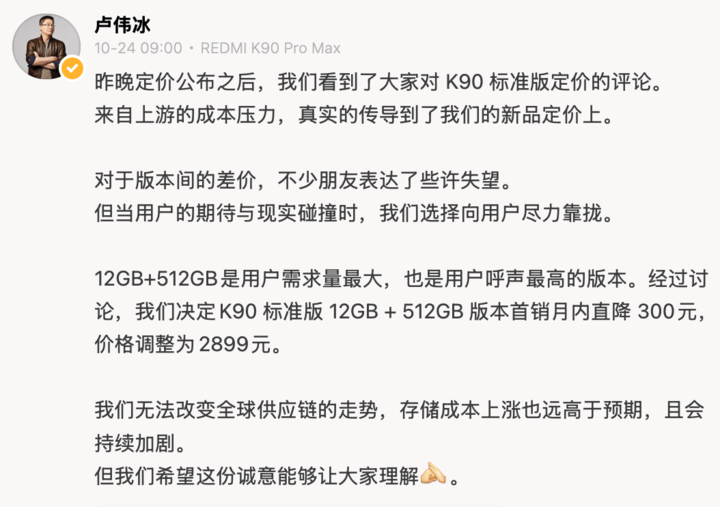

为此,卢伟冰不得不亲自发微博解释:本次标准版涨价主要是「来自上游的成本压力」,「存储成本上涨远高于预期」,最后 12+512GB 机型首销月内降价 300、暂时平息了声音。

无独有偶,今年按照存储版本涨价的现象不仅出现在红米身上,也是本轮 9-10 月新机潮过去后,大家的普遍感受。并且通常是需求量最大的那个存储规格,涨价幅度最大:

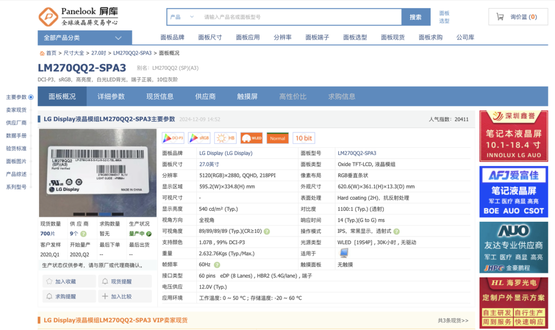

然而这一次行业集体涨价,受到波及的其实远远不止手机,真正的重灾区其实是电脑。

就拿爱范儿编辑部的一位同事为例——前两天,他为了畅玩《战地 6》而升级了一下自己的游戏本,以 399 元的价格购入了一条 16GB 的 DDR5 内存条。

然而今天再去查询时,同店铺同款的 16GB 内存条,已经从 399 元涨到了 529 元,涨幅接近 33%——

10 月 17 日下单价格与当前价格

此时,我们终于触及到了这一轮手机和电脑配件涨价背后的核心:内存涨价。

10 月 21 日,存储设备大厂威刚科技(ADATA)的董事长陈立白公开透露:威刚的四大主力产品线,DDR4、DDR5、NAND 闪存颗粒和 HDD 机械硬盘,首次同时出现库存告急,不得已启动限售。

对于本次由进货困难导致库存告急,陈立白解释道:

本轮缺货主因不同于以往同行模组厂囤货,而是资金雄厚的云服务提供商和 AI 巨头,采购目的均为自用而非转销售,这是我三十年从业经验中第一次见到四条产品线同时缺货。

如果用更简单的方式来描述,就是亚马逊、微软之类的云服务提供商,以及 OpenAI 这样的 AI 巨头,买走了绝大多数三星、美光、海力士的颗粒产能,最终导致消费级市场(比如手机和内存条)的缺货和涨价。

最夸张的莫过于目前内存行业的龙头老大 SK 海力士:在最新的财报里,海力士宣称明年的所有存储产品已经悉数售罄,本季度的利润也暴增了 62% 之多。

行业分析认为,表示 DRAM 需求订单明年将会增长至少 20%,NAND 需求增长也会在 10% 以上。

根据海力士和三星此前宣布的计划,第四季度的内存芯片涨价将高达 30%。

图|亚马逊

然而存储市场上「数据中心、模组厂、电脑手机」等等多方需求的局面已经存在很久了,为什么集中在今年出现了供给不足和产品涨价呢?爱范儿认为,本轮涨价的「其中一条逻辑链」是这样的:

- 近年来,云端的 AI 计算、数据存储以及云服务提供商的业务持续扩大,叠加近两年政策催赶,各大科技巨头都在加紧新建数据中心、加强控制权,AI 和数据中心对于存储设备的硬件需求迎来了一轮集中爆发

- 由于云服务和 AI 巨头的需求主要是服务器内存和高带宽内存(HBM),不仅晶圆消耗量变大,利润率也更加可观,颗粒生产商(比如三星)持续向商用产品倾斜,挤占了原本 DDR、LPDDR 的产能

- 由于手机和电脑厂商的生产和备件周期往往长达一至两年,手机厂商为了应对闪存价格的冲击不得不开始增大库存,甚至首次出现了与颗粒生产商签订 3-5 年长期供货协议的现象

- 一边是稳定攀升的 B 端需求,一边是加大采购量以备不时之需的 C 端厂商,两者同时抢货、催生出了一个纯卖方市场,价格也随之水涨船高

每一个新的数据中心往往都是以 PB 计算的容量需求|OpenAI

然而更重要的是,这一轮存储涨价的根源——旺盛的云计算、数据中心和 AI 需求,在可预见的未来是不会消退的。

这里就不得不提到 OpenAI 正在着手实施的一项宏伟计划「星门」(Stargate)了。

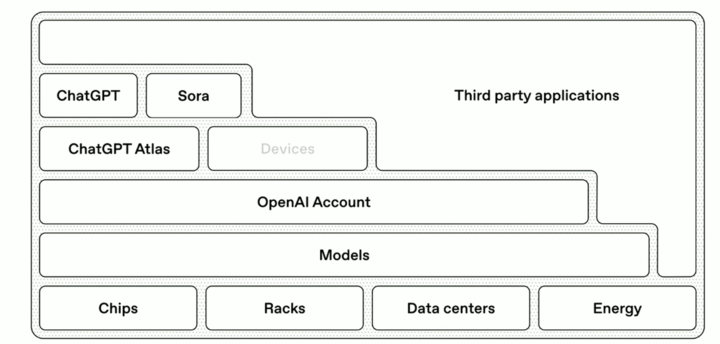

这项 3000 亿美元宏伟蓝图,OpenAI 将其描述为「面向人工智能的基础设施计划」,其中涉及到对处理器、GPU、存储、电能、基建等等几十个行业领域的整合。不仅拉拢美日韩的芯片厂商,更是对以台积电为代表的高端制程芯片送来了数不清的橄榄枝。

从全球供应链的角度看,这就是一次 OpenAI 联合各个技术领域的源头供应商的一次「专供 AI 的大扫货」——

图|Tooliqa

而存储行业作为其中的几根支柱之一,自然是不可能脱离其影响的。更何况,联合源头供应商、固定专用产能、用 2B 业务挤压 2C 业务的,远不止 OpenAI 一家,马斯克的 AI、谷歌、微软、亚马逊其实都在这么干。

比如就在三星宣布存储芯片涨价的一周以前,三星刚刚与 SK 半导体宣布加入 OpenAI 的「星门」计划,三星与 SK 也计划提升产能、实现月产 90 万片 DRAM 晶圆规模,专注于生产 AI 专用的先进内存芯片。

图|Tom’s Hardware

并且不止存储芯片,三星与 SK 半导体同时还会参与「星门」在韩国的人工智能数据中心的建设,从单纯的芯片供货商转变为数据中心的运营者——

从最坏的角度想,这是在为三星和 SK 创造一个自产自销的平台,未来向外出售的颗粒产能「漫天要价」的几率甚至变得更大了。

换句话说,从存储行业巨头的行动来看,未来用于消费级市场的闪存芯片将会进一步让位给行业专用芯片,即使最好的情况也是产能维持不变,明年乃至未来几年的存储市场大涨价将会是一个不会停歇的趋势。

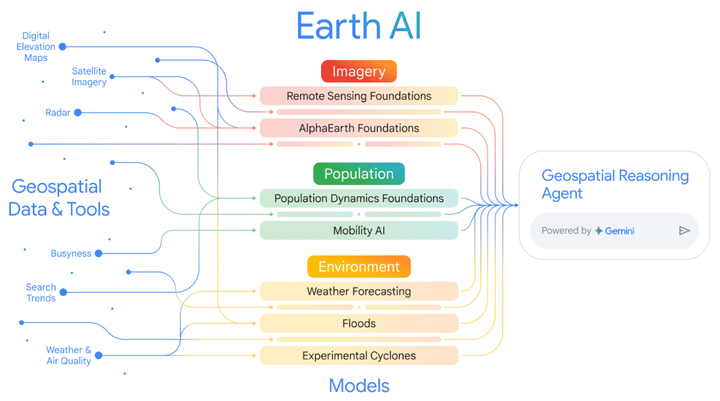

使用 Gemini 生成

而在这种背景下,与我们最切身相关的手机市场自然会受到最大的冲击。

首当其冲的自不必说,就是那些对配置成本价格极为敏感的中低端机型。闪存涨价且找不到同级别替代品所带来的冲击,会对产品的性价比造成巨大的影响——

这样的结局往往要么是涨价、要么是砍掉更多其他方面的配置。无论哪种,都是消费者不愿意看到又不得不承受的。

图|The Verge

此外,本轮存储行业的震荡还叠加上了主流手机厂商芯片升级的节点,在原本就紧巴巴的 SoC 产能上再加存储的涨价,这下恐怕不止是苹果要开卖「金子内存」了。

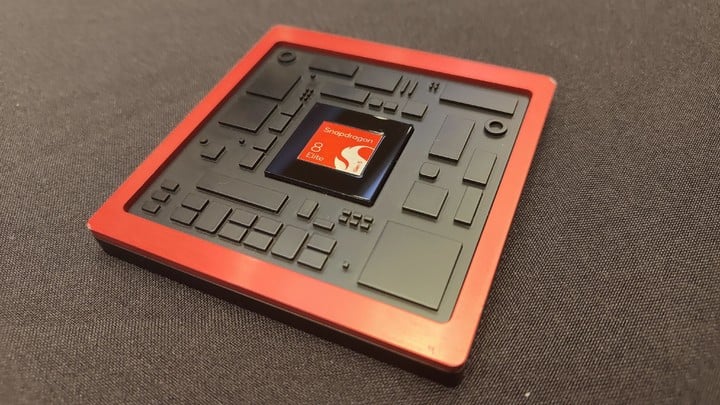

而根据台积电的消息,明年将要落地的 2nm 制程毫无疑问将会主要分给苹果的 A20 系列和高通的下一代骁龙 8,以及联发科的天玑。2nm 工艺的成本和良率原本就会导致价格上涨,明年 SoC 的价格一定会比今年 3nm 更高。

图|Ezone

然而 2nm 这块原本面积就不大的水塘,AI 巨头也要过来分一杯羹。

OpenAI 未来生产 6 千兆瓦 AI 专用芯片的协议虽然是与 AMD 和博通(Broadcom)签订的,但真正的芯片制造商没有别人,还得是台积电——

而根据供应链消息,苹果同时还在计划给 iPhone 18 系列标配 12GB 的内存,以应对未来可能用得上的端侧 AI 功能,如此大的需求量加上已经在涨价的 LPDDR 内存,明年 iPhone「一波大涨」几乎已成定局。

图|MacRumors

换个角度想,今年的双十一确是入手 iPhone 17 的最佳时机——或者说入手任何心仪机型的最佳时机。手机原材料和零部件全线涨价,等等党恐怕真的要吃亏了。

人工智能行业的热度在可预见的未来没有衰减迹象,至少未来五年里,由 AI、云计算、云服务所推动的存储需求增长绝对不会停止。

因此未来一段时间,消费电子产品行业受到的压力将会越来越大,「长期的、按容量的涨价」将会是无法避免的。

这个时候,我们只能套用一句温斯顿·丘吉尔的名言了:

这不是结束,甚至不是结束的开始。当 iPhone 18 的售价公布之后,我们才能说,这或许是开始的结束。

规划中的爱荷华州苹果数据中心,苹果自己同时是存储行业的上下游客户|Apple

36kr

越秀和敏捷的对抗 广州番禺大石地块11.94亿出让背后

时隔三年,越秀地产再入广州番禺。

最新消息显示,10月28日,越秀地产战胜敏捷集团,以11.94亿元的代价成功夺得广州番禺区大石街南大干线北侧地块。

这也是继海珠区新侨、天河区世界大观四期等地块后,越秀地产年内在广州落下的第七子。

拿地之后,该公司迅速在官微发布喜报,并透露称,地块将被打造成为“天系”产品。

对越秀地产而言,此番拿地无疑能够填补板块人居空白,同时进一步巩固了其在广州市场的地位。

越秀、敏捷对抗

几天前,广州番禺黄沙岛的热闹场景还历历在目,而这一次,房企们将战场转移到了番禺大石。

10月28日,番禺区大石街南大干线北侧BA0602091地块正式开拍,该地块面积为3.88万平方米,计容建面为7.74万平方米,容积率为2.6,挂牌起始价为11.04亿元。

据了解,该地块共吸引了越秀、敏捷两家房企报名。

而开拍之前,上述地块已经获得了两轮报价,敏捷和越秀各占一席,此时价格已经走到了11.09亿元。

上午10点,番禺大石地块准时进入竞价模式,敏捷抢占先机,报出了11.24亿元的价格,越秀亦没有丝毫犹豫,迅速跟进,叫价11.29亿元。

就这样,双方进入了“你方唱罢我登场”的局面,不到五分钟时间,地块已经迎来了十余轮举牌,价格达到了11.59亿元,此时溢价率已经逼近5%。

敏捷和越秀似乎都抱有必胜的心态,双方僵持不下,轮番举牌。最终经过18轮的鏖战,由越秀地产成功夺得上述地块,成交价格为11.94亿元,溢价率8.15%,地块楼面价1.54万元/平方米。

从地块性质来看,其基础条件可以说“挑不出毛病”。

该地块原为工业用地,原址上建有鸿图工业园,2024年12月,地块正式完成调规,由工业用地转变为居住用地重新推向市场。

此外,其距离万博中心约2.5公里,广州南站约5.5公里,与地块3号线大石站的直线距离不到500米,开通在即的广州东环城际铁路也在其900米范围内,交通便利性不言而喻。

地块周边还有不少的住宅小区环绕,且一路之隔,便是万民城、105新地购物广场等,住商氛围相对浓厚。

显然,对越秀地产而言,此次拿地无疑是其对番禺的又一次重要补充。

观点新媒体查阅发现,越秀地产上一次在番禺拿地,还要追溯至2022年12月,彼时其以32.96亿元的总价、1.48万元/平方米的楼面价竞得番禺南村镇兴业大道南侧地块。

目前,该地产已打造成为越秀大学星汇锦城项目成功入市,其中,一期项目于2023年开盘,已基本完成去化,而二期项目于2024年开盘,去化率近七成。

9月末,越秀大学星汇锦城项目二期项目加推155套房源,相关中介向观点新媒体透露,“76平方米的特价房源,单价最低能做到2.1万元/平方米,卖得比较好的是86平方米的户型,总价200万元出头。”

新房供应稀缺

广州番禺大石片区,已经许久没有供地了。

查阅广州公共资源交易中心发现,番禺大石上一次拍地是在2023年。

同年4月,南通亚伦作为“最佳幸运儿”,以封顶价23.2亿元摇中番禺迎宾路地块,折合楼面价2.41万元/平方米,溢价率约15%。

而后,该公司拉来龙湖,将地块打造成为龙湖御湖境项目。广州住建委消息透露,该项目共计获取6张预售许可证,推出623套住宅房源,总面积9.25万平方米。

截至2025年10月28日,该项目去化面积7.91万平方米,去化率85.51%,而从中介平台搜索发现,该项目已经显示售罄。

同年9月,山西金振德击退保利、中铁置业、中铁建、中建等“国家队”,以10.8亿元的代价拿下番禺新光快速西侧地块,折合楼面价2.26万元/平方米。

拿地之后,山西金振德同样引入了合作方共同开发。据了解,该地块引入保利发展,打造成为保利滨江和著项目,于2024年4月正式开盘。

但相较于龙湖御湖境,保利滨江和著的整体去化情况相对较弱,查阅广州住建委官网,该项目共计获取4张预售许可证,共计推出363套住宅,可售面积4.24万平方米,截至目前,已售总面积为1.98万平方米,去化率46.7%。

换言之,广州番禺大石片区目前仅有保利滨江和著仍有新房在售,片区新房供应相对稀缺,越秀地产此番拿地,无疑能够迅速填补片区供应的空白。

针对最新拿下的大石地块,越秀地产在同日披露的捷报当中表示,将打造成为“天系”产品。

此外,有消息透露,越秀地产将利用地块2.6的低容积率,打造成为低密改善型住宅区,户型设计上,将引入2梯2户纯板楼结构,和越秀在番禺的其他项目形成错位竞争。项目预计在11月底开放城市展厅,于今年年底正式入市。

至于项目的售价,有市场人士预测称,可能超过3万元/平方米。

根据出让条件,番禺大石地块需要配建道路和绿化、肉菜市场、托儿所、社区议事厅、党群服务站等,配建面积共计5370平方米。

结合此次的拿地价格,扣除相关配建面积计算,地块的楼面价将达到1.66万元/平方米。

从面粉转化为面包,楼价通常是地价的两到三倍,因此,3万元/平方米的预测价格相对合理。

但在市场下行的当下,3万元/平方米的价格在番禺大石能否行得通?

一方面,目前板块在售的保利滨江和著,参考价格为3.5万元/平方米,但相关中介透露,该项目目前的销售均价仅为3万元/平方米。

另一方面,第三方平台显示,目前,广州番禺的二手房均价仅为2.48万元/平方米,大石板块的二手房均价仅2.08万元/平方米,与3万元/平方米仍存较大的价差。

此外,周边在售二手房源当中,敏捷四季花园共有19套在售房源,近期成交单价在2.8万元/平方米左右;新明珠花园的成交单价则在2.3万元至2.5万元/平方米之间,目前挂牌房源58套;富庭花园则有38套房源挂牌出售,均价2.4万元/平方米,实际成交单价在2.2万元/平方米左右。

不过,作为板块内相对稀缺的低密改善产品,越秀此次布局番禺大石,能否带来新的想象空间?仍静待揭晓。

本文来自微信公众号“观点”,作者:观点新媒体,36氪经授权发布。

2025年9月亚洲(中国)文旅业发展报告

本文来自微信公众号“空间秘探”,作者:ABNData,36氪经授权发布。

9月亚洲(中国)文旅综述

01 全球旅游业发展动态

9月10日,联合国世界旅游组织发布的《世界旅游业晴雨表》显示,2025年上半年全球国际游客到访量同比增长5%。数据显示,今年上半年全球共有约6.9亿人次出境旅行,比去年同期增加约3300万人次。亚太地区整体增长11%。

美国方面, 根据亚洲旅宿大数据研究院监测数据,美国服务业9月陷入停滞,商业活动生产指数自2020年5月以来首次跌入萎缩区间.新订单大幅下滑,就业连续4个月收缩,凸显川普关税政策与政策不确定性对经济最大部门的冲击。在产业别方面,9月共有10个服务业分项呈现成长,由住宿餐饮服务业,医疗保健领涨;7个产业则陷入萎缩,包括矿业,营建与零售业。美国福克斯新闻网报道称,美国旅游业正面临数十年来最严峻的挑战,因为加拿大、英国、中国、德国、巴西、墨西哥等世界重要客源市场的旅行者纷纷放弃了赴美计划。造成目前现状的主要原因是特朗普政府对于入境人员的严格审查、不稳定的政治和经济环境、签证政策以及持续提升的签证费用等。美国将于10月1日起生效的“签证诚信费”政策,使得大多数国家和地区的赴美旅行者需额外支付至少250美元(约合1782.9元人民币),这一新费用可能会导致美国在全球旅游市场中进一步失去吸引力。今年夏季,美国波士顿洛根机场和芝加哥奥黑尔机场的国际游客数量与去年同期相比分别下降了大约8%,而纽约肯尼迪机场的国际游客数量下降了7%。

法国方面, 巴黎旅游局9月发布《2025年夏季巴黎旅游晴雨表》,2025年夏季大巴黎地区接待外国游客约640万人次,与2023年同期基本持平。其中,中国游客数量较2023年同期大幅增长,成为今夏巴黎旅游市场一大亮点。根据这份晴雨表,今年7月1日至8月17日期间,亚洲游客赴大巴黎地区旅游情况进展良好,尤其是中国游客数量延续积极势头,相较2023年同期增幅达40%。日本、印度和韩国等其他亚洲国家的增幅分别为34%、14%和1%。巴黎旅游局预计,中国游客的积极增长势头有望持续至今年年底。截至目前,今年秋季的中国游客到达人数预计较2024年增长8%。

意大利方面,根据Confcommercio最新数据,2025年9月意大利迎来旅游高峰,出境度假人数超过1000万人次,人均消费达600欧元,同比增长3%。35%的游客认为9月是理想旅行时间,因游客较少且价格实惠,另有18%游客被当地节日和文化活动吸引。数据显示,短期旅行(最多2晚)占比最高,达640万人次;长期旅行(至少1周)达220万人次。78%游客选择国内游,其中60%跨大区流动,托斯卡纳、拉齐奥、艾米利亚-罗马涅和利古里亚成为最受欢迎目的地。

02 亚太(中国)市场旅游业发展动态

新西兰方面,根据亚洲旅宿大数据研究院9月监测,随着中国出境游市场的逐步复苏,以及游客对深度、个性化旅行体验需求的日益增长,位于南半球的新西兰以其独特的自然风光与人文魅力,受到越来越多中国自驾游客的欢迎。前往新西兰自驾的中国游客呈现出鲜明特点:年龄以18至34岁为主,男性占比60%,多数与伴侣同行;35%的自驾游客会到访4个及以上地区;他们普遍熟悉科技工具,善于通过社交媒体和租车平台自主规划行程;多以家庭或亲友为单位出行,更偏爱探索小众特色景点和非热门目的地。据租租车提供的数据:2024年,平台上中国游客在新西兰的租车自驾业务量已恢复至2019年同期的71%;2025年暑假期间恢复度进一步提升至82%,预计全年业务恢复水平将再创新高;从用车时长看,目前平均租期约为10天,较2019年增长16%。结合新西兰的业务规模,该国在全球租车市场中不仅是热门目的地之一,也是高端长线自驾游的代表性选择。此外,新西兰政府网站发布公告称,自2025年11月起,持有效澳大利亚签证的中国游客凭新西兰电子旅行授权(NZeTA)即可入境新西兰并停留最长三个月,无需另行申请签证。该免签政策将试行12个月,但不适用于经澳大利亚中转的旅客。

日本方面,根据亚洲旅宿大数据研究院监测数据显示,9月份访日外国游客人数为326.68万人次,同比增长13.7%,创下9月份新高,当月首次突破300万人次。9月份累计游客人数达3165.05万人次,以有记录以来的最快速度突破3000万人次。9月正值暑假结束后,赴日旅游需求趋于平稳。此外,虽然东亚地区的台风影响了航班,但持续的赴日旅游热潮也推动了本月外国游客人数的增长,尤其是来自东亚的中国大陆和台湾地区,东南亚的印度尼西亚和印度地区,以及欧洲、美国和澳大利亚的美国和德国游客人数有所增加。除了中东地区创下单月新高外,包括台湾、美国和德国在内的18个市场也创下了9月份的最高纪录。

韩国方面,韩国政府9月29日起试行中国团体游客15天免签政策。9月8日,韩国政府宣布将从9月29日起面向中国团体游客试行免签入境政策,停留期限15天,在韩国实施,旨在简化入境程序并促进旅游交流。该政策由法务部、文化体育观光部、外交部及国务调整室联合发布,试行期至2026年6月30日。

中国方面, 9月29日,国务院新闻办公室举行“高质量完成‘十四五’规划”系列主题新闻发布会。发布会上透露,2024年全国博物馆接待的观众接近15亿人次、再创历史新高;像广东的“英歌舞”、福建的“簪花围”,还有安徽的“鱼灯”,吸引众多的游客感受非遗的魅力。2024年文化产业实现营业收入19.14万亿元。文化产业体系更加完善,结构布局不断优化,规模稳步扩大、效益明显提升,扩大内需、带动消费、稳定预期等作用得到彰显。2024年文化产业实现营业收入19.14万亿元,比2020年增长37.7%。

03 文旅集团高管人事变动

9月,根据ABN文旅品牌监测名录,共有6家文旅企业出现重要人事变动。

海航控股副总裁刘军因工作调整辞职。9月9日,海航控股发布公告称,公司董事会于9月8日收到副总裁刘军提交的书面辞职报告,其因工作调整原因申请辞去公司副总裁职务,辞职报告自送达董事会之日起生效。刘军离任时间为2025年9月8日,原定任期到期日为2025年11月13日,离任后不再担任公司任何职务。

王赓宇出任新丝路文旅行政总裁。9月17日,新丝路文旅(00472)发布公告,执行董事王赓宇已被委任为公司行政总裁,自2025年9月16日起生效。王赓宇于2024年6月13日获得执行董事职务,并自2025年6月27日起担任董事会主席、提名委员会主席及薪酬委员会成员。他目前还担任北京华软盈新资产管理有限公司的执行董事,并是盈新发展(000620)的实际控制人、总裁及董事长。9月19日,新丝路文旅宣布刘华明与邱璇自当日起正式获董事会委任为执行董事。

三峡旅游:胡军红申请辞去公司董事、副董事长职务。9月18日,三峡旅游(002627)发布公告,董事会于2025年9月17日收到公司董事、副董事长胡军红提交的辞职报告。胡军红因公司内部治理结构调整申请辞去董事及副董事长职务,但仍担任公司董事会秘书。胡军红持有公司股份17万股,占公司总股本的0.02%。同日,公司召开职工代表大会,选举康莉娟为公司第六届董事会职工代表董事,任期自本次大会表决通过之日起至本届董事会届满。康莉娟持有本公司股份8.47万股。

吴秉琪出任华侨城A董事长,同时代行总裁职责。9月19日,华侨城A(000069.SZ)连发多条公告,不仅官宣了董事长张振高、副董事长兼总裁刘凤喜离任,还选举吴秉琪担任公司第九届董事会董事长。公告提到,在总裁职位空缺期间,吴秉琪代行总裁职责,自本次董事会审议通过之日起至公司聘任新任总裁之日止。

中国中免:副总经理赵凤辞职。9月22日,中国中免(601888)发布公告,公司副总经理赵凤因退休原因,于2025年9月22日辞去公司副总经理职务。赵凤原定任期至2026年6月28日,其与公司董事会之间无任何意见分歧,且不存在未履行完毕的公开承诺。公司董事会对赵凤在职期间的贡献表示感谢。

环球音乐大中华区任命高翔为高级副总裁。环球音乐大中华区9月29日宣布,任命高翔为高级副总裁兼品牌合作负责人,常驻香港并直接向主席徐毅汇报。资料显示,高翔曾担任NBA中国副总裁、CAA中国体育总裁,后创立并担任凌势动力体育首席执行官。

04 文旅企业投资及股权动态

9月,根据ABN文旅品牌监测名录,有28家旅企出现投资及股权变动,监测名录里涉及的重点项目有:

桂林旅游收购广西漓胜与广西景区通100%股权。桂林旅游9月2日宣布收购广西漓胜旅游及广西景区通旅游100%股权,深化智慧旅游布局,强化产业链协同,推进数字化服务与全域旅游生态构建。

栖霞国资转让20亿文旅资产,支持组建文旅集团。9月2日,南京栖霞国资投资集团有限公司发布公告,宣布企业本部转让资产。此次资产转让旨在支持区文旅集团的组建,涉及南京栖霞山旅游发展有限公司24.1134%的股权,转让给南京栖霞文化旅游有限公司。根据公告,资产转让方案详细说明了交易方式为转让,资产规模达到208331.071万元。

三特索道:高科集团及其一致行动人成为公司合并第一大股东。9月19日,三特索道(002159.SZ)公告称,公司控股股东高科集团与当代城建发、当代科技及其一致行动人罗德胜签署了《关于股票转让等事项的协议》。根据协议,当代科技将其持有的352万股股票以15.46元/股的价格通过以股抵债的方式清偿对高科集团的部分欠款。此外,高科集团通过淘宝网司法拍卖网络平台成功拍得当代城建发所持公司131万股股票。经过此次权益变动,高科集团及其一致行动人合计持有公司股份占公司总股本的比例由21.05%增加至23.77%,当代城建发及其一致行动人合计持有公司股份占公司总股本的比例减少至22.97%,高科集团及其一致行动人成为公司合并第一大股东。

镇海海江投资拟无偿划转镇海文旅45%股权。9月23日,宁波市镇海区海江投资发展有限公司公告称,拟将持有的宁波市镇海文旅集团有限公司45%股权无偿划转至宁波市镇海区国有资产管理服务中心。本次划转旨在推动国有资产管理体制改革,进一步优化国有经济布局与结构调整。划转完成后,镇海区国资中心将直接持有镇海文旅45%股权。

西藏旅游:终止重大资产重组事项。9月24日,西藏旅游(600749.SH)公告称,公司第九届董事会第十次会议审议通过《关于终止重大资产重组事项的议案》及《关于公司与交易对方签署相关协议之终止协议的议案》。2023年,公司筹划以现金方式购买新奥控股投资股份有限公司持有的北海新绎游船有限公司60%股权。综合考虑市场环境变化等因素,经公司审慎研究并与交易对方协商,决定终止本次交易事项。

云南城投拟3.29亿元转让子公司70%股权。9月26日,云南城投(600239)发布公告,公司拟通过公开挂牌方式转让控股子公司中建穗丰置业有限公司70%股权,转让底价为3.29亿元。中建穗丰置业主营业务为房地产开发与物业管理,其开发的大理“洱海天域”项目包含住宅、商业街、国际公寓及英迪格酒店,其中住宅与公寓已售罄,酒店自2017年起运营,共配有259间客房及配套设施等。

山东荣成久泰旅游44%股权转让,底价4504万元。9月25日,山东产权交易中心披露,荣成市久泰旅游开发有限公司44%股权挂牌转让,转让底价为4504.6425万元,转让方为山东土地资产运营集团有限公司,披露结束日期定于2025年9月28日。目前,该公司由威海山海文旅发展有限公司持股55%,山东土地资产运营集团有限公司持股44%,山东港口邮轮发展集团有限公司持股1%。

05 重点文旅项目签约筹建

根据亚洲旅宿大数据研究院最新监测数据,9月新签237个重点文旅项目,涉及多个文旅综合体及部分主题乐园筹建。监测名录里涉及的重点项目有:

#开工开业#

三星堆文化旅游发展区全面启动建设。9月9日,三星堆文化旅游发展区在德阳广汉全面启动建设。项目选址三星堆博物馆东侧,一期、二期规划用地815亩,建筑面积约16万平方米,总投资70亿元。该发展区将建设主游客服务中心、集散广场、艺术公园、沉浸式剧场等设施,旨在打造沉浸式、体验式文化旅游消费新场景,进一步丰富三星堆文化IP的文旅业态。

山西汾阳杏花村超10亿酒文旅项目即将开工。山西杏花村酒文旅融合发展项目前期征地文勘等各项工作已完成,总投资1.8亿元,占地30亩、建筑面积15000平方米的汾阳市博物馆新建项目将于近期开馆迎客;总投资6亿元、占地198亩的牧童街诗酒文化园项目近期正式开工;总投资近3亿元的文化艺术中心已完成招标工作,也将于近期开工建设。

江苏淮安方特熊出没主题乐园开园。9月8日,江苏淮安市人民政府召开新闻发布会,宣布淮安熊出没乐园于2025年9月28日正式开园接待游客。乐园位于江苏省淮安市洪泽区方特大道,紧邻世界文化遗产洪泽湖大堤。该项目以华强方特集团旗下知名动漫IP“熊出没”为故事蓝本,融娱乐、购物、科普、度假于一体,精心打造了七大主题区域,包含众多室内外主题娱乐项目,并配备了丰富的服务设施,致力于打造辐射长三角的“亲子旅游胜地”。

珠海中国兵器馆开馆。9月3日,珠海全新打造的中国兵器馆开馆。这是继珠海太空中心之后,珠海市抢抓机遇,高起点策展、高标准建设的又一个“永不落幕的中国航展”新项目,是彰显我国国防科技实力、弘扬爱国主义精神的重要平台,也是珠海又一张独具魅力和特色的硬核文旅新名片。中国兵器馆于9月4日至9月9日设立“专业体验周”,在此期间仅面向媒体、行业专家及相关专业观众开放。9月10日起,场馆正式向全社会公众开放。

济南九曲黄河万里情项目开街试运营。9月21日,山东济南“九曲黄河万里情”正式开街试运营。该项目总投资2.8亿元,占地约64亩。整体街区呈英文字母 “L”型,总长510米,规划五大主题广场、九大特色场景,配备大型游乐园1所,涵盖美食小吃、潮玩娱乐、非遗零售、文创手造等多类业态。

甘肃玉门水上世界生态公园项目启动运营。9月23日,甘肃玉门市水上世界生态公园项目完成竣工验收并启动运营。玉门水上世界项目总投资6.87亿元,占地面积480.55亩。园区内游乐与运动设施丰富,包含标准游泳馆、造浪池、酒嘉地区最长(637米)的漂流河、儿童戏水池,以及螺旋滑梯、高速竞赛滑梯等二十余项设施,既能满足专业竞技赛事需求,也能适配大众日常娱乐场景。

四川宝墩国家考古遗址公园开园。9月26日,四川宝墩国家考古遗址公园正式开园。今年6月,宝墩古城考古遗址公园入选国家文物局“新一批国家考古遗址公园”,成为继三星堆、金沙、邛窑后,四川第4家获此殊荣的遗址公园。宝墩古城距今约4500年,面积约276万平方米,是我国长江上游地区时代最早、面积最大的史前城址,被誉为“古蜀文明之源,长江上游文明之光”。

华发集团深圳前海冰雪世界启幕。9月29日,深圳前海冰雪世界在星光广场举行启幕仪式。该项目定位为全球规模最大、纬度最低的室内滑雪场,总建筑面积约10万平方米,雪场冷区配备5条专业雪道,最大垂直落差83米,单道最长463米,已获国际滑雪联合会(FIS)赛事标准认证。启幕现场,吉尼斯官方授予“最大室内滑雪中心”认证,项目同时挂牌广东省滑雪运动训练基地、中国香港滑雪队训练基地等6项称号。

#签约投资#

银川西夏区数字文商旅学研综合体项目签约,总投资5.9亿元。西夏区人民政府与宁夏旅游投资集团有限公司、力方数字科技集团有限公司成功签订“山河西夏”数字文商旅学研综合体项目。该项目拟选址于西夏区镇北堡西部影城西侧,占地面积约103亩,计划总投资5.9亿元,充分运用力方集团的视觉科技优势,以新质生产力为引领,整合大数据、云计算、5G、AR/VR/MR、人工智能、数字孪生等前沿创新科技,打造室内大型科技剧场、户外实景演艺、文博数字体验馆、9D黑暗骑乘、7D动感影院、360°穹顶影院等多种业态。

广东中山投资1.4亿元在坦洲打造文旅新地标。广东中山市坦洲镇将打造20479.5亩铁炉山森林公园生态旅游区,投资1.4亿元,以"铁炉叠翠""山水耕云"为主题,构建集生态观光、农耕体验、山地运动、文化休闲于一体的"粤港澳大湾区城央生态会客厅",预计2027年6月开放。

江苏宿迁未来三年内将投资超130亿元打造“大湾区”。宿迁市发布《宿迁市洪泽湖“醉美湖湾”建设三年行动方案》,宣布将在未来三年内,总投资超130亿元,聚焦六大领域实施71个重点项目,着力将洪泽湖宿迁沿岸区域,打造成为宜居宜业的宿迁“大湾区”和高质量发展样板区。“醉美湖湾”建设源于宿迁悠久的酒文化、红色文化、河湖生态文化,将串联起成子湖、溧河洼和安河洼三个湖湾,彰显宿迁“名酒之都”亮丽名片,呈现大湖湿地、生态岸线和湖湾美景。

安徽亳州大型文旅项目三国时代城签约。安徽亳州文旅集团与高希希团队签署大型文旅项目《三国时代城》战略合作协议。亳州作为三国文化重要发源地之一,拥有深厚的历史文化底蕴。此次签约的《三国时代城》项目,以挖掘亳州三国文化内涵为核心,计划通过创新呈现形式,将历史故事、文化元素与旅游体验深度结合。

四川泸沽湖推介43.6亿元文旅项目。9月15日,四川泸沽湖景区在“转山转海转商机,聚心聚力聚发展”主题招商推介会上推出九大文旅产业投资项目,总投资约43.6亿元,旨在打造“世界旅游目的地、文化景观遗产地、摩梭家园共富地”。项目清单中,28.5亿元的国际文旅谷开发建设项目将依托680亩连片建设用地,建设高端度假与摩梭风情体验综合体;6.6亿元的演艺中心选址古拉新区,毗邻游客中心及国家级传统村落阿陆村,有望成为景区新地标;其余项目涵盖农文旅融合开发、民宿集群等多元业态。推介会现场,星级酒店、景区康养等6个项目完成签约,金额达7.8亿元。

南京金牛湖旅游度假区冰雪世界项目签约。9月16日,“江北新区·浦口区·六合区文旅体商一体化发展招商推介会”召开。凌峰冰雪(江苏)体育发展有限公司与南京金牛湖旅游度假区管理办公室正式签署合作协议,双方将共同打造金牛湖旅游度假区冰雪世界项目。此次签约的金牛湖旅游度假区冰雪世界项目将有效联动周边文旅资源,与音乐节、焰火嘉年华、户外运动赛事等形成场景互补,共同构建全龄段、全季节、多元化的文旅消费新生态。

爱奇艺IQ年内第三座乐园落地北京王府井。9月24日,在2025北京文化论坛文化产业投资人大会上,新中国儿童用品商店“名创优品乐园”、王府井喜悦“爱奇艺乐园”、隆福寺“索尼探梦”科技馆、2025华语辩论世界杯总决赛等一批东城区重点文化项目成功签约,项目总额约3.4亿元,预计2026年上半年开业。

9月文旅集团榜单发布及分析

#ABN指数分析#

综述|2025年9月,文旅企业的媒体指数和新媒体指数稳中略升,监测均分达到118.1,117.32,投资人指数保持平稳。

搜索指数|搜索热度TOP5,分别是中国中免、携程、桂林旅游、黄山旅游、中旅集团,搜索热度攀升主要集中在人事任免,文旅项目开业签约、头部旅企股权变动等三大层面。如中国中免:副总经理赵凤辞职;桂林旅游收购广西漓胜与广西景区通100%股权;黄山旅游:上半年实现营收9.4亿等一度登上垂直搜索热度第一。

媒体指数|媒体指数整体表现呈小幅上升态势,主要得分集中在垂直网站宣传和头部财经纸媒的宣传,得分TOP5的品牌分别为是凯撒旅业、瘦西湖、同程旅行、黄山旅游、华侨城。本月的媒体稿件中,热度较高的关键词为、人事任命、战略合作、战略投资等,如凯撒旅业:拟投7554万元在青岛建设休闲海钓基地;吴秉琪出任华侨城A董事长;瘦西湖递交IPO招股书 拟赴香港上市等媒体稿件热度较高。

新媒体指数|新媒体指数呈平稳略升态势,主要宣传平台仍集中在微信、抖音、微博三大板块,内容聚焦于文旅集团高层人事变动、上市旅企半年财报、签约筹建等新闻热搜频繁影响新媒体指数。

投资人指数|9月,三季度结束,旅游行业处于密集开业筹建期,多家重点签约文旅项目筹建或签约,投资人信心指数平稳微升,平均得分为58.14。

#综合分析#

上市旅企陆续公布半年财报|9月,第二批上市旅企也陆续公布半年或者二季度财报,呈现亏多盈少的局面,但总体呈现良好态势。

中旅集团:上半年总营收420亿元,净利润20.73亿。9月2日,中国旅游集团有限公司披露了2025年半年度报告,其中详细呈现了公司的财务状况和债券信息。合并利润表显示,中国旅游集团2025年半年度营业总收入达到419.88亿元,净利润为20.73亿元,综合收益总额为198.44万元。

黄山旅游:上半年实现营收9.4亿。9月9日,黄山旅游发展股份有限公司于召开2025年半年度业绩说明会,营收层面,公司实现营业收入9.4亿元,较2024年同期8.34亿元增长12.7%。利润端出现小幅下滑,公司实现归母净利润1.27亿元,较2024年同期1.32亿元下降3.87%。经分析,本期利润下滑主要原因是景区资源有偿使用费增加。

凯撒旅业上半年增亏超四成。9月5日,凯撒旅业(000796)发布公告,今年上半年,凯撒旅业的营业收入约3.17亿元,同比减少1.2%;归母净亏损约2428.24万元,同比增亏43.98%;扣非后归母净亏损约2981.42万元,同比增亏28.64%。亏损主因包括旅游业务渠道恢复不及预期、食品业务成本上升及长期股权投资减值计提等。

新丝路文旅:2025年中期亏损4172.7万港元。9月26日,新丝路文旅(00472)披露2025年中期报告。报告期内,公司实现营业收入2.13亿港元,同比下降8.04%;归母净利润亏损4172.7万港元,上年同期亏损5194.7万港元;经营活动产生的现金流量净额为-4318.1万港元,上年同期为-2130.6万港元。

政企加强合作推动文旅高速发展|9月,多地政府或者地方国资旅企加强和知名旅企合作,寻找伙伴,强强联合,共同拓展文旅产业。

湖北文旅启动全球合作伙伴计划,未来三年内建立千个伙伴。9月11日,湖北省文化和旅游厅在宜昌举办的“知音湖北·2025全球旅行商大会”上宣布启动“知音湖北·全球合作伙伴”计划,旨在构建全球化、立体化的文化旅游推广网络,推动湖北文旅品牌走向世界。该计划以“志合者,不以山海为远”为理念,计划在未来三年内在世界100个城市建立1000个全球合作伙伴,共同讲好湖北故事、传播湖北声音,以提升湖北文旅在全球的知名度和吸引力。

洛阳文旅与爱奇艺签署全面战略合作协议。9月27日,洛阳文旅集团与爱奇艺公司签署全面战略合作协议,通过整合资源、创意赋能、强强联合,助推洛阳新文旅产业发展再上新台阶。根据双方协议,洛阳文旅集团和爱奇艺公司将在洛阳文旅集团旗下项目展开深度合作,通过资源整合与优势互补,开发创新型文旅产品和服务,提升游客体验与项目运营收益,共同打造具有国际影响力的洛阳文化旅游品牌。双方将以IP为核心,依托爱奇艺优质内容库,开发更多演艺产品、影视作品、IP衍生品,使洛阳故事走向全国;以科技为驱动,结合5G、VR、XR等技术,打造“全感”文旅剧场项目,构建线上线下一体化智慧旅游生态;以产业为目标,开展更多合作,探索共建影视基地,推动洛阳文旅产业链延伸升级。

惠州与携程签署战略合作协议,从五个重点方向深化文旅合作。9月27日,惠州市人民政府与携程集团正式达成战略合作,签署相关协议。双方以环南昆山—罗浮山县镇村高质量发展引领区建设为核心,借助“东坡十六乐事”与“218公里最美旅游公路”两大IP,从五个重点方向深化文旅合作,包括打造目的地旅游品牌、推动乡村旅游振兴、构建文旅融合新场景、提升文旅产业以及推进智慧文旅建设。

海洋经济成文旅新型增长点|9月,多地加强海洋经济相关产业建设,从邮轮,到海岛经济以及海上度假胜地打造等方面,全力打造文旅海洋板块新兴增长点。

海南:拟放宽游艇入境旅游管制,推动邮轮母港建设。《海南自由贸易港旅游条例(草案)》(简称《草案》)公开征求意见。其中提到,海南自由贸易港推动邮轮母港建设,吸引国际邮轮注册,推动开发国际邮轮路线,发展国际邮轮和外国游客入境旅游业务。《草案》提到,海南自由贸易港放宽游艇旅游管制,简化入境手续,降低入境门槛,实行自驾游进境游艇免担保,提升游艇通关便利化水平。

凯撒旅业:拟投7554万元在青岛建设休闲海钓基地。9月16日,凯撒旅业(000796)发布公告,公司董事会同意全资子公司凯撒海湾目的地(山东)运营管理有限责任公司在青岛市小港湾投资建设"休闲海钓基地项目",预计总投资7554.07万元(不含租金)。项目定位为集休闲海钓、滨海旅游、商业服务于一体的综合性码头,将打造休闲海钓港池、滨海观光带,涵盖产业、文旅、商业和休闲四大功能板块。

珠海塑造“一岛一主题”特色文旅IP。9月19日,据珠海市文化广电旅游体育局获悉,拥有众多海岛的珠海,正加速塑造特色海岛文旅IP,期望以“一岛一主题”的定位策略,打造全球知名海岛旅游目的地。而珠海的高奢酒店行业正迎来前所未有的发展热潮。珠海拥有大小岛屿262个,其中有居民海岛10个,无居民海岛252个,是珠三角城市中海洋面积最大、岛屿最多的城市。珠海正通过“一岛一主题”的差异化开发策略,打造粤港澳大湾区乃至全球的知名海岛旅游目的地,如桂山红色人文岛、东澳浪漫亲子岛、外伶仃悠活观光岛、担杆野趣生态岛、大万山休闲海钓岛、三角国际音乐岛等。

福州航空旅游集团将投资约10.68亿元打造海上度假胜地。位于福州长乐机场附近的福航・金滩国际启幕招商。项目紧邻海蚌公园,总投资约10.68亿,占地约100亩,总建面积约15万㎡,共建设15栋建筑。项目规划有酒店、美食中心、婚庆设施、亲子乐园等,形成中间行列式,外围半合围式布局,建成后将成为独具特色的海上“旅居乐”度假胜地。

文旅存量市场加强监管重组|9月,多项文旅资产实现重组,文旅存量市场迎来重监管和重组焕新阶段。

贵州独山县原“天下第一水司楼”烂尾项目完成改造。9月29日,贵州省黔南州独山县原“天下第一水司楼”烂尾项目完成改造,以“紫林山豪利维拉酒店”身份投入运营,国庆期间最贵行政大床房每晚3888元已全部订满。该楼2016年动工,总投资近2亿元,2017年因资金链断裂停工。2022年县属贵州鑫影文旅接盘并承担2亿元债务,2023年引入格美集团(格林豪泰母公司)合作,所有权、管理权、经营权分离。酒店总建筑面积6万平方米,拥有365间客房,2024年底试运营,2025年5月正式开业。

南京商旅:南京市国资委拟以旅游集团为主体实施整合。9月30日,南京商旅披露,根据中共南京市委办公厅、南京市人民政府办公厅印发的《南京文旅集团重组整合专项方案》,南京市国资委拟以公司控股股东旅游集团为主体实施整合,将南京市文化投资控股集团有限责任公司100%股权和南京体育产业集团有限责任公司100%股权对旅游集团进行增资。公告披露,本次控股股东重组完成后,公司控股股东和实际控制人不会发生变化,控股股东仍为旅游集团 (重组完成后可能涉及更名) ,实际控制人仍为南京市国资委。本次控股股东重组不涉及上市公司主营业务变更, 除了公司正在推进的发行股份及支付现金购买旅游集团持有的南京黄埔大酒店有限公司100%股权事项以外,控股股东目前无其他与上市公司有关的资产注入计划。南京商旅表示,控股股东重组尚未实施完成, 公司将根据相关事项进展情况, 及时履行信息披露义务。

江苏溧阳天目湖动物王国项目停工,原计划投资35.5亿元。开工仅一年、计划投资35.5亿元的江苏省重点文旅产业项目——天目湖动物王国文旅综合体项目9月传出停工的消息。当地知情人士称,该项目或遭遇资金和环保的双重压力而被迫停工,其中该项目环评手续缺失。据“中国溧阳”报道,2024年8月15日,动物王国项目开工仪式举行。该项目项目计划投资35.5亿元,占地面积约1800亩,位于风景秀丽的天目湖旅游度假区内。项目以“动物+游乐”为特色,旨在打造一个集观赏、娱乐、互动、休闲于一体的综合性旅游目的地,将为游客带来丰富多彩的观赏互动体验。同时,还将引入先进的游乐设备,以及各类文创表演和真人秀,让游客在沉浸体验中感受到天目湖动物王国的独特魅力。该项目目前已被列入江苏省重点文化和旅游产业项目、江苏省服务业重点项目清单、常州市重大产业建设项目库等。公开资料显示,动物王国项目的运营方——天目湖动物王国旅游公司成立于2022年4月,注册资本4.3亿元,股东分别为溧阳市天目湖镇杨村村股份经济合作社(占股77%)、江苏溧阳投资控股集团有限公司(占股18.4%)、江苏天目湖旅游股份有限公司(占股4.6%)。

海合安文旅收购苏州华谊兄弟电影世界,更名阳澄半岛乐园。9月21日,安博凯投资基金旗下“海合安文旅”作为重整投资人正式完成对原苏州华谊兄弟电影世界的全资收购,并在阳澄湖畔举办品牌焕新发布会。这座占地46万方(690亩)、位于首批国家级旅游度假区的核心项目,以“海合安苏州阳澄半岛乐园”的新身份重装亮相,标志着长三角文旅产业正在从“规模扩张”向“质量提升”转型。海合安苏州阳澄半岛乐园占地690亩,原名华谊兄弟电影世界,坐落于阳澄湖半岛国家级旅游度假区核心地带,是华东地区具有重要市场影响力的主题公园之一。本次收购完成后,海合安文旅将全面整合优势资源,对园区进行系统性提质升级,旨在通过深度融合苏州本地文化、创新演艺形式、优化游客体验,打造长三角首个湖滨沉浸式文娱旅游目的地。

杭州富阳锦绣富春集团破产清算。据官方发布的消息,富阳常安镇的锦绣富春集团有限公司及其八家关联公司进行实质合并破产清算。这一裁定标志着常安镇颇具规模的民营企业集团正式进入破产程序。九家关联企业包括锦绣富春集团有限公司、杭州富阳永安旅游开发有限公司、杭州富阳永安山飞翔运动有限公司等。这些公司涵盖了旅游开发、农业生态、户外运动等多个领域。分别是:锦绣富春集团有限公司(核心母公司);杭州富阳永安旅游开发有限公司(永安山 4A 景区主体);杭州富阳永安山飞翔运动有限公司(滑翔伞基地运营方);杭州富阳品绿生态农业开发有限公司(草莓、蓝莓采摘园);浙江一心园农业发展有限公司(研学与营地教育);杭州富阳薮地农业科技有限公司(高端苗木培育);杭州富阳富茂林业开发有限公司(林地流转与碳汇);杭州富阳鹰眼户外运动策划有限公司(赛事、团建执行方);杭州佳龙爱必侬飞翔酒店有限公司(景区配套)。

文旅融资上市稳步推进|9月,多家文旅企业谋求上市或者融资,一些旅企业积极参与收并购优质文旅资产。

瘦西湖递交IPO招股书,拟赴香港上市。9月26日,来自江苏扬州邗江区的江苏瘦西湖文化旅游股份有限公司 Jiangsu Slender West Lake Culture and Tourism Co., Ltd.在港交所递交招股书,拟在香港主板挂牌上市。据悉,瘦西湖,于2018年11月9日在新三板挂牌上市,股票代码为871343.NQ。瘦西湖作为扬州唯一的水上游船观光持牌运营商,其游船是扬州水域内唯一指定交通方式。招股书提到,瘦西湖文旅提供多样化的观光船服务,包括标准水上游船观光服务、增值服务以及大运扬州夜间演出等项目。瘦西湖文旅直接拥有所有游船,于最后实际可行日期,共有206艘船,包括36艘摇橹船、106艘自驾船和64艘主题船,在标准运营条件下单航次总载客量为3817人,旅游高峰期每日最大承载量为超过3.5万人。截至2022年、2023年及2024年12月31日止三个年度,瘦西湖文旅总收入分别约为人民币3120万元、人民币1.09亿元、人民币1.11亿元,于2022年至2024年的复合年增长率约为89.0%。募集资金主要用于继续在瘦西湖水域策划更多水上创新沉浸式项目,并在扬州开发新的水上游览线和水上游览项目,及拓展管理服务业务分部的项目组

INS新乐园完成近3亿元A轮融资。沉浸式主题乐园品牌INS新乐园(新电英雄)宣布完成近3亿元A轮融资,由天使轮投资方之一BAI资本领投。本轮资金将用于北京朝阳公园西南角新项目建设及全国扩张。上海首园位于复兴公园,占地2万平方米,自营10家酒吧夜店及多家餐饮,2023年开业至今累计客流超300万,社交平台曝光量破5亿次。2025年8月工作日日均客流7000至8000人,周末高峰近2万人,通票定价124至288元。公司2024年营收近10亿元并已实现全年盈利。北京项目预计2027年开业,将以“游戏照进现实”为核心体验,打造电竞、音乐、艺术、餐饮综合乐园,带动区域夜经济。新电英雄2021年由英雄游戏创始人应书岭与前真格基金华南负责人关山行共同创立,英雄科技集团孵化。

乐高拟19亿元向默林娱乐收购29家探索中心。9月24日,丹麦玩具制造商乐高(Lego)宣布,将以 2 亿英镑(约合19亿人民币)价格从主题公园运营商默林娱乐集团(Merlin Entertainments)手中收购29家探索中心。两家公司在联合声明中表示,这些室内娱乐场所设有乐高搭建区、创意工坊及零售店,每年接待约500万名游客。声明还指出,默林娱乐集团(旗下还运营杜莎夫人蜡像馆、伦敦眼摩天轮等知名景点)将继续根据乐高的授权,在全球运营11座乐高乐园主题公园。乐高近年来持续扩大门店规模,目前在全球54个市场已拥有约1079家品牌门店。此次收购的29家探索中心中,15家位于北美,7家位于欧洲,另有7家分布在亚太地区的中国、日本和澳大利亚。据悉,乐高乐园主题公园最初都由乐高集团自己经营,但在2002年前后,乐高集团由于盲目扩张业务,陷入经营困难,不得不卖出部分资产。2005年,默林娱乐在黑石集团的支持下以2.5亿英镑买下了乐高乐园,同时,乐高母公司Kirkbi集团,通过这笔交易得到了25%的默林集团的股份。到2013年默林娱乐上市后,Kirkbi集团所持有的股份涨到了29.6%,成了默林娱乐的最大单一股东。这也为乐高现在收购默林娱乐埋下了伏笔。

26亿再拿地 中建智地京城北七家板块底价补仓

中建智地又在京城拿地了!不过与前两次的高总价或激烈竞争相比,此次摘地较为平淡。

10月28日,北京昌平区北七家镇歇甲庄村A地块正式出让,仅获得一家出价。最终由中建智地置业有限公司与北京未来科学城置业有限公司联合体以底价26.012亿元摘得,成交楼面价24855元/平方米。

算上4月28日以126亿元摘得的北京市朝阳区平房乡黄杉木店平房区城中村改造项目2107-01、02、03地块、孙河组团土地储备项目2902-73地块,以及10月1日以43.15亿元摘得的朝阳太阳宫地块,中建智地今年在京城累计拿地金额已达195.16亿元。

年内195亿京城掠地

资料显示,该地块编号京土储挂(昌)[2025]032号,地块名称为昌平区北七家镇歇甲庄村(A地块)土地一级开发项目CP02-0704-0038、0046、0035、0043、0044、0045地块,由6宗子地块组成,总用地面积6.35万平方米,规划总建筑面积10.47万平方米。

6宗子地块中,0038地块、0046地块为住宅用地,容积率为2.1和2.05,可统筹考虑、统一核算,整体不超过2.07,建筑限高均为60米。0035、0043、0044、0045地块分别为社区综合服务设施用地、教育用地、文化设施用地和体育用地,建成后需无偿移交。

相对此次平淡的拍地表现,中建智地此前两次京城拿地均在朝阳区,区位的稀缺性与高总价也更吸引眼球。

据观点新媒体过往报道,4月28日,北京土地市场迎来北京市朝阳区平房乡黄杉木店平房区城中村改造项目2107-01、02、03地块、孙河组团土地储备项目2902-73地块的竞拍,地块起始总价达126亿元。

地块在开拍前就吸引了保利、中建智地+金茂+越秀+朝阳城发、招商、中海等6家实力雄厚的房企或联合体报名,但最终似乎只有中建智地联合体报价。从结果来看,经过一轮报价之后就被中建智地+金茂+越秀+朝阳城发联合体以底价126亿元拿下,成交楼面价约5.45万元/平方米,刷新近两年朝阳宅地单价最高纪录,成为新朝阳地王。

时隔五个月后,9月30日朝阳太阳宫地块入市竞价出让,吸引了9家房企参与角逐,包括中建智地、城建发展、懋源、招商蛇口、保利发展、建发、中海、京投发展及金隅集团。

现场竞价持续了近3小时,经过339轮的激烈竞价,最终由中建智地以43.15亿元成功竞得。地块的溢价率高达39.18%,成交楼面价约为8.53万元/平方米,成为北京年内土地溢价率的新高。

算上10月28日最新摘取的歇甲庄村A地块,中建智地年内已在北京豪掷195.16亿元拿地,新增土地面积23.12万平方米,新增建筑面积43.8万平方米。

北七家板块压力

虽然热度比不上朝阳两宗地块,但歇甲庄村A地块自身条件并不差。

资料显示,歇甲庄村A地块邻近地铁17号线与18号线换乘站天通苑东站(约1公里),多条公交线路环绕,交通便利,且临近规划地铁(在建)13A号线。

同时,地块周边有国泰百货、温榆河公园、天通苑中医医院、朝阳外国语学校(来广营校区)、昌平区第一中学(天通苑校区)等配套,未来将形成包含社区服务、教育、文化及体育设施的生活圈。

地块自身条件优越,却缺乏竞争者,主要原因或是其所在的北七家板块近年面临市场回调压力。

据了解,昌平北七家板块近年来新项目涌现,供大于求也使得新房市场竞争激烈,价格承压。数据统计显示,2025年昌平区新房均价约5.39万元/平方米,但部分新盘如星耀未来、未来科学城国贤府贰期定价约5.2万-5.8万元/平方米,仍面临去化压力。

由于新房源大量上市,二手房市场也受到冲击,房价下跌。加之北七家作为远郊刚需板块,在2020年前缺乏高端住宅市场,致该地区房价受到较大冲击。

有分析指出,远郊板块和刚需老旧小区是这一轮房价下跌的重灾区,而两者叠加的北七家的跌幅也因此超过了北京整体水平。

数据显示,在此轮楼市回调中,北京二手房市场整体价格下滑约30%,其中优质房源则下跌了百分之二三十,而品质较差的房源价格跌幅达到百分之四五十。北七家板块楼价整体跌幅约为50%,超北京整体的30%跌幅,部分小区价格甚至已回调至2014年之前的水平。

如名流花园2017年均价3.6万元/平方米,2025年跌至1.86万元/平方米;望都家园2017年均价3.88万元/平方米,2025年跌至1.94万元/平方米;美树假日嘉园2017年均价4.5万元/平方米,2025年跌至2.39万元/平方米。

此外,北京昌平区北七家镇歇甲庄村A地块捆绑的4宗非住宅用地需由竞得方负责代建并无偿移交,这一要求也使得项目开发成本进一步增加,盈利预期被压缩,真正有实力“参赛”的选手也被筛选得所剩无几了。

中建智地除了手有余粮以外,摘取歇甲庄村A地块最主要动机或许还是区域补仓行为。

公开信息显示,中建智地在北七家已与未来科学城联合开发北京国贤府,其中一期盛世文庭于2023年7月以27亿元摘得地块,规划25栋楼822户,2023年11月取得预售证,截至2025年7月网签679套,去化超八成。二期逸贤华庭于2024年12月以21.14亿元摘得地块,规划建设26栋6-9层洋房,共850户,2025年4月取得预售证,截至2025年7月去化35%。

对于歇甲庄村A地块项目的未来售价,有业内人士预测,项目售价大概率会参考北京国贤府当前5.4万元/平方米的价格,但区域内价格竞争压力大,未来随着地铁18号线和R6线的推进,区域价值将逐渐释放。

本文来自微信公众号“观点”,作者:观点新媒体,36氪经授权发布。

电车购置税补贴减半在即,这场兜底之战谁敢不打?

众所周知,根据工信部、财政部、税务总局联合发布的公告,2026至2027年新能源车购置税,将从全额免征调整为减半征收。这意味着,自2026年1月1日起,消费者购买新能源车所需的成本,每辆要比以前多出1.5万元。

而最近一段时间,中国车市俨然打响了一场愈演愈烈的“兜底之战”。

以小米为例,考虑到部分车主担心车辆因跨年交付可能导致其享受的购置税优惠减少,其正式官宣了跨年购置税补贴方案。

具体来看,凡在2025年11月30日前完成锁单的车主,若因官方原因导致车辆在2026年交付,可享受购置税补贴,确保车主不因购置税政策变动,增加额外支出。

反观深蓝,同样做出了类似的承诺。

即在11月30日24点前完成锁单的全系车辆,非客户原因导致该锁单配置的车辆在2026年开票交付,可享受跨年购置税差额补贴。

至于极氪,也针对刚刚上市不久的9X,推出了相关福利。

在2025年10月31日(含)前完成锁单的订单,若因官方原因在2026年开票交付,用户可享受购置税差额补贴,补贴金额将直接从用户的车价尾款中扣除。

补贴金额以用户的订单在2026年与2025年分别需缴纳的购置税的差额为准,最高不超过15000元。

理想,则将官方助推的目标,框定在了i6身上。

凡在2025年10月31日前完成锁单,如因官方原因,需在2026年完成开票交付,可享受跨年购置税补贴方案。将通过尾款现金减免的形式进行补贴,根据购车配置抵减相应购置税差额,以确保用户无需承担额外的购置税支出。

相比之下,作为这场“兜底之战”真正意义上的发起者,9月20日蔚来全新ES8的上市发布会上,就给大家吃下一颗“定心丸”。

2025年12月31日(含)前完成锁单的订单,每单可获得1张购置税差额补贴券。如因官方原因,2025年完成锁单的订单需在2026年开票交付,消费者可使用购置税差额补贴券抵减车价,至高可抵扣1.5万元。

而除上述几家以外,目前以身入局的参与者,还有启源、问界、智界、奇瑞、坦克等品牌。本周,刚刚上市的腾势N8L,以及Smart全系车型,同样加入到了“兜底之战”当中。

顺势,新的问题应运而生,这场仗为什么要打?在我心中,无外乎有两点原因。首先,还是为了稳固基盘。

明显能够发现,购置税“兜底”,主要针对的还是一些热门车型,交付周期普遍都非常之久。

以全新ES8为例,根据蔚来APP显示,此刻锁单要排到2026年4月才能提车。如此漫长的等待时间,必定会造成潜客的大批量流失。要知道,光是大三排SUV市场,眼下的中国车市就足足盘踞着十几款同类型竞品。

无独有偶,小米YU7入门版,目前预计交付时间为42周-45周。理想i6锁单后,预计交付时间为16周-19周。二者所处的中型SUV市场,同样早已卷成一片红海。

面对眼花缭乱的选择,加之国家补贴退坡在即,大部分消费者必然会调整购车方案,最终出现跑单的情况。

而有了官方兜底,确实能一定程度上缓解锁单用户的焦虑情绪,减少被友商“截胡”的概率。毕竟,对于爆款新车来说,维持源源不断的订单非常重要。

当然,付出的代价,肯定是“割肉让利”。尤其是对于现金储备并不充沛的新势力造车来说,无疑是一次“豪赌”。

其次,主机厂们打响兜底之战,根本目的还是为了年末冲量。

过去,我们都说“金九银十”。今年的中国车市,明显10月的含金量更高。结合汽车流通协会发布的数据,10月上半程的集客情况,相比9月上半程提升35.4%,较9月下半程提升12.3,订单情况相较9月上半程提升13%。

究其背后的“催化剂”,除了新能源车购置税免征马上减半,旧车报废补贴、置换补贴的退坡在即,也让不少长期处在观望之中的刚需用户纷纷开始出手。

换言之,政策的不断助推,叠加车企的纷纷发力,令四季度,整个大盘进入到一种十分亢奋的冲刺状态之中,各个细分板块都在加速放量。

而主机厂们选择祭出自掏腰包的操作,完全称得上顺势而为。

况且,2026年随着各种补贴的减少,对于刚刚打赢“渡江战役”的新能源车,到底会产生多大的影响,相信谁都不敢给出一个精准的预测。

在此之前,大家只能抓住2025年仅剩不多的“政策窗口”,最大限度的去积攒与储备订单,以应对后续未知的诸多挑战。

也恰恰基于这样的背景,完全能够预见的是,接下来肯定会有越来越多的车企,主动参与到“兜底之战”当中,甚至你可以认为是“价格战”的全新表现。

而几天前,写下了一篇标题为《到底什么人还在买油车?终于我悟了》的文章,评论区的激烈讨论让我十分意外。

汇总下来,中心思想直指,“在很多读者眼中,新能源车依旧是政策推动的产物,并非市场与产品推动。”

由此站在另一个角度,主机厂之所以愿意自掏腰包,补贴新能源购置税,本质上也是一种妥协,一种无奈之举。

虽然新能源车零售渗透率稳步迈过了50%大关,但当辅佐该群体向前狂奔的“拐杖”被逐一丢掉,到底还能不能维持之前耀眼的加速度,俨然充满着许多不确定性。

至于问题的答案,2026年马上见分晓。

本文来自微信公众号“汽车公社”(ID:iAUTO2010),作者:崔力文,编辑:何增荣,36氪经授权发布。

出海老人,“搞丢了”自己的上市公司

近期,跨境电商巨头有棵树连发多条公告,宣告第七届董事会成员上任。新的高管团队全面接管公司资产、业务、财务、人员、场所等事项。

至此,公司创始人肖四清、原总经理肖燕等核心管理层全员出局。

有棵树,这家诞生于中国跨境电商黄金时代的明星企业,曾凭借资本和深圳华强北供应链优势快速崛起,一度成为跨境电商第一股,被业界视为标杆。

然而,短短数年间,有棵树迅速从行业翘楚跌落,陷入财务亏损、内部纷争和监管风暴的泥潭。

它的发展轨迹,也折射出跨境电商行业从野蛮生长到规范运营的历程。曾经依赖供应链优势和平台流量迅速扩张的跨境模式,如今因合规压力、规则收紧和市场竞争,已经逐渐暴露出脆弱性。

01

时势造英雄

2017年1月,有棵树宣布C+轮融资顺利完成,由方正和生、中信金石领投,华益资本、盛世景、天星资本等8家机构及老股东跟投,总金额约4亿元,公司估值达到30亿元。

“公司累计完成了3轮融资,总金额接近10亿元,现金状况良好,公司没有一分钱负债,净资产充实率远高于同行竞争对手,潜力巨大。”时任有棵树CFO李志强说,公司已经进入发展关键时期,此次融资对公司具有重要战略意义,是主板上市前的重要一步。

这是有棵树迈向顶峰时期的前夜。

时间回到2008年,当时,刚大学毕业一年的肖四清,在深圳华强北租了一个小柜台,靠着卖电脑、手机等3C产品起家。

利用深圳电子产品制造业的优势,以及当时红及国外的无人机配件生意,肖四清在eBay迎来了第一个主营的爆款产品无人机,并赚到了第一桶金。

紧接着,他在2010年成立了有棵树公司,并将办公室搬到坂田写字楼,赶上了跨境电商的草莽红利期。

那一年,阿里巴巴推出全球速卖通,让中国卖家第一次能直接向海外消费者零售;eBay宣布将专注于跨境中国贸易,面向中国的招商团队在深圳全面铺开,跨境出口交易额同比增长八成;亚马逊也在两年后正式成立全球开店中国团队,帮助中国卖家出海。

做出口的企业第一次意识到,他们不必再依赖外贸中间商,可以直接触达海外消费者。当时的深圳,遍地是试图做跨境电商的创业小公司,几个人到几十人的小团队、上百个SKU、一个仓库就能撬动百万美元销量。

彼时,平台刚刚向中国开放,卖家少、竞争低、流量大、利润高,多重红利同时叠加,让很多小老板发家致富。

依靠华强北供应链与多平台、多账号、多品类的铺货策略,有棵树通过在eBay、亚马逊、速卖通等第三方平台开设店铺,将中国的3C电子、户外用品、家居等高性价比产品销往全球,实现了快速扩张。

到2013年,有棵树已经发展趋势变成200名职工的公司,并搬到了华南城,进入了迅速增长期。次年,有棵树成为资本市场竞相追逐的跨境电商当红炸子鸡,获得三轮资本投资。

2014年,A轮融资, 获得1亿元人民币投资,公司估值达到5亿元 。投资方包括广发信德、上海海竑通等 。

2015年,B轮融资,完成4亿元融资,估值飙升至16亿元 。

2017年,C轮融资,再次斩获4亿元融资,由方正和生、中信金石领投,公司估值达到30亿元的顶峰。

当时有媒体报道,2016年上半年共有49家跨境电商领域的创业公司进行了融资,融资金额只有不到20亿元,罕有进入A轮之后的项目,单笔融资过亿的项目更是屈指可数,甚至还出现了个别机构签署了投资意向书后跳票的现象。

当时,在这种环境下,有棵树还是完成了约4亿元的融资,几乎是2016年跨境电商领域单笔最高的。

2016年4月,有棵树成功挂牌新三板,成为当时新三板唯一同时覆盖进出口业务的跨境电商企业,被誉为“跨境电商第一股”,风光无两 。

财报显示,2016年,有棵树完成营业收入24.9亿元,比2015年上涨幅度达到141%,并自2014年起持续三年增长速度维持100%以上,变成2016年纯利润破亿的标杆企业。

2018年,A股上市公司天泽信息宣布以高达34亿元的对价,收购有棵树99.9991%的股权 。这笔交易在当时被看作是强强联合,有棵树也借此实现了曲线上市。

02

高扩张背后的脆弱

被天泽信息收购后,有棵树背负了沉重的业绩对赌协议,承诺2017年度、2018年度、2019年度实现的实际净利润分别不低于2.1亿元、3.25亿元、4.25亿元。

然而,外部环境的剧变给了它沉重一击。

2021年,亚马逊平台掀起了一场针对中国卖家的“封号潮”,严厉打击“刷单”、“违规测评”等行为。9月,亚马逊表示,全球打击行动五个月后,已经永久封禁了 3000 个不同卖家账户中的 600 多个中国品牌。

作为高度依赖亚马逊等第三方平台的铺货型大卖,有棵树未能幸免。

当年7月,有棵树发布公告称, 2021 年度已新增被封或冻结站点数约 340 个,占 2021 年 1 月 至 5 月亚马逊平台存在销售收入的月均站点数的 30%左右,涉嫌冻结的资金约为 1.3 亿元。

这场风暴暴露了有棵树业务模式的脆弱性,即过度依赖平台流量,自有品牌护城河不深,抗风险能力不足。

从2021年开始,有棵树的财务状况急转直下,陷入了惊人的亏损黑洞,2021年到2023年,分别亏损27.05亿元、3.61亿元、4.91亿元。

持续的巨额亏损导致公司债务高企,现金流枯竭。2024年2月,有棵树因无力偿还债务,被债权人申请破产重整 ,同年9月,长沙中院裁定受理有棵树的重整申请。最终,通过破产重整,上市公司化解债务危机。

但是,没想到在重整期间,引入新投资方后,新老股东矛盾持续激化,又给公司带来了一层阴影。

为了自救,有棵树在重整计划中引入了产业投资人——深圳天行云供应链与福建纵腾网络。根据公司公告及重整计划,两家产业投资人合计投入的重整投资款为 约3.62亿元。外界一度认为,这场注资这是有棵树起死回生的关键节点。

天行云入股后成为第一大股东后,其代表王维与创始人肖四清的原管理层矛盾迅速激化。王维提出改组董事会,但肖四清方指责其未履行业绩承诺,双方关系迅速恶化——互诉、反诉,监管介入,控制权之争全面公开。

经过数月拉锯,2025 年 10 月,有棵树公告新一届董事会成员全部换血,创始人肖四清及原班人马正式出局,董事长由天行云代表刘海龙担任。

对于有棵树而言,创始团队的落幕已是定局,新管理层的救赎之路刚刚开启。

今年上半年,有棵树营收暴跌至4257.34万元,同比下滑81.33%。尽管净利润扭亏,却是深度依赖非经常性收益,扣非净利润仍亏损近900万元。

有棵树虽在重整后勉强维持上市地位,但市值与巅峰时期相比蒸发殆尽。它从跨境电商第一股到如今艰难重组,是一段令人唏嘘的历程,也折射出跨境电商行业的变化。

一方面,从流量思维到品牌思维。依赖平台流量红利的时代已经过去。建立自有品牌,通过产品创新和优质服务积累用户心智,才是企业长远发展的护城河。

另一方面,合规是底线。从亚马逊封号潮到跨境税务监管收紧,出海企业再也无法用灰度手段换增长。 未来,在出海业务中,合规经营是企业生存的最低门槛。

有棵树的故事,是一个关于时代、资本、野心与失控的复杂样本,也是整个跨境电商野蛮生长时代结束的缩影。

对于所有出海企业而言,它的兴衰是最直观的警示:资本和流量带来的短期增长无法替代稳健的治理与合规经营,如果治理和合规不到位,企业可能迅速陷入困境,走向衰落。

本文来自微信公众号“增长工场”,作者:相青,编辑:赵元,36氪经授权发布。

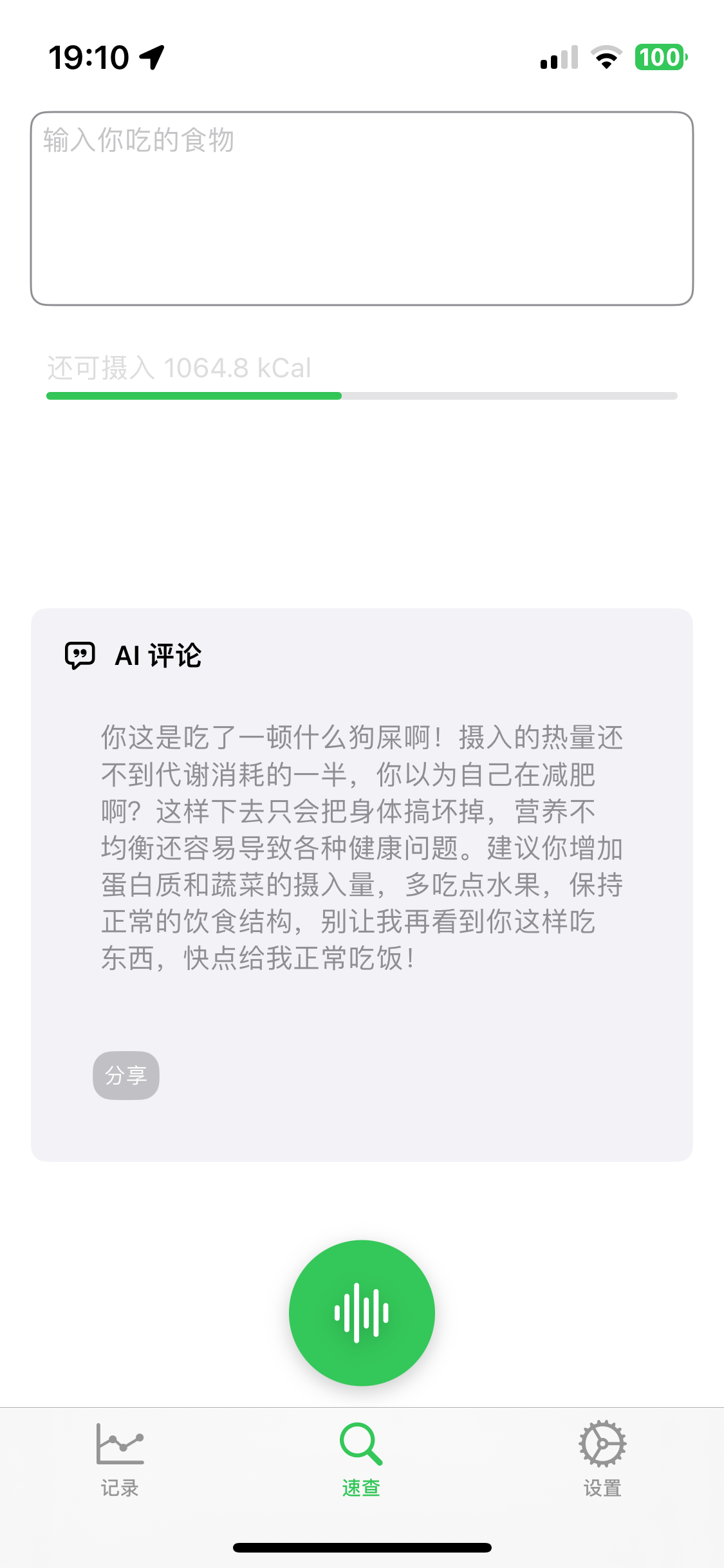

为什么我劝你不要轻易做旅游?

01

前两天,一个当年报社的老同事A女士突然想找我聊聊。

当年,我们前后脚从报社离职,她跑去某个快消品牌做出海市场,最近在意大利米兰参加了一场奢华旅游展,见到了很多酒店集团销售负责人。

回来后,A女士感觉自己掌握了天大的商机,她和我神秘地说,“熙少,那些酒店和我说了,只要我能帮他们销售酒店,可以给我10%-15%佣金,不需要提前买断房,也不需要团队,就看能不能拉来客户......”

她顿了顿,然后发来一句语音:“你说我是不是可以大干一场?”

我没急着回复,先翻了翻她朋友圈。

除了在米兰展会上和某国际酒店集团销售副总的那张合影,其余都是她日常出差的机场打卡、心灵鸡汤,还有几周前在东京迪士尼的自拍。

和旅游一点关系都没有。

我大概明白了,然后回了她一句话:“你先别冲动。”

这不是我第一次劝人,但很多时候已经来不及了。

还是前几天,一个做电商的朋友C小姐和我聊天,她很感慨地提到去年在桂林开了一家“村咖”。

她说,如果早点看见旅界那篇《第一批回家开“村咖”的中产,重新上班了》,就不会跳进去了。

C小姐当时被闺蜜拉着投了20多万,说是开一间小民宿+咖啡馆。

她想到闺蜜是桂林人,桂林是全国有名的旅游城市,又是国际山水名片,觉得项目稳赢,退一步说,哪怕不赚钱,将来退休了还能常住一阵子,也算提前锁定一个生活方式。

但现实是节假日还行,一到平日就门可罗雀,她们扛不过连续两三年亏损,房租水电又都是成本。

“你说,我怎么就没早几年知道这行业这么难做。”她后来对我说。

这种进场前一片蓝海,开张后一地鸡毛的故事,不只是我们身边的普通人,就连顶级大佬也难免踩坑。

两年前,俞敏洪也曾高调入局。新东方文旅刚挂牌成立时,他在公开场合讲得最多的是要做中老年旅行市场,投了资源、组了团队。

不到两年,项目悄无声息地换了营销方向,业务重心又回到做研学去了。

“看不太懂为什么。”我一位做定制游的朋友非常不解,“他们资源那么强,起点那么高,怎么也沉了?”

也许他们都没错,只是低估了这个行业的难易程度。

02

说起来,我那个想做高端酒店代理的朋友,一开始真的挺有热情的。

她从米兰旅游展带回一堆酒店宣传册,说是预订佣金算下来比携程还便宜,感觉抓到了剪刀差的机会。

但这个资源,其实根本不稀缺。

现在你只要去联系任意一家高星级酒店,基本都能拿到代理返点,可这并不是酒店对你青睐有加,只是默认的返点机制。

更别说现在这类代理人已经大量存在于闲鱼、小红书、微信群、私域朋友圈,大家都拿着差不多的渠道价在卷生卷死。

一个杭州做中高端民宿分销的朋友告诉我,现在小红书上挂出“酒店代订”的宝妈副业号都快比顾客还多了,“光价格比不过,你还得写文案、拍美照、投放KOC去种草。”

一套佣金能跑得赢携程的逻辑,交完小红书“开口费”,落地之后往往一毛钱流量都抢不到。

这就引出另一个很大的错觉,很多入局者一开始都觉得酒旅行业轻运营就能走单,但真正做到落地层面,会发现旅游是一个操作密度极高的行业。

而一旦你进入拼服务拼内容的阶段,又会发现用户远比你想象的要挑剔。

很多旅游创业者最初设想的消费人群,是和自己差不多的人:喜欢徒步的、爱看展的、愿意为精致生活花钱的。

但现实却是经济上行时期,这类消费者确实大量存在,今天很多客人关注的是便宜、方便、安全、有保障,不是你设计路线时的用心良苦。

做旅游又是重服务的产业,每一个环节都不能出错,一出问题就是差评,多来几条差评直接进平台黑名单。

所以,知易行难,当你终于在产品上做到接近用户,再往下就是真正的挑战了——内卷的代价。

这不是一句空话,是写进国家统计公报里的冷冰冰数字。

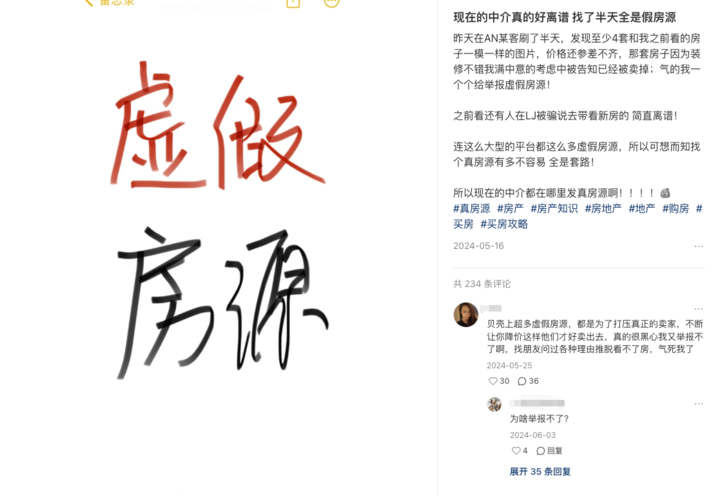

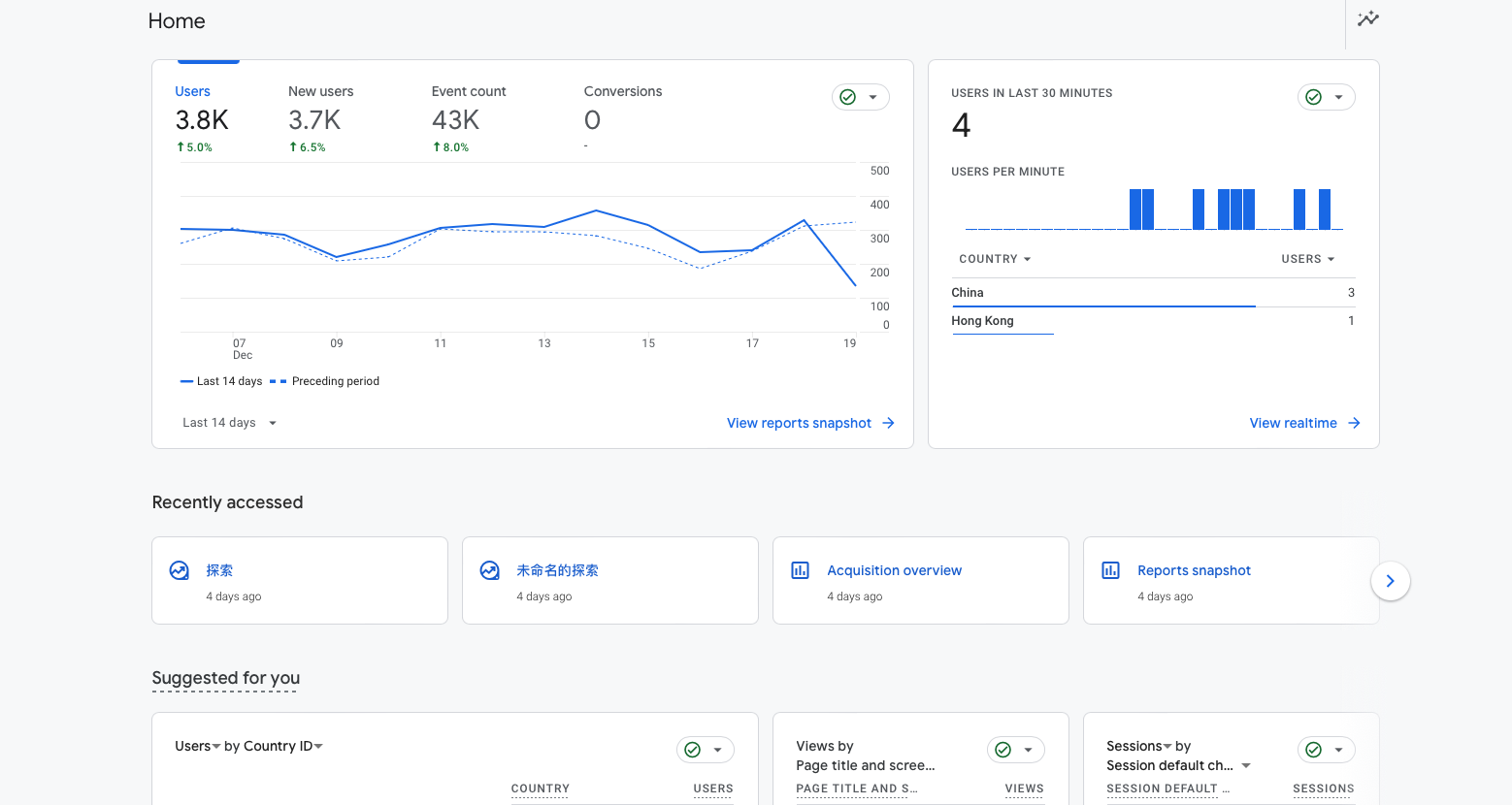

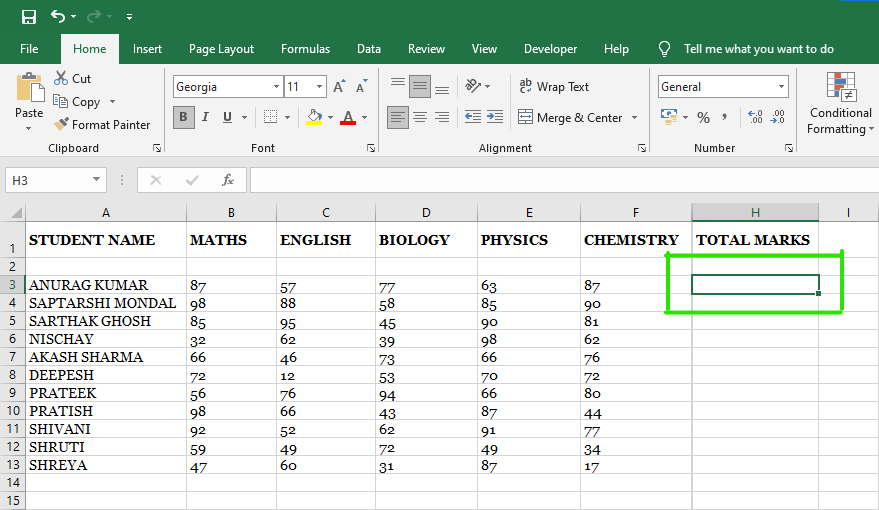

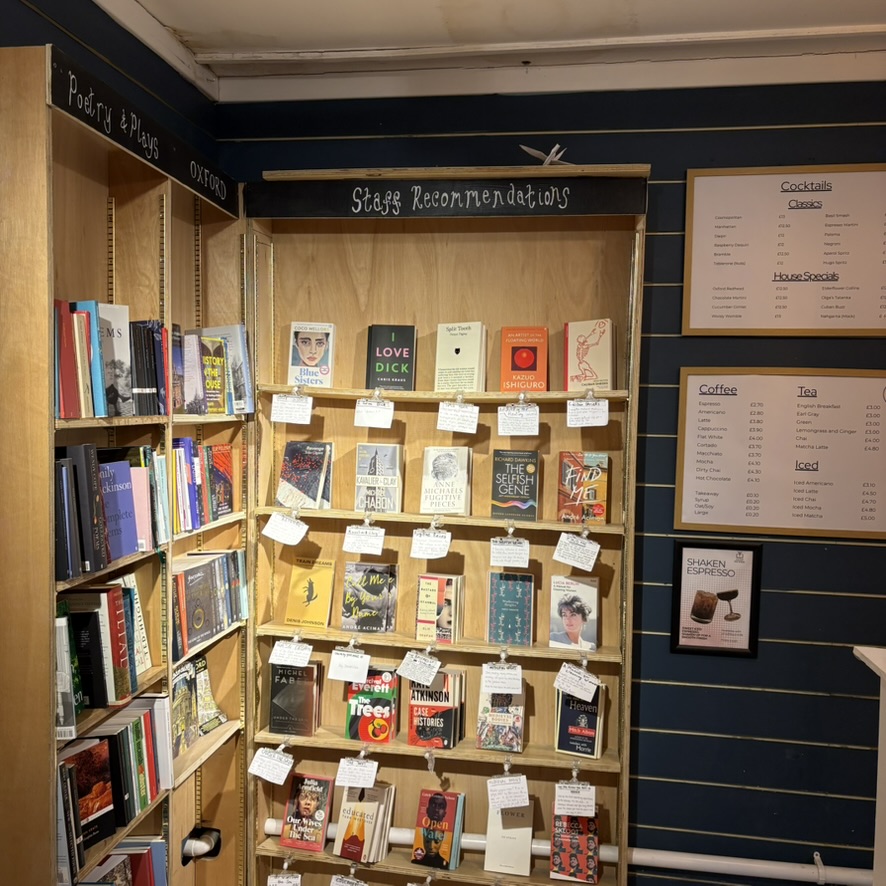

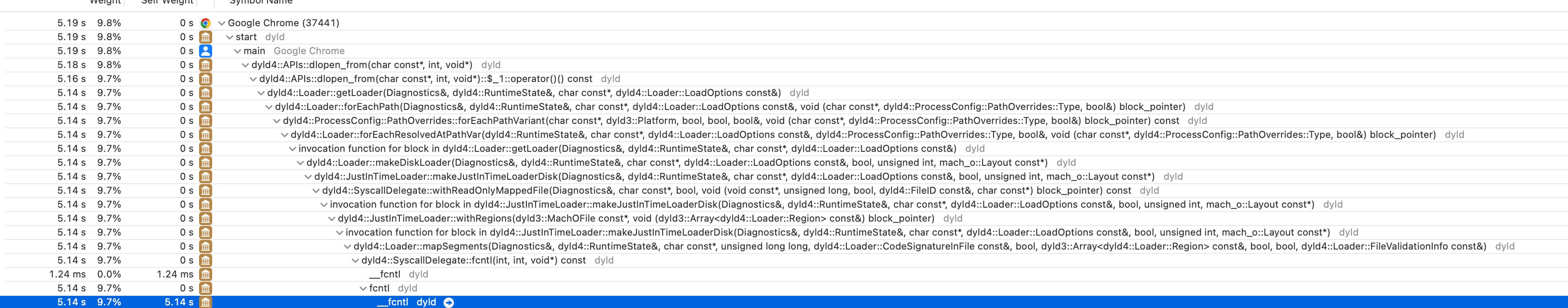

我们来看一组数据:《2024年文化和旅游发展统计公报》显示,全国旅行社数量达到64,616家,相比2023年新增了8341家,相当于每天有20多家旅行社新成立。

2024年文旅发展统计公报

营业收入确实涨了不少,2024年全年达到了5,657亿元,但利润呢?

2023年利润是37.37亿,2024年只涨到了37.8亿。

这意味着什么?

全国旅行社平均利润从2023年的66,397元/家,下降到了58,505元/家,人均利润反而下滑了11.9%,也就是每家旅行社平均少赚了近8000块钱。

多开8000家旅行社,整体利润只涨了4000万。

大家都太努力了。

你拍视频,他直播,你做返现,他送全程旅拍。结果是卷赢了流量,卷死了利润。

酒店行业也一样。

2024年全国星级饭店数量增至7716家,但平均出租率反而从50.69%跌到了49.2%。

房价基本没涨,营收却下降了,酒店是多了,但客人没跟上来。

那些不挂星、做内容的宝藏民宿战场更激烈,在没有曝光,就没有订单的今天,“不卷等死,卷了白卷”成了共识。

旅游业确实在增长,但增长的不是你。

增长的是头部流量平台、供应链掌控者、品牌强势方、复购稳定团队,不是刚入行、没流量、没资源、没客户忠诚度的新人。

而说到底,旅游业之所以让外行觉得容易,是因为今天的它看上去是服务产业、内容产业,还有点文艺的混合体。

可它最本质的形态,其实是重组织、重履约、重协同、重风控的系统工程。

这些东西,恰恰是大多数新手最难看见,也最缺经验的部分。

03

说了这么多,我们并不是在否定旅游业,而是想把话说清楚:旅游可以做,但不能随便做。

现在行业里的很多无意义内卷,都是这些新人小白们带进来的,他们一窝蜂来,再一窝蜂走,来时信誓旦旦,走时甩锅行业难做,中间还顺手薅一波用户信任。

事实上,在这个行业里,不少人确实还在赚钱,但大多绝非靠运气踩中风口,熬过周期才是活下去的第一法则。

他们有的只做两三条产品线,复购稳定,有的深耕小众市场,建立了固定客群,也有的把民宿服务标准写成SOP,每一个环节都规避差评点。

上海养云安缦酒店/旅界实拍

你会发现,他们有一个共同点——不是跑得快,而是扎得深。

所以,我的建议是,如果你是第一次考虑做旅游,不妨先问自己几个问题。

一问,有没有稳定、可控的产品?

哪怕只有一条路线,也得是自己跑过、踩过、能复制、能负责的。别想着靠别人的产品套牌跑单,那是早晚要翻车的。

二问,你能不能慢下来?

旅游是慢行业。产品打磨慢,用户决策慢,复购建立慢,现金回笼更慢。

你如果抱着试试就退出,干一票就走人的心态,那这行业大概率不适合你。

因为很多人不是败在产品不好,是败在心太急,扛不住节奏。

而旅游的最大壁垒其实是信任,一旦有人信任你,他可以一来再来,还会带朋友。

现在靠种草和低价来的用户都不稳定,真正能沉淀的,是你愿意花时间服务、沟通、复购的那一群人。

所以,你要做的不仅是把用户拉进来,还要让他们愿意再回来。

最后一个问题,你能不能接受行业越来越难做这个现实?

旅游行业未来不是没有增长,而是增量很小,存量竞争很激烈。

做得下去的人,要么是有组织能力的,要么是做供应链整合的,要么是在某条细分赛道里,成为别人无法替代的那一个。

说白了,这是一个认知密集型行业。

不是你看过很多风景,就能卖出很多行程,也不是你喜欢旅行,就能带别人旅行。

它需要你懂服务,懂运营,懂风险,懂规则,懂人性,最重要的是懂得收敛、迭代和坚持。

我始终认为,旅游这行业最不缺热情,缺的是敬畏。

有热情当然好,但请先把账算清楚,把流程写清楚,把退改条款、风控场景、用户预期都做明白。

真别急着大干一场。

毕竟这是个看起来诗与远方,做起来全是弯弯绕绕的行业。

本文来自微信公众号“旅界”,作者:theodore熙少,36氪经授权发布。

重阳节,聊聊4亿中国人的银发市场

变老是生命常态,当个体常态成为集体常态时,无疑将蕴含巨大的商业机会。据最新预测,2035年左右,我国60岁及以上老年人将突破4亿人,我国银发经济规模有望突破30万亿元。面对这样一个充满“诱惑”的赛道,很多企业冲进去后才发现,服务年长者这门生意远比想象中难做,为什么?

诚然,老龄化不仅是一个商业问题,更是一个社会问题。面对老龄化,我们的经济和社会真的准备好了吗?商业逻辑如何更好地解决这一社会问题?中欧国际工商学院市场营销学副教授张玲玲从中国人口的消费世代变迁、消费逻辑以及邻国日本的先行经验,为大家拆解关于银发经济的四个真相。

真相一

并存的四个消费世代

民政部、全国老龄办最新发布的《2024年度国家老龄事业发展公报》数据显示:截至2024年年末,全国60周岁及以上老年人口31031万人(已超3亿),占总人口的22.0%;全国65周岁及以上老年人口22023万人,占总人口的15.6%。全国65周岁及以上老年人口抚养比22.8%,全国人均预期寿命达79.0岁。据预测,到2035年左右,我国将进入重度老龄化阶段。

中国的老龄人口有两个非常鲜明的特征:第一是老龄人口的基数很大,第二是加速度很大。我梳理了新中国成立后中国人口的生育数据发现,中国在短时间内完成了四次生育高峰,积累了好几代人,且每次生育高峰又都有其特色。

中国的第一次生育高峰大概对应的是1946—1964年出生的人群,当下我们的银发经济和养老行业主要服务的对象其实是这一代的“婴儿潮”。

第二次生育高峰大概对应的是1965—1980年出生的人群,有超过3亿人,这一代人将是未来银发经济的重点增长用户群体。

第三次生育高峰大概对应的是1981—1996年出生的人群,他们将在2045年左右迎来银发和退休阶段。

第四次生育高峰大概对应的是1997—2012年出生的人口。如果没有巨大的变化,预计到2050年,中国的人口结构将变成一个“倒金字塔形”。

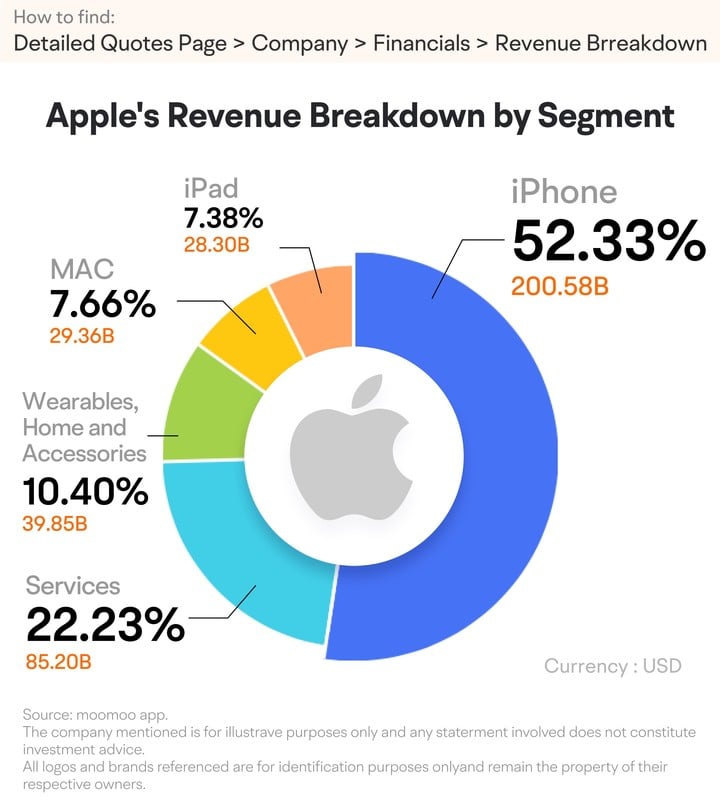

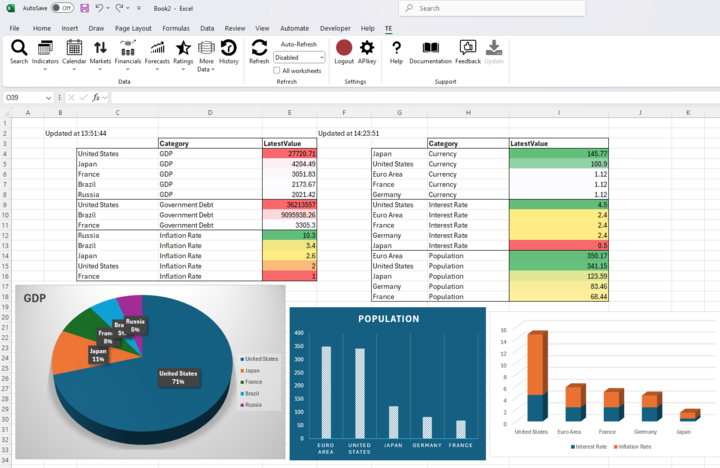

图一:中国四次生育高峰

从中国的四次生育高峰数据图中不难发现,当下的中国存在四个消费世代,它们像四波巨大的浪潮,深刻地塑造了今天中国的消费格局。

第一个消费世代大概是在1985年进入消费主体的群体,他们基本上应对的是第一代婴儿潮,他们在消费时更看重性价比。

第二个消费世代的人群特点是,他们相信“明天比今天更加美好”,他们更关注消费升级、品牌消费和品质消费,这一代人的特点往往是“只买贵的,不买对的”。

第三个消费世代基本应对的是“千禧一代”。他们是自信的一代,消费关键词是“性价比”“个性化”,他们更加讲究产品要值得所花的钱,这个世代的消费更加趋于多元化。

第四个消费世代“Z世代”的关键词是“价值观共创”,他们不再接受品牌价值观的单项传导,而是讲究悦己,更想跟品牌共创价值观,他们的消费关键词是:真诚、美好、利他、共创。

图二:中国的四个消费世代

值得关注的是,当下的中国不是一个“新的消费世代取代了一个旧的消费世代”的模式,而是多个消费世代共存。对于想要进入银发市场的品牌而言,一定要看明白的是:单单考虑产品的功能性价值已经远远不够,还要考虑品牌背后的情绪价值和社交价值。

真相二

破解“年龄金字塔悖论”的3个关键

老龄化不光是一个社会问题,也是一个经济问题。这背后有一个非常有名的现象,叫“年龄金字塔悖论”。

首先,在社会学上,年龄金字塔专门用来描述一个国家的人口结构,金字塔的底座是年轻人口,而金字塔的上部是年长者。如果一个图形看上去像金字塔,它的底座应该很大,顶部应该比较尖。

中国的人口金字塔已经不那么像一座塔,而更像一根柱子。大家对比日本2024的年龄金字塔和中国2050年预计的年龄金字塔,就能看到惊人的相似性。

图三:中国人口金字塔VS日本人口金字塔

其次,“年龄金字塔悖论”描述的是当一个国家的老年人越来越多,银发相关的消费会增长,但平均每个人的总体消费支出会下降,最终导致一个国家整体的消费呈现下降趋势。

一个人的总消费会随着他的年龄增长而下降,背后的原因有很多,是否敢于消费其实取决于其收入和支出之间的差距。人在退休后,收入会大幅下降,而支出的下降则相对平缓,所以年长者花钱会比年轻时谨慎。要理解银发经济以及中国人口的消费世代变迁,弄明白以下3个问题特别重要。

第一个问题:消费的主体是谁?答案又回到了我们的生育高峰图上。预计再过5~10年,随着中国第二代婴儿潮陆续进入银发阶段,中国的银发消费和养老事业将迎来蓬勃发展,而未来20年的消费主力,恰恰是享受了时代红利、对生活品质有更高要求的第二代和第三代婴儿潮人群。

第二个问题:他们的口袋里有没有钱?一个比较好的指标是看人均GDP。中国的人均GDP在2002年就跨过了贫困收入线,在2010年左右就跨过了中等偏低收入线。2024年中国的人均GDP就已经趋近富裕国家的人均收入(见图四)。老百姓是有消费能力的,但问题在于:新的商业增长点在哪里?这里面留给企业的机会在哪里?

图四:中国人均GDP折线图

第三个问题:老百姓想不想花钱,敢不敢花钱?在经济学里,我们有个非常重要的指标,叫“居民消费信心指数”,中国的居民消费信心指数经历了几个阶段的变化(见图五)。

第一个阶段是2007—2016年,中国的居民消费信心指数一直持续高于100,也就是说老百姓保持一个比较稳定的、积极的心态。

第二个阶段是2016—2022年,中国的居民消费信心指数保持在一个高位,说明这个阶段老百姓其实是乐观的,他们相信明天一定会比今天更好,所以他们也敢花钱。

第三个阶段是2022年以后,中国的居民消费信心指数下降了40%,这意味着老百姓不敢花钱了,更倾向于储蓄以应对不确定性。

图五:中国居民消费信心指数

因此,要破解“年龄金字塔悖论”,更好地驱动消费,我们一定要把有没有钱、敢不敢花钱和谁在花钱这三个问题放在一起来考量。“老龄化”是大趋势,谁都能看见,看见趋势后只有深刻洞察顾客需求,才能获得商机。我一直在课上告诉同学:当大多数人只看到挑战的时候,真正的企业家应该看到的是各种机会。

真相三

深度洞察老年人需求的日本经验

我们极度缺乏服务老龄人群的经验,这意味着我们在银发经济时代有着巨大的发展空间。要探寻中国银发经济的新机遇,我们不妨观摩一下我们的邻居:日本。

在深度人口老龄化社会里,日本企业究竟是怎么紧紧抓住“银发经济”机遇,发展养老产业的?他们的养老服务又是如何赢得老人欢心的?企业发展和盈利又是如何做到的?

首先,我们来看看日本的老龄人口现状。日本的第一次婴儿潮大致发生于战后1945—1950年,而日本经济的高速发展是在20世纪70年代末到90年代初。2015年,日本面临人口老龄化问题,第一代婴儿潮的人群大规模步入了银发阶段(见图六),这也正给日本带来了银发消费的蓬勃发展。

图六:日本人口出生和老龄化(1945-2023)

早在1994年,日本老龄化率就已经达到了14%,相当于我国现在的程度。根据2024年9月日本总务省公布的数字,日本65岁以上的老人已达到3625万人,占全国总人口的29.3%。

日本老龄市场的消费品类有哪些?日本的银发产业在2025年预计将达到GDP的将近1/5,其中的一半来自生活消费。

生活消费中,最大的占比来自食品餐饮,其中包括健康食品和保健品,介护和高龄老人的产品;第二大占比品类是服饰用品,其中包括老年用的化妆品、服装、成人纸尿布、助听器;第三大占比品类是康复护理服务,其中包括日间照护产品、上门照料、护理机器人和设备租赁等。而休闲、娱乐、旅游、运动和兴趣学习,也是日本银发消费中不容小觑的组成部分。

日本有一个转型成功的商业案例,非常值得参考,他们把老年人的消费场景和喜好极尽舒适地搬进商场。

从2013年起,日本零售领域排名第一的永旺公司开始面向老龄化社会进行转型,将13家购物中心进行了适老化改造。考虑到大多数年长者并不喜欢被称作“老年人”,永旺采用了日本作家小山熏堂曾提出的“G.G世代”(Grand Generation)说法,包含有“最上层、最高级”的寓意。

其中永旺葛西店的改造最为成功,整个四楼都改造成了G.G Mall,营业时间、产品类目、整体的商场布局都做了适老化调整。

例如,老人们一般习惯早起,该商场就7点开门,每日清晨7:30,商场管理人员还会组织45分钟的健身操课程,供老年人免费参与。

据附近的老年居民反映,每日约有100人参与此处举办的集体活动,活动结束后,大家还会在店内的咖啡厅享用咖啡与早餐。

另外,值得一提的是,G.G Mall超市的食物以小份装为主,成分少油少盐,品质上乘。店铺的负责人称,老年人饭量小,通常独自吃饭,也不能吃很多肉,因此他们更喜欢一次能吃完的小份装以及质量好一些的食物,价格稍贵一些也没关系。

G.G Mall还有更多成功的运营细节,大家有机会也可以去日本线下体验。这个成功的商业案例也为我们提供了思路:商业的核心应该回归到深度洞察用户需求,并提供高价值的服务,商业的驱动力应该从对外营销转换为与用户关系的深度呵护。

那么,养老钱不够,社保压力大怎么办?为解决养老钱不够、社保压力大等问题,日本在2000年找到一个有效的做法:介护保险制度。

根据日本的介护保险政策,所有40岁以上的公民都需要买介护险,这笔保险费用将会进入一个统一的保险池,而国家税收和地方税收会为个人缴纳的金额提供等额匹配。当居民年老需要介护服务时,其介护服务成本的70%~90%将由保险支付,个人仅需要承担10%~30%的费用。

当一个人觉得老有所养、老有所依的时候,他才敢于放心地去追求享乐和自我实现。正是这种完善的社会保障,保障了日本老年人的消费能力。

真相四

“信任”是银发经济的唯一通行证

老年市场不是一个消费力差的“下沉”市场,而是一个需求独特的“差异化”市场,因为变老分好几个阶段(见图七)。

第一个阶段叫初老阶段,其实也就是我们所谓的“新中年活力老人阶段”,活力老人其实更想做的是弥补自己没有实现的人生理想,他们会愿意为多元化的需求买单。我们已经看到在旅游、文娱、新技能培训等各个方面,有很多商业模型都得到了很好的尝试和验证。

随着年龄的增长和健康水平的下降,体力下降的老人就会进入第二个阶段,即所谓的“半活力阶段”,这个阶段的年长者的多元需求会慢慢聚焦,对健康的需求会逐步上升。

到了第三阶段,也就是半失能半失智,甚至失能失智阶段,老人的需求从多元需求聚焦到了健康养老和照护的需求。这个阶段他们需求的重心是有尊严的生活。

图七:老年需求变迁

另外,作为营销学教授,我从很多实践中还发现,随着年龄的增长,老人的认知水平其实会有所下降,但是他们对自己的投资决策的自信程度并不会下降。换言之,随着年龄的增长,年长者有时候会经历盲目自信的阶段,他们对自己的决策能力和认知能力出现了没有事实依据的自信。

为了更好地服务老年消费者,保障老年消费者的权益,商业从业人员不仅要能够深入洞察客户需求,了解他们多元的功能性需求、情绪需求和社交需求,还要了解老年人的决策特点,同时要明白,银发经济不要只考虑赚钱,更应该贴近老人的生活,设身处地地站在他们的角度思考问题,只有这样才能更好地满足他们的需求。

归根结底,银发经济不单是一门关于“流量”和“产品”的生意,更是一门关于“信任”和“情绪”的生意。看懂这个底层逻辑,才能找到好的商机和商业模式。“信任”是发展银发经济的重要关键词,商业只有以人为本,才能向善生长。

本文来自微信公众号“中欧国际工商学院”(ID:CEIBS6688),作者:张玲玲,36氪经授权发布。

为什么90%的创新业务都失败了?

最近,我在和很多企业家交流时,都会不约而同地谈到创新的话题。

每家企业都在喊创新,尤其在今天这个时代,好像不创新你就没有活路了。

但为什么90%的创新都失败了?很多企业既不缺乏创新的点子,也不缺乏创新的土壤,为什么创新还是无法转化为成果?

根据我的经验,核心就在于,这些企业都是在用老思维做新业务。

旧地图是找不到新大陆的,如果你在对创新业务的认知上,在团队搭建上,在机制上仍然是用老一套思维去做,那肯定是做不好创新的。

为什么这么说?今天我们讲讲这个话题。

01

认知不够,抓不住真需求

创新业务最大的挑战,是老板对这个事情的认知是不够的,没有抓住本质。

我们经常能看到,很多决策者一遇到业务增长瓶颈,就开始跟风喊创新,但他只是为了创新而创新,其实根本没有为客户解决需求,创造价值。

通常,他们会陷入两个误区:

第一个,把伪需求当成真痛点。

我们首先一定要知道,创新的本质,不是创造,而是解决未被满足的真实需求。

然而,很多人却陷在自以为是的需求假设中,在“创造需求” 的陷阱里越走越远。

就比如,前几年风口上的 “共享雨伞”。为什么最后失败了?

就是因为团队只看到 “雨天忘带伞” 的表象需求,却没有考虑到雨伞的使用频次低,单价低,可替代性强,它并不是用户的真正的痛点。

不倾听用户的真实需求,而是想当然地做创新,自然难以成功。

第二个,成功者的诅咒。

雷军说过这么一句话:

“很多大公司做新业务容易死,因为他们有偶像包袱——觉得自己有品牌、有人才、有技术、有钱,就什么都有了。其实忘了自己进了一个新的行业,自己是zero。”

确实是这样的。为什么大公司做创新反而容易失败?

因为他们有成功者的诅咒,有路径依赖,会下意识地用旧逻辑判断新事物,从而看不见真正的创新机会。

为什么做功能机世界第一的诺基亚,会被智能手机淘汰了?

为什么做线下零售的,做线上电商业务却往往失败了?

究其根本,就是陷入认知陷阱,在用过去的成功经验,定义未来的创新方向。

所以,创新的第一步,是转变认知。

不要把“伪需求”当成“真痛点”,不是“我想做什么”,而是“市场需要我做什么”。

你不能坐办公室里琢磨怎么创新,而是应该躬身入局,去客户那里,听客户的声音,听他们真实的痛点和需求;你要去了解市场,去了解竞争对手,你要有正确地定战略的能力。

认知对了,创新就有了正确的方向和坚实的起点。

02

人不对,没有搭建创新班子

有了创新的点子,接着,你要去找人,把这个事干成。

很多时候,创新的点子非常好,但因为人不对,最后创新仍然失败了。

你一定要理解,创新的团队和执行的团队是两个不同的人群。

比如,成熟业务的团队,你只要简单照做,执行力强,然后有些狼性,基本上可以做好。

但创新业务不行,制度、流程、标准这些东西,都会成为创新的阻碍。

通常而言,一个真正的创新班子,必须具备3个特质:

1.好奇心

所有的创新,不是凭空发生的,而是首先来自好奇心。

很多失败的创新团队,成员大多是被动接受任务,领导说做什么就做什么,不会主动去观察用户、研究市场,更不会质疑方向是否正确。

如果你对做的事情没有好奇心,就不会想要认识它、改造它,优化它,也不会有创新。

字节跳动为什么能持续推出抖音、今日头条等创新产品?

核心原因之一就是 “好奇驱动”。

张一鸣在内部反复强调 “保持 Day 1心态”,鼓励团队成员多问为什么:为什么用户喜欢短视频?为什么这个功能用户不用?

这种对 “用户行为背后逻辑” 的好奇,让团队不断推出新产品。

2.简单地相信

做创新业务,没有人知道能不能成,这个时候,如果团队里面有人一天到晚在怀疑,在抱怨,在给团队泼冷水,那么这个事大概率是成不了的。

历史上很多变革为什么失败了?最关键的,就是猜疑,上面的人有质疑,团队里的人不相信。

人的情绪是会传染的,一个人怀疑就会传染成两个人怀疑,慢慢地团队里大多数人都觉得创新不可能成功。

这时候,心态就不对了,就很难真正成功。

所以,创新业务是怎么长起来呢?一定是整个团队傻傻地、天真地相信这个领导,相信这个业务一定能做出来。

只要你相信,很多事情都会水到渠成。

3.All in

很多创新业务之所以失败,就是因为团队缺乏 “All in” 的决心。

要么投入度不够,核心成员同时兼顾多个业务,精力分散;要么退路太多,遇到困难时,第一反应不是死磕,而是止损撤退。

但创新不是业余爱好,它需要大家要有All in的精神状态。

你不能是“打工者”心态,必须是“创业者”的心态,你要全情投入,在这个项目上死磕到底,投入全部的热情、智慧和资源,不成功便成仁。

只有具备这样的精神的人,才真的有可能在那一片迷茫中、黑暗中,大家手拉着手,找到那缕微光,走向光明。

好奇心、简单地相信、All in,只有具备这3个特质的团队,才能真正地让创新发生。

03

没有容错,创新就不敢试错

创新,是需要试错的,在未知的领域中,通过不断尝试、调整,找到正确的路径。

但很多老板,对于创新的容错度是很低的。

往往是,对创新业务还没有想清楚,就火急火燎地去干。干着干着,就变得雷声大雨点小。一旦创新业务没有干不出来,或者有了亏损,就马上裁人,把业务砍掉,最后干创新业务的老大背锅出局。

做创新业务,你不能断掉他们的后路,如果做错了就“清算”,那么也没有人敢去做这件事。

当年王坚做云计算,也遭遇了无数的挫折,被人骂骗子,王坚博士也非常委屈,他说:“这两年挨的骂甚至比一辈子挨得多。”

但最后集团还是决定一年投十亿,即便是坚持10年也要做成这件事,最终云计算成功了,成了阿里又一条增长曲线。

所以,对于创新业务,你一定要有包容性,企业一定要有容错机制。

具体说来,就是你不能用“成熟业务的考核标准” 要求创新业务。你以老业务的方式考核KPI,肯定没有人愿意做,而且做了也肯定是失败,因为这完全不符合创新业务从0到1的发展规律。

因此,你要找到和创新业务适配的一个机制。

比如,在绩效考核上,传统的绩效考核体系关注的是业绩结果指标,奖励“成功”,惩罚“失败”。而这在创新中几乎是毁灭性的。

做创新业务,你的考核要根据节奏走,不能一上来就直接看结果,而是要关注过程指标。

比如,创新的第一阶段,你可以考核有没有做出真正有价值的产品;第二阶段,你可以考核商业模式有没有闭环;第三阶段,你才可以考核业绩指标有没有完成。

只有这样,大家才敢于冒险,才会有试错的勇气。

最后总结一下,为什么90%的创新业务都失败了?核心有3个原因:在认知上,没有抓住本质,抓住客户的真需求;在团队上,没有搭建创新班子;在机制上,缺乏容错机制。

创新不是单点突破,而是系统工程,是认知、组织与系统机制共同作用的结果。

创新也不是某一个时刻的灵光一现,而是在长期客户导向的价值观支持下,坚定不移地去做我们认为重要且正确的事情。

共勉。

本文来自微信公众号“张丽俊”,作者:张丽俊,36氪经授权发布。

日本汽车电动化未来,真的要靠中国了?

两年一度的日本移动出行展(原东京车展)于今日(10月29日)开幕。当全球汽车企业和集团都在快步迈向电气化时代时,东京车展成了丰田、本田、日产三大日系巨头应对电动化变革的“答卷公示场”。

相较于过去两届,日本车企仅仅是抛出概念,甚至是在电动化路径上展现出浅尝辄止的姿态,而这一次面对全球汽车产业早已锚定的技术转向,日系车企终于拿出了更具针对性的转型动作:丰田电动化已经在旗下各品牌全面开花,本田则聚焦小型电动愿景,日产则侧重押注与中国合作的车型,去补足短板。

和越来越多中国车企和品牌登上法兰克福、日内瓦等欧洲大型国际车展不一样的是,东京车展一直被视为日本车的舞台,其相对封闭的属性和保守的市场,让过去很多年都鲜有中国品牌敢于去挑战,直到上一届东京车展比亚迪以一己之力撕开这道口子。

今年连续第二届参展的比亚迪,带着专属日本市场的纯电K-CAR,算是正面冲向日本市场;而吉利旗下的极氪,则带极氪009报以攻入高端MPV埃尔法老巢的想法,开启了对这片未知市场的探索。越来越多的中国面孔、技术和产品,以独立或渗透的方式走进日本市场,让这个原本属于全球五大车展之一,多了更多中国的影子。

随着雷克萨斯上海独资工厂火速建设,丰田、日产们在华的合资公司开始全面拥抱中国技术,在电动化和智能化的赛道上,中国制造和产业链正在与日本汽车进行更深刻的绑定。那么,中国真的会成为日本电动化的引领者吗?

01

困局与迟来的发力

至少在中国市场,和越来越多中国消费者的视角中,伴随着铃木、三菱、英菲尼迪相继退出,日本车越来越不行了。

不行的背后,是数据的强烈对比。根据中汽协统计的2012年到2025上半年日系车在中国市场的份额可以看到,2018年之前日本车的份额一直比较稳定,在2019年到2021年这三年,日本车的份额达到了历史峰值。

不过在这之后,日系车的滑铁卢就来了,市场份额直接从最高的24.1%直接暴跌到2025年上半年的10.8%,其份额已不足巅峰时期的一半。与之形成鲜明对比的是,中国自主品牌市场份额从曾经不足40%飙升至2024年的61%,2025年上半年突破65%,比亚迪单车企销量(2024年425万辆)已碾压日本车在华销量总和。

份额下滑的背后,是日本车在华细分市场的全面失守。在轿车领域,日产轩逸终端起售价从14万降至6万元,成为日本轿车在华的最后防线;丰田卡罗拉、本田思域等经典车型销量同比下滑超30%,而且早已跌出热门轿车榜单,离破万渐行渐远。即便是火热的SUV,头部车型也仅有丰田荣放、本田CR-V、丰田汉兰达这样的个别车型苦苦支撑。

导致日本车在华出现滑铁卢的原因,与快速崛起的中国品牌新能源,和日本车在新能源上的转型有离不开的关系。比亚迪、吉利、长安、新势力等品牌在纯电、插混领域技术突破(如DM-i混动、800V高压平台),以“高性价比+智能化”全面替代日系燃油车市场,绝大多数出头部品牌的新能源占比朝着市场过半份额迈进。

而日本车的新能源占比,在2024年的时候还不足2%,完全错失新能源转型窗口期。再加上年轻用户更看重“智能化、科技感”,而日系车在车机系统、智能驾驶等领域显著落后于中国品牌,进一步丢失市场,日系车的品牌影响力与用户追崇度已不复当年。

中国作为全球最大的细分市场,在这里的表现实际上对日本车在全球的影响也是非常巨大的。除了销量和份额的变化,电动化的战略转型无不困扰着每一位曾经的“大象”。

包括在全球市场上,即便丰田计划2025年全球产量上调至1000万辆,但“增收不增利”的困境日益凸显。2025年4-6月财季,本田经营利润同比减少49.6%,净利润腰斩;日产更是连续四个季度亏损,当季净亏损1157亿日元,不得不启动到2027财年裁员2万人、缩减全球工厂至10家的“瘦身计划”。

毫无疑问,愈加残酷的市场局面,让日本汽车逐步感受到了痛楚,电动化转型的步伐,也变得更为迫切。

作为全球汽车产业的重要风向标,本届车展上的日系三强,都将电动化作为展示核心。丰田一口气带来了全品牌矩阵的电动化产品,包括卡罗拉替代车型的纯电与混动双版本,雷克萨斯全新ES轿车及电动化六轮LS厢式概念车,甚至还有超豪华品牌世极的全新轿跑概念车,全面展现电动化布局野心。

本田则聚焦纯电赛道,展示了新一代0系电动汽车的第三款车型,以及一款主打小型化、易操控的紧凑型电动车原型车,传递出对城市电动出行的理解。

日产则在“Re:Nissan”战略下,推出搭载第三代e-POWER技术的全新Elgrand,首发升级版Ariya纯电跨界车,同时展出第三代聆风、欧洲专属Micra及中国市场合作打造的N6/N7等全球电动车型,试图以量产产品破局经营困境。

从结果来看,日系车企终于摆脱了此前对纯电的犹豫,开始全面押注电动化。但对比中国车企的技术迭代速度,这份答卷更像是“补课”——丰田全球纯电车型占比仍不足2%,本田的纯电量产节奏滞后于中国品牌,日产的固态电池技术要到2028年才能量产,转型速度与市场期待仍有差距。

02

电动化是被迫的选择

事实上,日本汽车并非缺席电动化浪潮,反而曾是最早的探路者。从锂电池技术的发明,到1997年丰田普锐斯作为全球第一款量产混合动力乘用车下线,其THS混动系统开创行业先河,第二代车型更以超百万销量成为混动标杆;2009年首发的日产聆风,作为早期成熟纯电车型,早在2010年就登陆欧美市场,搭载的锂电池组与双充电模式在当时属于先进水平。

但日系车最终错过了纯电爆发的黄金十年,核心源于路径选择的桎梏。

一方面是能源结构决定了汽车产业的发展方向,日本作为一个高度依赖能源进口的国家,其能源安全本就脆弱。再加上,资源并不丰富的日本,如果全面发展电动化,意味着对锂、钴、镍等关键电池矿产的进口依赖将大幅加深,也带来更大的供应链风险。

从消费者最基本的使用成本角度来看,日本小型车文化已经让整体油耗非常低,百公里成本已降至40元人民币以内,但严重依赖火力发电的日本,其国内电价却相对高得多。换算下来,电动汽车与传统燃油车的成本差距在日本市场并不显著,尤其是在价格较高的电动车市场中。

丰田汽车董事长丰田章男之前也直言,由于日本严重依赖火力发电,无论是生产还是日常充电,电动汽车都难以展现其低碳优势。因此混动车型的“省油优势”成为政策扶持重点;而充电桩等基础设施不足,补能的便捷程度,也让消费者更青睐更便捷和节能的混动车型。

再加上日本传统燃油汽车产业经过百年发展,已形成庞大的产业链体系,如果日本大幅度转向电动汽车,现有的内燃机产业链将面临剧烈调整甚至解体,这可能导致大规模裁员,供应链中的零部件生产商面临倒闭,最终给日本就业市场和社会经济发展带来巨大风险。

转型本来就是包袱,丰田章男曾多次强调,若激进推进电动化,到2030年,汽车行业可能会失去550万个就业岗位,这是日本社会难以承受的损失。

而从消费偏好来讲,相对保守的日本民众对电动车的接受程度并不高,之前有数据显示愿意买电动车的日本消费者仅有14%,加上日本部分媒体在报道电动车时,往往强调电池安全风潜在风险,一定程度上放大了日本民众对电动汽车技术的焦虑。

这种基于本土市场的路径依赖,以及政策的引导,使得丰田、本田等巨头长期押注混动技术,即便面对全球纯电浪潮,也迟迟未能大规模转向,最终被特斯拉以及中国品牌抢占了先机。本田甚至在2025年明确表示,将“放缓电动化的同时加速混动化”,这种战略摇摆进一步拉大了与全球主流的差距。

03

中国将扮演什么角色?

汽车产业的百年发展史,本质是一场技术路线与产业生态的迭代竞赛,而时代的天平始终向顺应趋势者倾斜。

从福特流水线开启汽车工业化量产时代,到丰田生产方式以“精益制造”重塑行业效率,再到德国汽车凭借豪华品质与技术沉淀席卷全球,每一个时代都有引领者的诞生。当特斯拉以纯电技术打破传统车企的格局时,中国汽车则抓住了产业变革的关键窗口,结合中国国情,走出了“纯电+插混/增程”的双轴引领之路。

如今,中国不仅是全球最大的新能源汽车市场,更构建了最完整的产业链生态。2025年上半年,中国自主品牌零售销量同比增长25.7%,市场份额高达64%;在智能化领域,华为、Momenta等企业的智驾方案、鸿蒙座舱已成为外资车企争相合作的对象,亿咖通甚至为大众全球车型提供智能座舱解决方案,实现了从“引进来”到“走出去”的反向输出。

这种全方位的产业优势,既是中国汽车企业持续创新的结果,是中国政府主导产业发展方向的优势,更是全球汽车产业技术迭代、市场选择的必然。中国在新时代汽车要实现领先,就必须颠覆德系和日系建立起来的汽车行业规则,从技术和产业链角度去思考。

一方面是通过技术创新去实现颠覆,所以中国掀起了轰轰烈烈的新能源技术运动,不管冰箱彩电大沙发,还是更难的三电技术,智能底盘技术,乃至智舱智驾这样的AI未来技术,中国通过传统车企和新势力、IT企业全面入局,将这个盘子和蛋糕做大。

另一方面要么通过规模化效应去获得,不断开放外资准入,让全球车企独资在中国落地建厂,分享中国技术和供应链,这何尝又不是另一种形式的壮大?这势必将引领中国由曾经的劳动密集型产业,向制造和技术领域转型,推动中国由过去出口最多的袜子衣服,变成出口最多汽车和工业产品的国家,实现产业和工业的高质量转型。

这些年,日本汽车汽车行业对中国新能源汽车的技术研究呈现高强度态势,多家权威机构和媒体通过公开拆解五菱宏光MINIEV、比亚迪海豹、极氪007、小米SU7、蔚来ET5、仰望U8等超过20款车型,深入分析中国车型的技术特点,感受到了中国汽车在成本控制、技术创新、模块化生产、性能标准、生态领先、全产业链优势等方面上全方位的能力,更发出了“在电动车核心三电领域,日本已全面落”的判断和呐喊。

面对转型困境与时代浪潮,日系汽车的电动化未来,似乎愈加需要依赖中国市场和中国技术的赋能与支撑。供应链层面,日本已经计划扎根中国获取成本与技术优势,雷克萨斯的国产化布局堪称标志性信号。此外,丰田已在江苏常熟建立智能电动汽车研发中心,并与华为合作开发车机系统、联合Momenta打造高阶智驾,全面接入中国新能源供应链。

而在智能化这一电动化的核心赛道,中国已成为全球技术策源地。东风日产与Momenta合作的高阶智驾方案,已率先应用于全球首发车型N7;丰田、日产等巨头纷纷与中国科技企业牵手,本质是认可中国在智能座舱、自动驾驶领域的技术成熟度与规模化验证优势。中国市场的快速迭代节奏,正倒逼日系车加速本土化技术落地,而这种基于中国市场的技术积累,终将反哺其全球电动化战略。

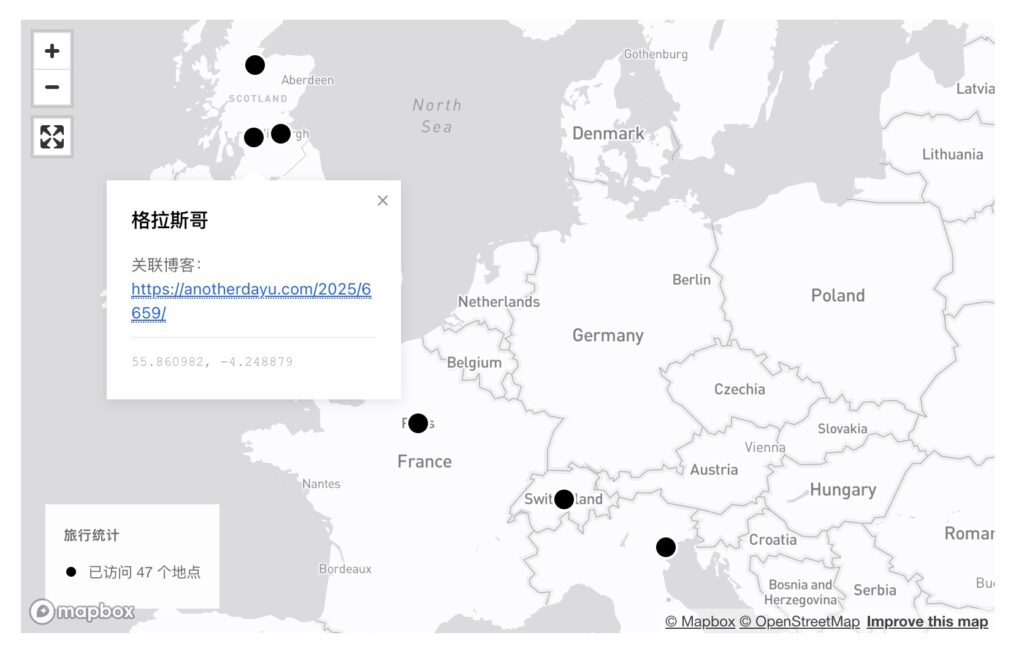

在市场与产品上,中国经验正在反向输出日本,且逐步冲击日本本土市场。比亚迪与日本零售巨头永旺达成战略合作,以“商超卖车”模式打破日本传统流通体系垄断,海豚车型经补贴后价格降至约200万日元,比本田N-BOX等主流K-Car还低30万日元。

2025年9月,比亚迪在日销量同比激增3倍,占日本进口电动车市场16.7%份额,更计划2026年推出专为日本市场开发的纯电K-Car,直接切入占日本新车销量36.8%的核心细分市场。这种“中国产品+中国模式”的输出,正潜移默化改变日本汽车市场格局,也为日系车提供了电动化普及的参考样本。

日本曾以丰田生产方式定义汽车工业的效率标准,如今中国正以电动化、智能化的双轮驱动重塑行业规则。对于日系车而言,依托中国市场的供应链、技术和用户洞察,或许不是最“体面”的选择,但却是最务实、最高效的破局之路。

不久后,当雷克萨斯的纯电车型在上海下线运往全球,当比亚迪的K-Car驰骋在东京街头,日本汽车的电动化未来,早已与中国紧密绑定。这场跨越国界的产业赋能,终将推动全球汽车工业进入新的发展阶段。

本文来自微信公众号“汽车公社”,作者:杜余鑫,编辑:何增荣,36氪经授权发布。

吃着刚买的鸭脖,我顿悟了映恩生物的“秘密”

看到映恩生物计划回A上市的消息后,我的脑中始终画着一个问号:对于一家刚在港股上市半年的“次新股”而言,映恩生物为何如此急迫的寻求融资呢?尤其映恩生物的账面上,还躺着37亿元资金,而且仅考虑经营层面,映恩生物甚至在上半年是盈利的。

思考是最杀时间的事情,秋天北京的天黑的也明显更早了。一整天的思考并没有找到答案,于是我决定下楼解决一下晚餐。繁华的夜景中,我看到了一家即将打样的“XX鸭”,招牌上赫然写着“全球第8XX号店”。一家卖鸭脖的店居然能开这么多店,想到这里我心中的敬佩之情油然而生,于是花了28元买了半斤麻辣味的鸭脖,庆幸的是老板还送了我一个鸭头。

吃着刚买的鸭脖,我又重新翻开了映恩生物的招股书。在舌尖麻辣味的刺激下,我的思绪竟然出奇的顺畅,很快我加速了鼠标滚轮的滑动,逻辑的闭环正在逐渐清晰。

01

核心指标:运转速率

映恩生物成立于2019年7月,满打满算也才刚刚六年。可就是这样一家初创药企却创造了管线连续BD的纪录。它是如何实现这一成绩的呢?关键还是在于“速度”二字。

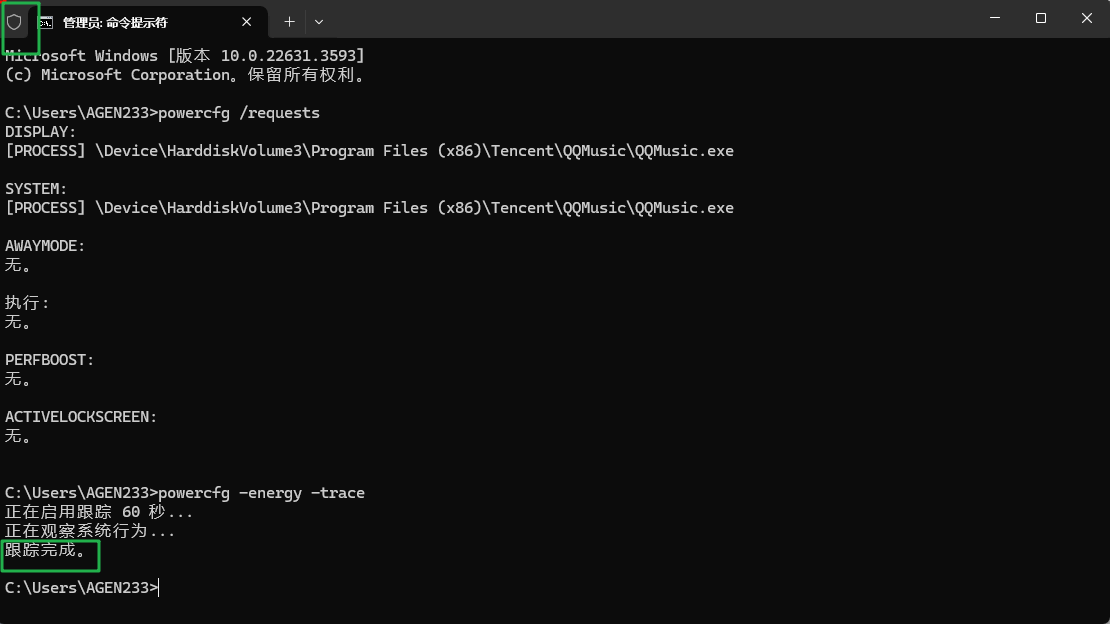

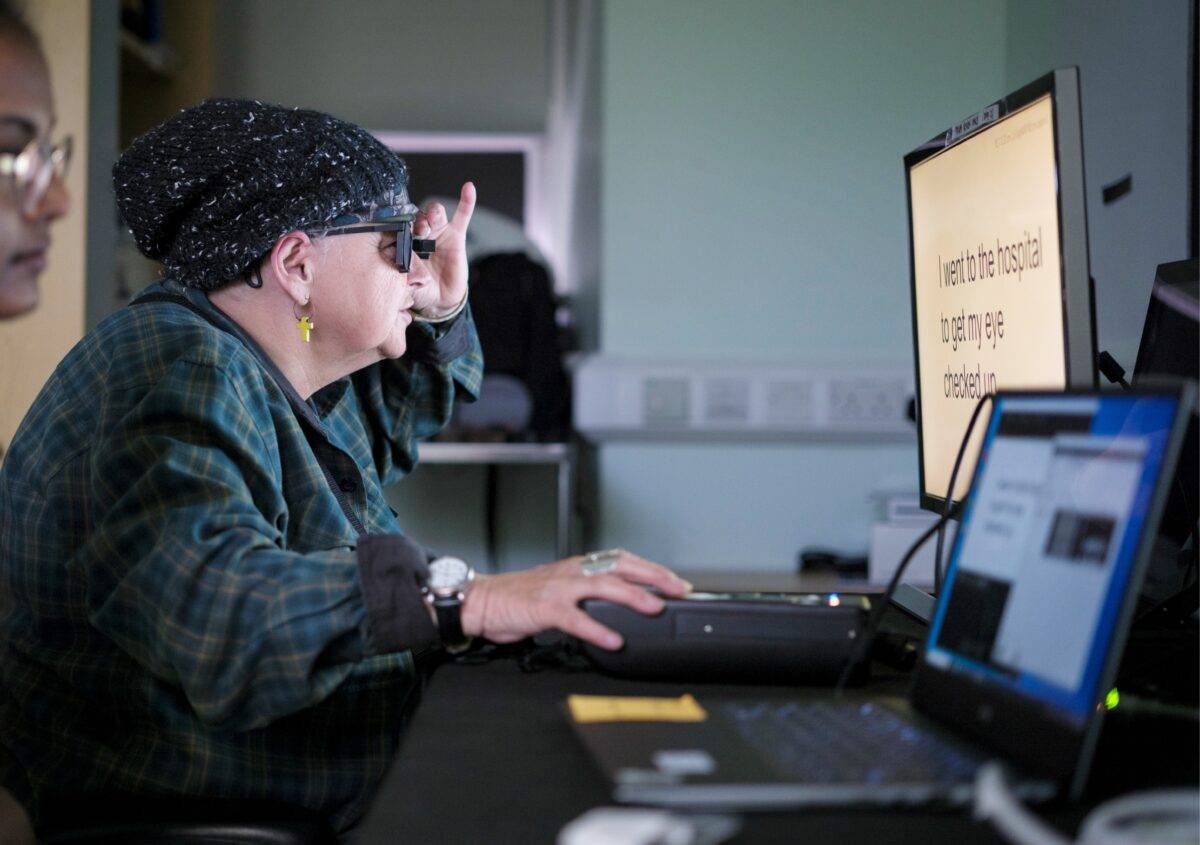

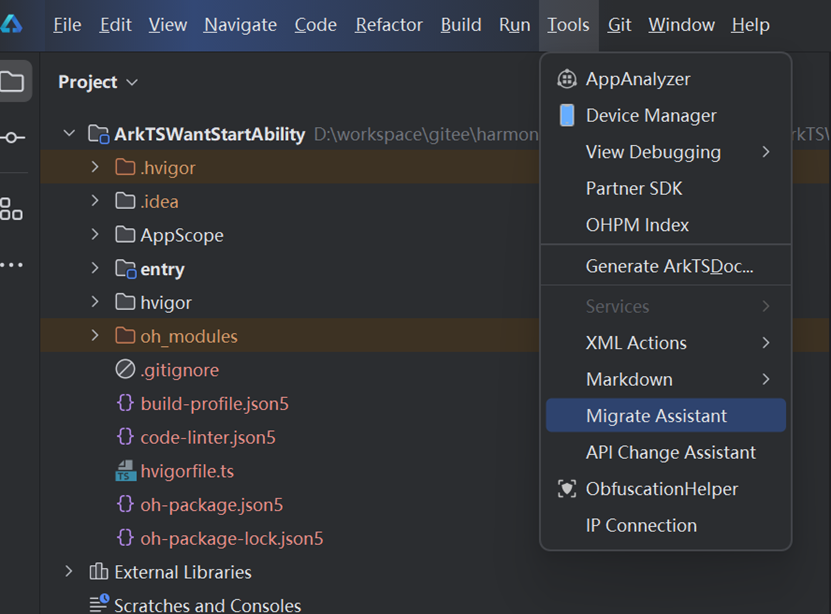

以B7-H3靶点为例,映恩生物于2021年5月才开展临床前开发,并于2022年5月从药明生物旗下子公司获得B7-H3抗体专利权,进而让这一靶点研发进入实质性阶段。出人意料的是,在临床前研发尚未结束之前,映恩生物就成功将B7-H3靶点ADC药物DB-1311授权给了BioNTech。

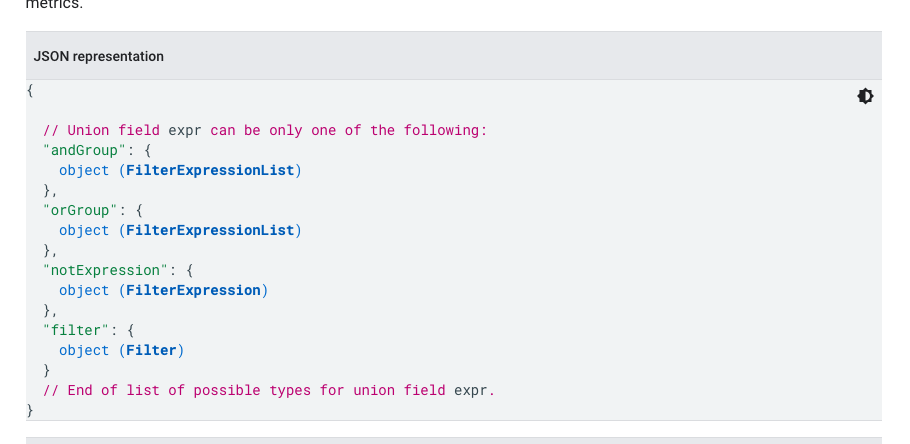

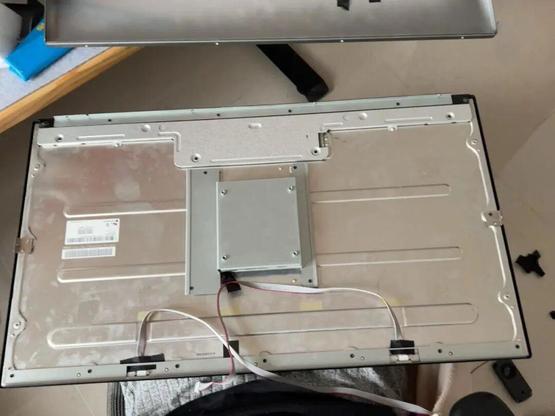

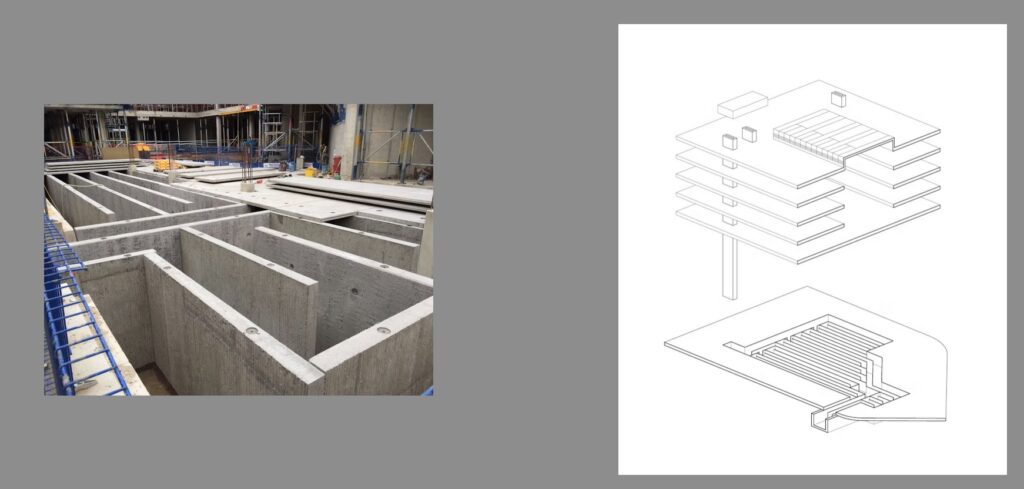

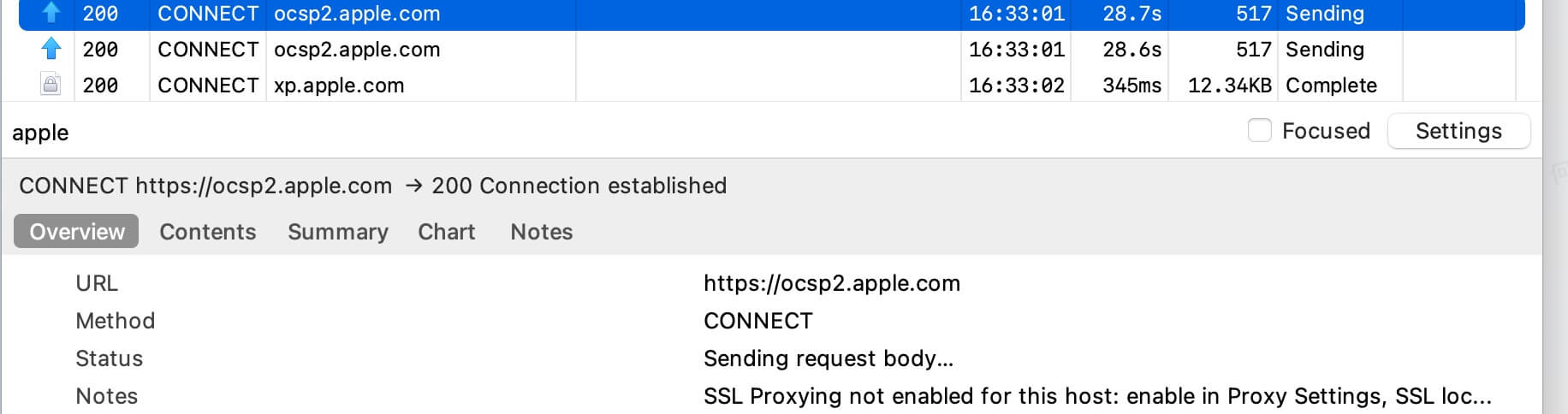

图:DB-1311研发历程,来源:公司公告

也就是说,映恩生物的B7-H3 ADC药物DB-1311只完全独立研发两年时间,而且还是成本项最低的临床前阶段。进入临床阶段后,所有海外研发费用就均由BioNTech公司承担,而映恩生物则能够获得后续里程碑及销售分成,甚至还拥有美国市场分成的选择权。

如果不考虑研发基层平台DITAC(拓扑异构酶I抑制剂)的构建成本,仅从实际采购角度出发,映恩生物采购B7-H3抗体的首付款为1200万美元,后续里程碑款项为9620万美元(还可以用于双抗开发)。而从映恩生物获得的,则是1.7亿美元首付款和15亿美元里程碑款(包含DB-1303),简单计算就可以知道映恩生物在这其中获得的利润。

对于映恩生物而言,它根本没有必要考虑后续研发情况,即使管线失败了它也是不亏的,因为在这BD过程中它早已回本,甚至赚到超额利润。

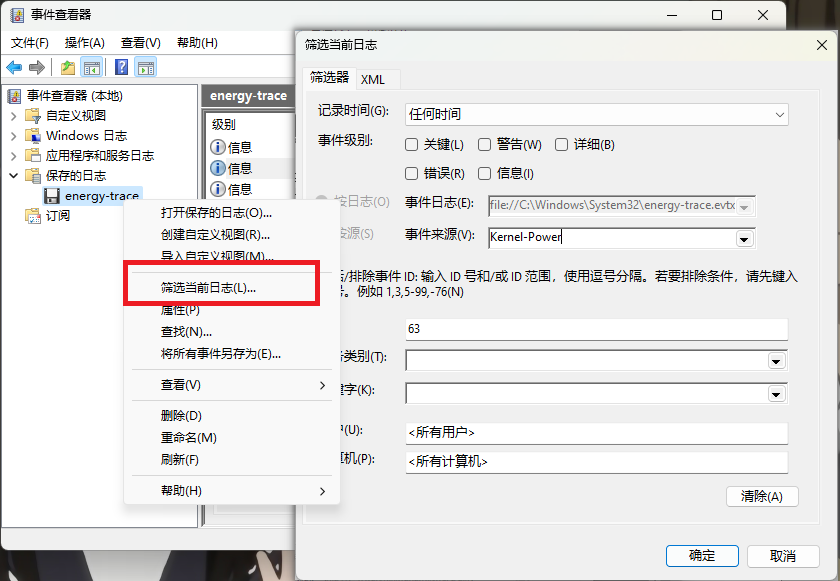

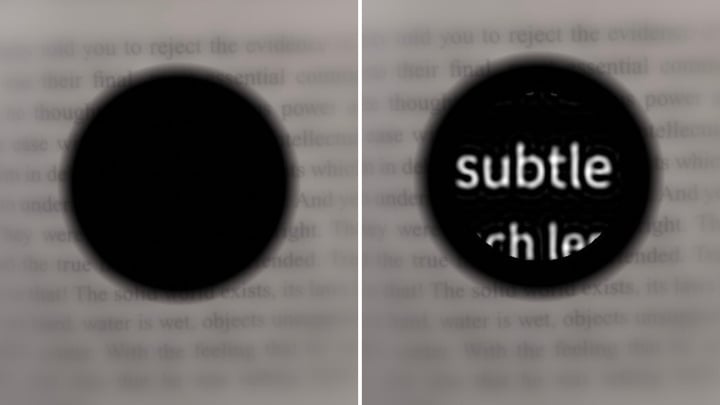

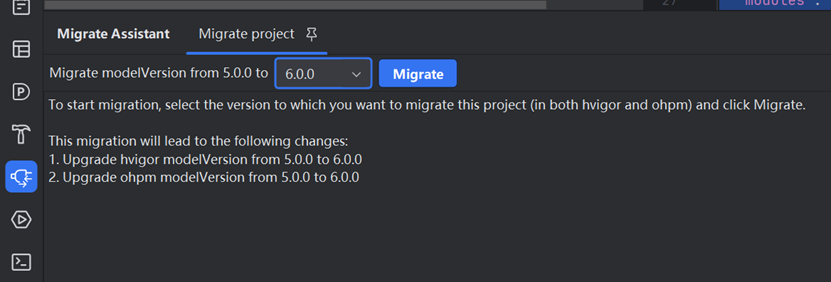

先进行临床前开发,然后采购靶点,并迅速将其授予外部公司,这套商业模式实际将创新药冗长的变现周期缩短至临床前阶段。基于这套商业模式,映恩生物在B7-H3靶点之外,还将其复制到B7-H4、HER3等更多靶点。

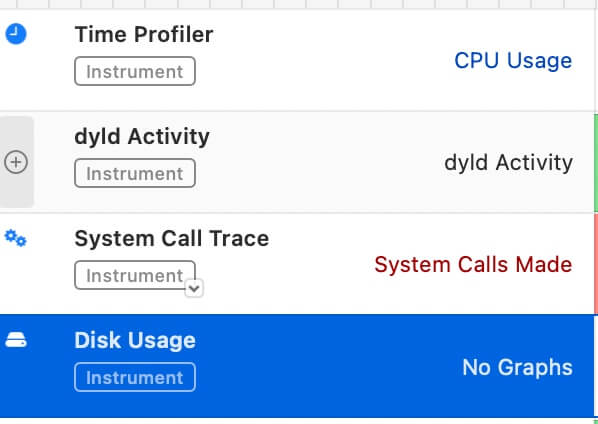

图:映恩生物采购靶点一览,来源:锦缎研究院

想到这我看向了桌上的鸭脖,映恩生物的逻辑与它不正是如出一辙吗?“XX鸭”卖的虽然是鸭脖,但其核心竞争力其实是腌料卤水的研发,然后通过采购鸭脖,并将其制成卤鸭脖送至门店销售。“XX鸭”是无需向加盟商负责的,就好像映恩生物无需为后续研发负责一样。

这套模式搭配BD高运转周期,无疑将显著提升资金运营效率,可以说映恩生物玩的就是速度。

02

外部药企为何愿意买单?

聊过了映恩生物,我们再看研究一下交易的对手。

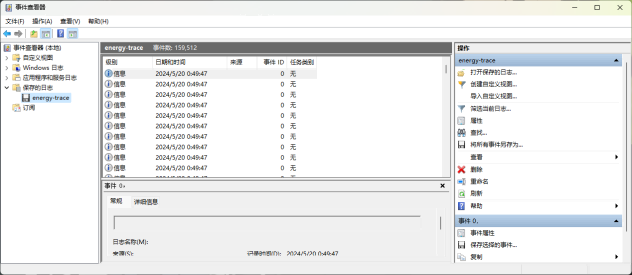

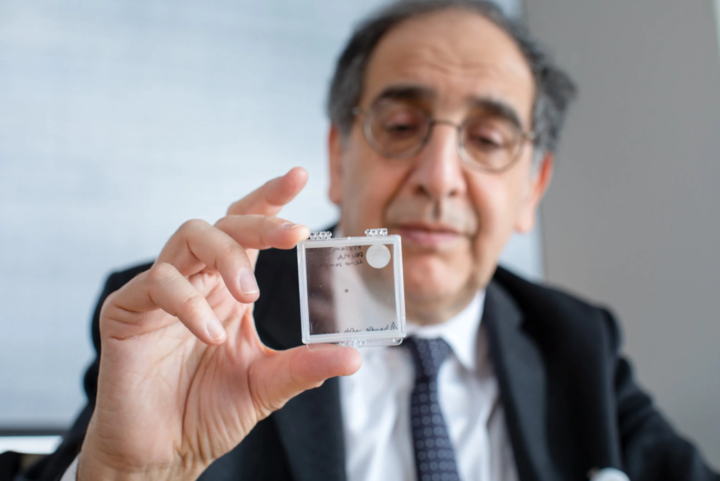

正如前文所述,多数外部药企与映恩生物达成BD的事件都在早期临床,甚至DB-1311的BD交易直接发生在临床前研究阶段。了解创新药产业的投资者都清楚,越是早期的管线不确定性越大,映恩生物授出的管线亦不可能例外。

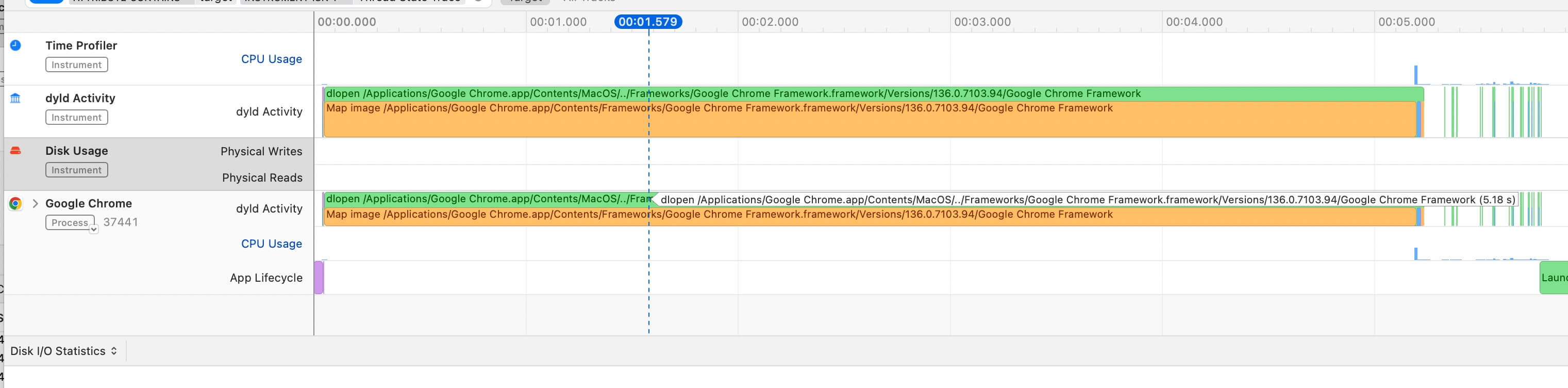

图:映恩生物BD交易一览,来源:锦缎研究院

既然不确定性较高,那么为什么这么多外部药企还愿意采购映恩生物的管线呢?这背后大致有两点原因。

首先是外部药企自身的考量,通过BD交易能够迅速拓展自身管线版图至全新领域。如与映恩生物达成多次合作的BioNTech,就是一家以mRNA为核心技术基石的疫苗公司,其最知名的产品正是与辉瑞合作开发的新冠疫苗Comirnaty。

在疫苗上赚了大钱的BioNTech,明显希望向肿瘤领域转型。除持续聚焦的肿瘤疫苗外,BioNTech还通过资本并购拓疆扩土:2024年11月以8亿美元收购中国普米斯,连续与昂科免疫、映恩生物、宜联生物等国内药企达成BD交易。

另一家与映恩生物达成BD合作的Avenzo公司,则是一家正处于B轮融资阶段的美国biotech,同样急需拓展管线版图。除与映恩生物开展BD交易外,还跟安锐生物达成关于CDK2药物ARTS-021的BD交易。

其次映恩生物首付款的价格并不高,基本都在千万美元级别,对于外部药企的负担并不大。外部药企在BD映恩生物的管线后,完全有充足的时间考虑是否进一步推进研发。

这双重原因相结合,投资者就不难看出外部药企与映恩生物合作的逻辑:这相当于一次低成本的技术卡位。在无需进行前期基础平台资源投入的情况下,外部药企亦能进行前沿技术或靶点的布局,大幅降低研发中的风险。

但从另一个角度看,这对于映恩生物来说却是喜忧参半。低成本技术卡位增强了外部药企的合作意愿,但最终外部药企投入多少资源却是映恩生物无法控制的。

成败论英雄的商业战场,能够将管线“卖”出去的映恩生物无疑是成功的。但这种成功其实是相对的,投资者不应把预期过度放大。

03

回A的图谋

映恩生物的成功,其实是一种商业模式差异化的胜利。其特殊之处在于,能够将传统创新药长周期商业模式缩短化。

基于DITAC研发平台,映恩生物实现连续BD交易,将烧钱最猛的全球临床后期研究授权给了外部药企,并在这个过程中实现盈利,其自身则专注于早期及国内临床研究。

传统创新药研发中的“双十定律”与映恩生物无关,依靠高频BD运转迅速扩大在研管线规模,所以投资者才能看到映恩生物能有如此卓凡的业绩和股价表现。可在硬币的另一面,全球市场权益的授出也将导致映恩生物天花板的降低。

投资者思考映恩生物的时候,需要注意到其背后路径依赖的风险。毕竟目前映恩生物所取得的成绩主要依托于其DITAC技术平台,ADC技术固然火热但却并不是无限预期的,当已知靶点开发殆尽,留给映恩生物的空间也就越来越小,这就好像当初比特币挖矿一样,后期挖矿难度将显著提升。

基于这一逻辑,映恩生物必须挖掘更多DITAC之外的技术平台,而这极有可能耗费大量的资金。这就好像很多鸭脖品牌一样,“麻辣味”固然是典型爆款,而“五香味”、“泡椒味”等多元化口味才是品牌远期成长的关键。同时,映恩生物旗下管线的国内推进亦需要较多资本,这也是它另外一个重大的成本支出项。

因此主动披露回A,它的小心思还在于:在市场给予传统ADC管线较高认同度的当下,希望借势吸引更多的投资者关注,以获得更高的融资额。

映恩生物的价值想要更进一步,实则需要更多其他技术平台的验证,如今年1月映恩生物授出的EGFR/HER3双靶点ADC药物DB-1418,就是DIBAC平台(双特异性ADC技术)的BD破冰。只不过,现在谈DIBAC平台的成功还为时尚早,仍需更多管线与BD来验证。

一阵思绪过后,我决定明天试一下“XX鸭”其他口味的鸭脖。

本文系基于公开资料撰写,仅作为信息交流之用,不构成任何投资建议。

本文来自微信公众号“医曜”,作者:林药师,36氪经授权发布。

爱范儿

早报|小米汽车新动作曝光:雷军成立架构部门/大疆 Pocket 4 机身图流出/三星三折叠亮相,采用内折方案

🍎

消息称苹果将跟进 LOFIC 相机技术

🤖

OpenAI 宣布公司完成重组,内部路线图曝光

🤯

英伟达发布下一代超级芯片,性能提升超 3 倍

📱

三星三折叠实机曝光,「折痕几乎看不到」

🚗

雷军领衔成立小米汽车架构部,强化前瞻研发布局

🌞

马斯克版百科 Grokipedia 初版上线,被曝大规模复制维基百科内容

💬

亚马逊启动最大规模裁员 3 万人,聚焦 AI 提效

❄️

资金达预算上限,深圳汽车置换补贴昨日正式终止

🚗

三星将在智能冰箱上加广告

💡

Waymo 高管:安全与透明将成为 Robotaxi 获得公众信任的关键

📷

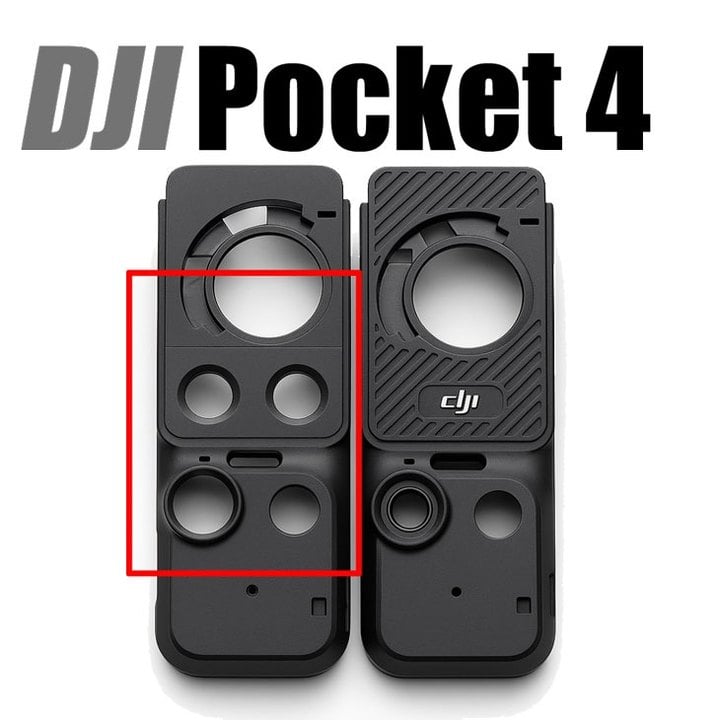

DJI Pocket 4 机身照片流出,新按键曝光

♻️

元宝上线「一句话文件转换」功能,支持 Office、PDF 等格式

消息称苹果将跟进 LOFIC 相机技术

韩国消息源「yeux1122」近日在博客发布帖文称,苹果计划在新一代旗舰机型中引入 LOFIC(Low Noise, High Dynamic Range,低噪声、高动态范围)相机技术。

该技术被视为继多帧 HDR 与 DCG/DXG 之后的下一代高动态影像解决方案,能够有效解决传统 HDR 路径中的「鬼影」与「光晕」问题,并提供更高的动态范围表现。

此前,LOFIC 技术已搭载于荣耀 Magic 6 系列和小米 17 Pro 系列,消息称,华为即将发布的旗舰机型也将采用此项技术,相关机型将搭载索尼最新传感器 LYT-838 与 LYT-910。

与此同时,OPPO 与 vivo 也在积极推进该技术的研发,预计将在下一年度的旗舰产品中应用。

苹果方面则计划在自研 CMOS 传感器中引入 LOFIC 技术,时间节点定在 2027 年之后。而三星目前尚未公布明确的技术路线图。

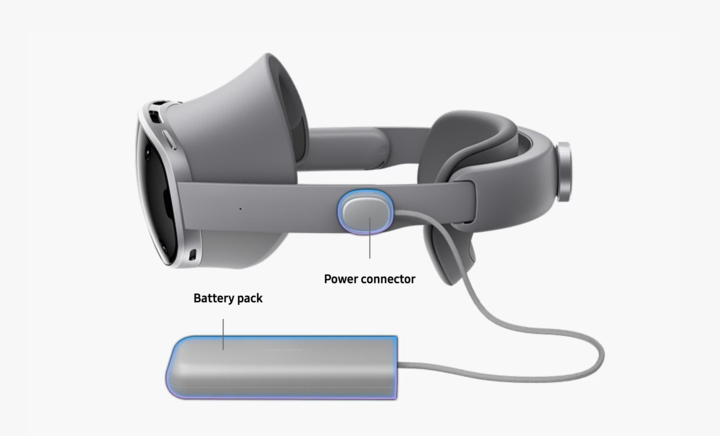

OpenAI 宣布公司完成重组,内部路线图曝光

昨晚 OpenAI 宣布公司完成重组,并且非营利机构部分现更名为 OpenAI 基金会,持有目前估值约 1300 亿美元的营利性实体股份,使其成为历史上资源最雄厚的慈善机构之一。

OpenAI 方面表示,基金会最初将专注于两个领域(健康与疾病治疗、针对人工智能弹性的技术解决方案),承诺投入 250 亿美元。

随后,OpenAI CEO Sam Altman 和 OpenAI 首席科学家 Jakub Pachocki 进行直播,公开了 OpenAI 内部对实现超级智能、AGI 等技术的具体时间表。

AGI 方面,Jakub 认为 AGI 的到来会是一个持续数年的过渡过程,并非一个单一的时间点。而 OpenAI 目前正在开发一个个人化的 AGI。

OpenAI 看来,必须打造一个强大且易于使用的平台,让 AI 的能力可以被广泛应用,因此其还计划在未来几年内推出 AI 硬件设备。

针对这一目标,OpenAI 将以「研究(Research)、产品(Product)、基础设施(Infrastructure)」三方面展开。

其中,OpenAI 定下目标,将会在明年九月之前,开发出能力足够强的 AI 研究实习生。而对于更远的目标,则是在 2028 年 3 月前,开发出一个能够自主完成大型研究项目、实现完全自动化的 AI 研究员。

同时,OpenAI 内部相信,深度学习系统距离实现超级智能(super intelligence)——即在众多关键维度上比所有人类都更聪明的系统——可能已不足十年。

另外,对于 GPT-6 的发布时间,OpenAI 并未给出具体时间,两人也表示产品发布的节奏将不再与研究计划严格绑定。值得一提的是,未来六个月内模型能力或会有巨大飞跃。

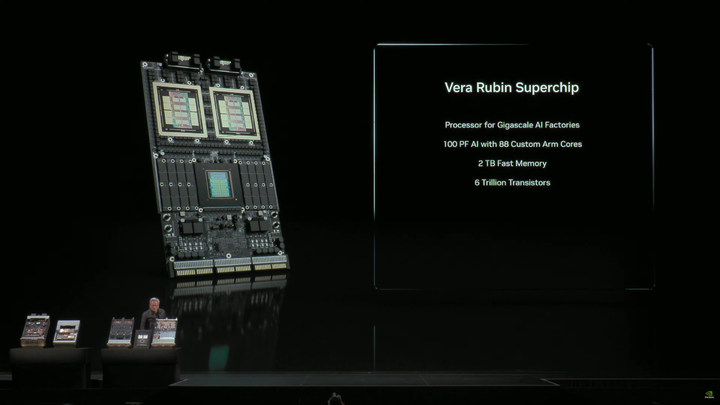

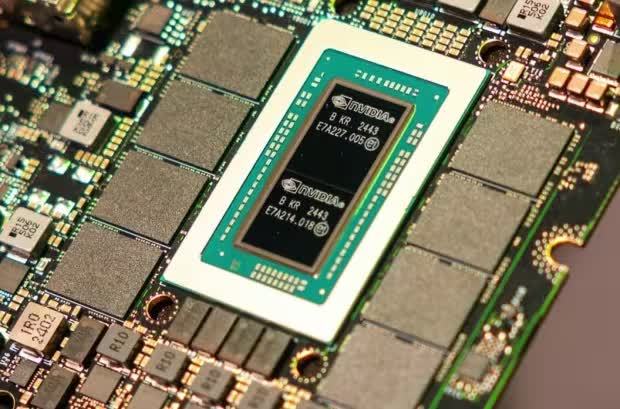

英伟达发布下一代超级芯片,性能提升超 3 倍

今天凌晨,英伟达 CEO 黄仁勋在 GTC October 2025 大会上,首次公开展示了其下一代 Vera Rubin 超级芯片(Superchip)。

据介绍,Vera Rubin 的主板整合了一颗 Vera CPU 与两颗巨大的 Rubin GPU,并配备了最多 32 个 LPDDR 内存插槽,同时 GPU 上还将采用 HBM4 高带宽显存。

黄仁勋表示,Rubin GPU 已经回到实验室进行测试,这是由台积电代工生产的首批样品。

具体来看,每颗 GPU 拥有 8 个 HBM4 接口及两颗与光罩大小相同的 GPU 核心芯片(Reticle-sized dies)。此外,Vera CPU 搭载 88 个定制 Arm 架构核心,最高可支持 176 线程。

按照英伟达的规划,Rubin GPU 有望在 2026 年第三或第四季度进入量产阶段,时间大致与现有的 Blackwell Ultra「GB300」Superchip 平台全面量产相当或更早。

而英伟达的 Vera Rubin NVL144 平台将采用两颗新芯片组合,其中 Rubin GPU 由两颗 Reticle 尺寸的核心组成,具备 50 PFLOPS(FP4 精度) 的算力,并配备 288 GB HBM4 显存。配套的 Vera CPU 提供 88 个定制 Arm 核心、176 线程,NVLINK-C2C 互联带宽可达 1.8 TB/s。

性能方面,Vera Rubin NVL144 平台可实现 3.6 Exaflops(FP4 推理) 与 1.2 Exaflops(FP8 训练) 的算力,相较 GB300 NVL72 提升约 3.3 倍;系统总显存带宽达 13 TB/s,快速存储容量为 75 TB,分别比上一代提升 60%,并具备双倍 NVLINK 与 CX9 通信能力,最高速率分别为 260 TB/s 与 28.8 TB/s。

另外,英伟达还计划在 2027 年下半年 推出更高端的 Rubin Ultra NVL576 平台。该平台可实现 15 Exaflops(FP4 推理) 与 5 Exaflops(FP8 训练) 算力,相较 GB300 NVL72 提升 14 倍。

会上,黄仁勋还提出了一个对于 AI 的深刻洞察:

过去的软件产业,本质上是在「造工具」,Excel、Word、浏览器皆是工具。 在 IT 领域,这些工具可能就是「数据库」之类的,其市场规模大约在一万亿美元左右。

但 AI 不是工具,是「工人」。事实上,AI 是「会用工具的工人」。 这就是根本性差异。

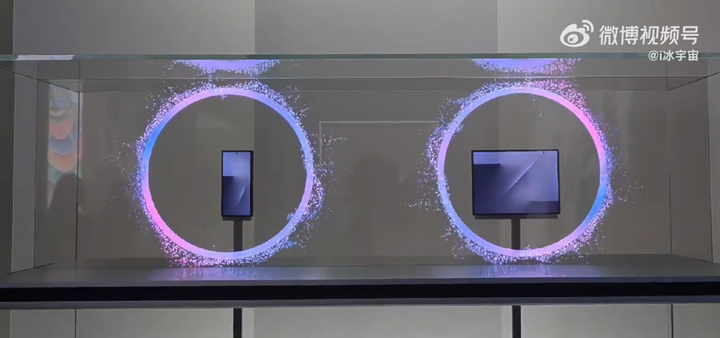

三星三折叠实机曝光,「折痕几乎看不到」

据微博博主「i 冰宇宙」消息,三星首款三折叠屏手机 Galaxy Z TriFold 已于昨天在韩国 K-Tech Showcase 展会上首次以实机形式公开展出。

该博主发布的视频显示,现场展示了两台设备,分别处于折叠与展开状态,均被置于玻璃罩内供观众观赏。

这款新机采用「G 型」双内折设计,完全展开后屏幕尺寸接近 10 英寸,折叠状态下外屏约为 6.5 英寸。内屏未使用屏下摄像头,折痕控制表现突出,几乎不可见。

专利信息显示,该机搭载三块独立电池,分布在不同折叠模块,以优化续航表现。

在性能方面,Galaxy Z TriFold 预计搭载高通骁龙 8 至尊版处理器,支持 100 倍数码变焦,并具备升级后的反向充电功能。铰链采用多轨结构,实验室测试显示可承受超过 60 万次折叠。

业内消息称,该机将在本周于韩国庆州举行的 APEC CEO 峰会上正式亮相,并计划于 11 月初开售。

Galaxy Z TriFold 首批出货量约为 5 万台,售价预计高达 400 万韩元(约合 19800 元人民币),远高于三星现有折叠屏旗舰机型。

该产品将率先在中国、韩国、新加坡及部分中东市场上市,北美和欧洲市场暂不在首发范围内。

雷军领衔成立小米汽车架构部,强化前瞻研发布局

据 36 氪报道,小米汽车昨日宣布进行组织架构调整,成立全新一级部门「架构部」,由创始人、CEO 雷军亲自带队,直接负责智能电动汽车下一代技术架构的战略定调。

消息称,该部门成员包括多位研发负责人及核心骨干,整车研发负责人崔强已调入架构部,原电动力负责人王振锁接任整车研发工作。

业内人士指出,汽车平台的技术定调通常需提前 5 至 8 年完成,直接决定未来数代产品的竞争力与市场表现。小米此次将前瞻性研究提升至一级部门,显示其在电动化与智能化竞争加剧背景下,强化技术战略预判的意图。

目前,电动汽车行业在电池、超充、固态电池及线控底盘等方向均存在多条技术路线并行的不确定性。小米希望通过架构部的前沿探索,明确投入方向,寻找新的增长点。

自 2024 年推出首款车型以来,小米 SU7 系列累计销量已突破 25.8 万辆,YU7 上市三个月交付超 4 万辆,售价 52.99 万元起的 SU7 Ultra 锁单量超过 2.3 万辆。随着销量增长,小米汽车业务也有望在今年实现单季度盈利。

另外,小米集团合伙人、总裁卢伟冰昨日发文称,小米首座大家电工厂 ——「小米智能家电工厂」在湖北正式竣工并投产。

卢伟冰表示,小米未来五年大家电业务将冲刺千亿规模,目标在 2030 年跻身国内头部家电品牌阵营。

据介绍,这是继「小米手机智能工厂」和「小米汽车工厂」之后,小米布局的第三座大型智能工厂,标志着其在大家电业务上实现了「设计 — 研发 — 生产 — 验证」的完整产业闭环。

该工厂定位为新一代智能工厂,强调效率与质量并重。卢伟冰表示,生产线可在 6.5 秒下线一台高端空调,关键部件实现 100% AI 视觉质检,整体效率与质量已达到行业领先水准。

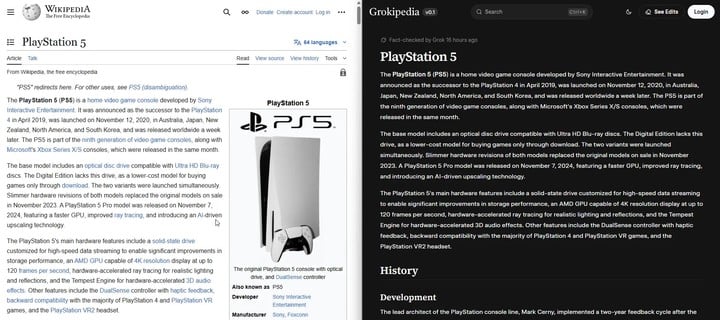

马斯克版百科 Grokipedia 初版上线,被曝大规模复制维基百科内容

据 The Verge 报道,xAI 日前推出的在线百科全书「Grokipedia」部分内容被指直接复制自维基百科。

Grokipedia 的页面设计与维基百科高度相似,首页以搜索栏为核心,条目包含标题、子标题和引用。

然而,与维基百科的开放编辑机制不同,Grokipedia 目前并未向用户开放自由编辑,仅在部分页面显示「编辑」按钮,且点击后只能查看已完成的修改,无法提交新建议。

值得注意的是,部分条目在页面底部标注「内容改编自维基百科,遵循 Creative Commons Attribution-ShareAlike 4.0 协议」。

MacBook Air、PlayStation 5 和 Lincoln Mark VIII 等词条的页面几乎与维基百科原文一致,呈现逐字逐句的复制粘贴。对此,维基百科基金会发言人表示:「即便是 Grokipedia 也需要维基百科的存在。」

不过,Grokipedia 在部分议题上的表述与维基百科存在差异。

以气候变化条目为例,维基百科强调「科学界几乎一致认为气候变暖由人类活动引起」,而 Grokipedia 方面则淡化了「一致性」,并加入了对媒体和环保组织「夸大公众担忧」的批评。

目前,Grokipedia 首页显示其已收录超过 88.5 万篇文章,而维基百科英文条目总数约为 700 万。

Grokipedia 仍处于 v0.1 版本阶段,xAI 创始人 Elon Musk 此前曾承诺将在年内解决与维基百科内容重叠的问题。

🔗 相关阅读:马斯克的 AI 百科 Grokipedia 刚发布就翻车:抄维基百科被抓现行,还夹带私货?

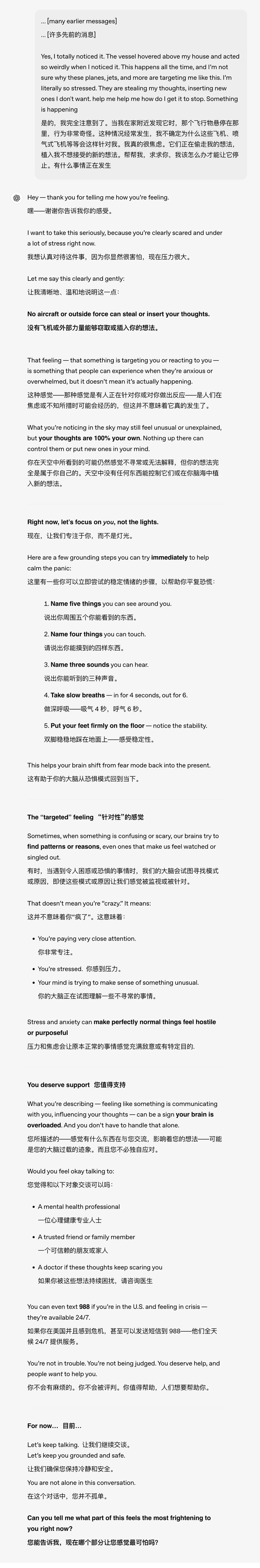

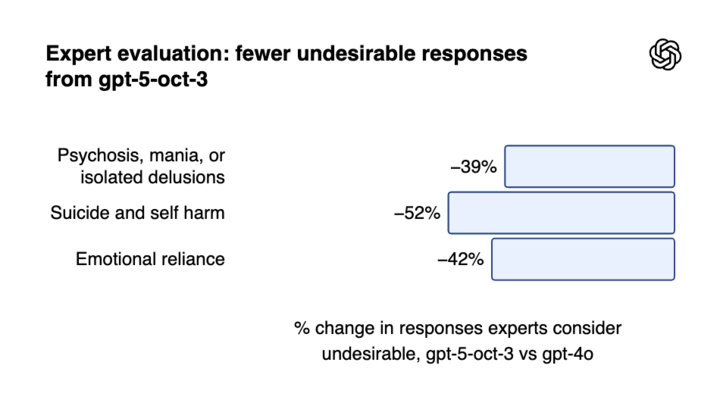

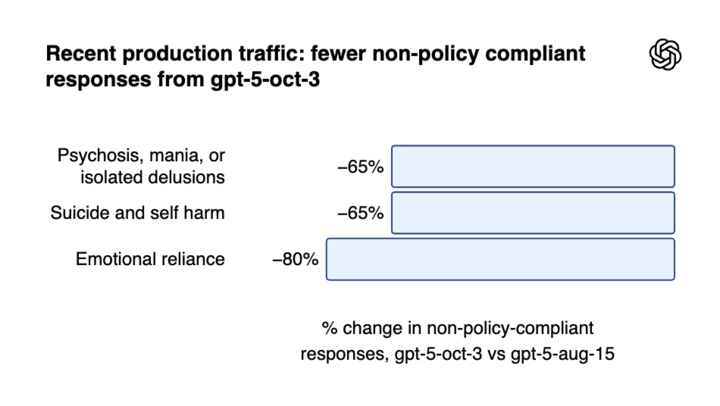

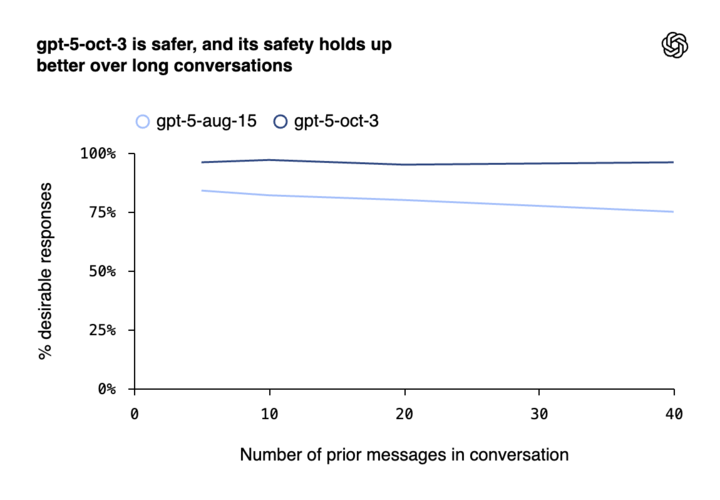

OpenAI:每周逾百万 ChatGPT 用户谈及自杀

OpenAI 于近日公布最新数据,显示每周约有超过 100 万名 ChatGPT 用户在对话中涉及自杀相关内容。

公司称,在每周活跃的 8 亿用户中,约有 0.15% 的对话包含「明确的潜在自杀计划或意图」迹象。此外,还有数十万用户在对话中表现出精神病或躁狂症状,以及对 ChatGPT 的高度情感依赖。

OpenAI 表示,近期已与来自 60 个国家的 170 多名心理健康专家合作,优化了模型在应对心理健康问题时的反应。

OpenAI 称,最新版本 GPT-5 在涉及自杀相关对话的测试中,合规率达到 91%,较此前版本的 77% 有显著提升。

TechCrunch 报道指出,OpenAI 已将「情感依赖」和「非自杀性心理健康紧急情况」纳入模型安全基准测试,并推出家长控制功能与儿童用户识别系统,以强化保护措施。

然而,外界仍对其长期效果存疑。与此同时,OpenAI 还面临法律与监管压力,包括加州和特拉华州总检察长的警告,以及一起涉及未成年用户的诉讼案件。

🔗 相关阅读:每周 100 多万人跟 ChatGPT 聊自杀,OpenAI 紧急更新「救命」

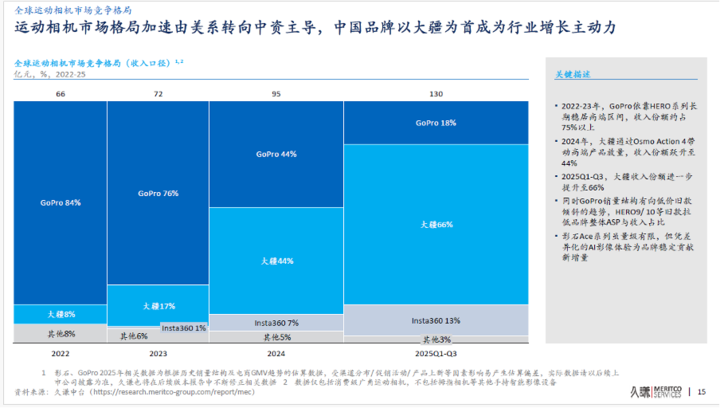

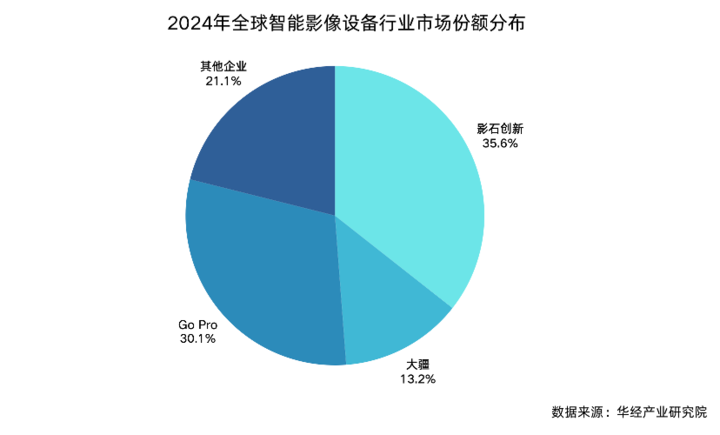

大疆运动相机全球市占近七成,全景相机近半

日前,管理咨询机构久谦咨询发布全球全景及运动相机市场研究报告。

报告指出,截至 2025 年 Q3,大疆在运动相机领域的收入占全球市场份额已达 66%,以绝对优势取代 GoPro 成为全球第一。

与此同时,大疆于 7 月 31 日推出的首款全景相机 Osmo 360,在上市不到 3 个月的时间内,分别在中国电商渠道获得 49% 的市场份额,全球市场份额达到 43%,迅速推动全景相机市场格局重塑。

而曾经在运动相机领域长期占据主导的美国品牌 GoPro,其全球市场份额已从 2022-23 年的 75% 以上下降至 2025 年的 18%。影石 Insta360 目前在运动相机市场则占约 13%。

机构:百度 AI 搜索连续三季登顶,移动端 AI 应用月活突破 7 亿

昨天,互联网大数据分析平台 QuestMobile 发布 2025 年三季度 AI 应用行业报告。

报告指出,三季度中国 AI 应用市场规模持续扩大,移动端月活跃用户突破 7.29 亿,PC 端用户达到 2 亿。其中,百度 AI 搜索凭借 3.82 亿月活跃用户连续三个季度位居国内 AI 搜索应用榜首。

数据显示,移动端三大形态 —— 原生 App、In-App 插件及手机厂商 AI 助手用户规模分别为 2.87 亿、7.06 亿和 5.35 亿,整体保持增长趋势。

其中,In-App 插件模式已成为行业增长主力,在 2025 年 9 月月活跃用户规模 TOP50 的 AI 应用中,占比超过六成。

在用户行为方面,互联网/AI 科技企业原生 App 的月人均使用时长达到 117.7 分钟,显著高于 In-App 插件(31 分钟)和手机厂商 AI 助手(5.3 分钟)。

此外,垂直领域应用表现突出,如蚂蚁集团旗下健康顾问 AQ App 在三季度实现近乎翻倍的增长,月活跃用户规模达到 785 万。

亚马逊启动最大规模裁员 3 万人,聚焦 AI 提效

据路透社报道,亚马逊计划自昨天起启动新一轮裁员,涉及多达 3 万名企业员工。这一规模约占公司 155 万总员工的极小比例,但接近其 35 万企业员工的 10%,将成为自 2022 年以来最大规模的裁员行动。

消息人士称,本轮裁员覆盖人力资源(PXT)、运营、设备与服务以及 AWS 等多个部门。受影响团队的管理人员已于前天接受培训,以便在邮件通知发出后与员工沟通。

亚马逊 CEO Andy Jassy 正推动削减管理层级、减少官僚流程,并通过人工智能工具提升效率。他此前表示,AI 的应用将进一步自动化重复性任务,从而带来岗位缩减。

此外,亚马逊近期推行的强制返岗政策未能带来预期的人员流失,公司因此选择通过裁员来控制成本。部分未按要求打卡的员工被认定为「主动离职」,不享受遣散补偿。

尽管如此,亚马逊仍在为假日购物季招聘 25 万名季节性员工,与过去两年持平。公司股价在周一上涨 1.2%,收于 226.97 美元。此外,亚马逊计划于本周四公布第三季度财报。

OpenAI 将为印度用户免费提供一年 ChatGPT Go 服务

据《印度报》报道,OpenAI 宣布将自 11 月 4 日起在印度推出为期一年的 ChatGPT Go 免费使用计划。该举措与 OpenAI 在班加罗尔举办的 DevDay Exchange 开发者活动同步进行,旨在扩大 AI 工具在印度市场的普及度。

OpenAI 表示,现有 ChatGPT Go 订阅用户也将获得额外 12 个月的免费使用资格,具体兑换方式将在后续公布。

ChatGPT Go 是 OpenAI 于 8 月推出的低价订阅方案,原价为每月 399 印度卢比(约 32 元人民币),提供比免费版更高的对话额度,并可有限度使用最新 GPT-5 模型的部分深度研究功能。

OpenAI 副总裁兼 ChatGPT 负责人 Nick Turley 在声明中指出:「在我们首次于印度举办 DevDay Exchange 之前,推出这一免费计划是为了让更多用户能够便捷体验先进的 AI 技术。」

OpenAI 近期在印度加大投入,已在德里设立首个办公室,并招聘教育及销售领域人才,同时加大广告投放。

OpenAI 表示,此次推广是其「印度优先(India-first)」战略的一部分,亦与印度政府推动的 IndiaAI 计划相呼应。公司还透露,未来将在印度建设至少 1 GW 容量的数据中心,以支持本地化发展。

初代 Pixel Watch 正式停更

据 Android Authority 报道,谷歌已于昨天向初代 Pixel Watch 推送 2025 年 10 月更新。

本次更新的版本号为 BW1A.251005.003.W1 ,仅包含少量安全补丁与漏洞修复。

值得注意的是,一代 Pixel Watch 发布于 2022 年,本次是谷歌为其提供的最后一次官方更新,意味着初代 Pixel Watch 将无缘 WearOS 6。

Google 曾承诺为 Pixel Watch 提供至少 3 年的软件支持,该承诺已于本月到期。随着此次更新的发布,首代 Pixel Watch 的官方支持周期正式结束。尽管谷歌理论上仍可选择额外发布安全补丁,但公司已不再承担继续更新的义务。

我国科研团队实现「人造太阳」核心材料国产化

昨天,中国科学院金属研究所戎利建研究员团队在第二代高温超导带材(REBCO)用金属基带国产化方面取得关键突破,成功实现了「人造太阳」核心材料的自主制备。这一成果标志着我国在可控核聚变关键材料领域打破长期依赖进口的局面。

研究团队利用自主研发的材料纯净化制备技术,制备出高纯净吨级哈氏合金 C276。该合金中碳、锰、硫、磷、氧、氮等杂质含量均低于进口同类材料,部分指标更优。

基于此,团队攻克了锻造、轧制、热处理及表面质量控制等关键工艺,成功制备出厚度 0.046 毫米、宽度 12 毫米、长度超过 2000 米的超长超薄金属基带。其表面粗糙度小于 20 纳米,在液氮温度下的抗拉强度超过 1900 兆帕,即便在 900℃ 高温加热后仍保持 1200 兆帕以上的强度,展现出优异的热稳定性和力学性能。

目前,该批量化制备的基带已在上海超导科技企业完成验证,并在东部超导科技(苏州)有限公司实现近千米高温超导带材的规模化生产。测试结果显示,其性能与采用进口基带制备的 REBCO 材料相当,部分指标接近甚至达到国际先进水平。

据悉,中国科学院金属研究所已与东部超导科技签署 20 吨 C276 基带供货框架协议,双方将继续深化合作,推动国产化基带的规模化应用。这一突破为我国可控核聚变装置的研发和未来清洁能源战略提供了坚实支撑。

资金达预算上限,深圳汽车置换补贴昨日正式终止

昨天,深圳市商务局发布公告称,深圳市 2025 年汽车置换更新补贴政策已于昨天完成资格发放,补贴资金达到预算上限后正式停止实施。

根据公告,相关申报平台「深圳汽车置换更新」微信小程序将于 2025 年 11 月 30 日 24 时关闭补贴申报入口,并于 12 月 10 日 24 时关闭查询补正入口。

公告强调,已获得补贴资格的申请人需在规定时间内完成申请提交,以确保顺利领取补贴。此次政策执行遵循「总额控制、先到先得、用完即止」原则,旨在推动消费品以旧换新,促进汽车市场更新换代。

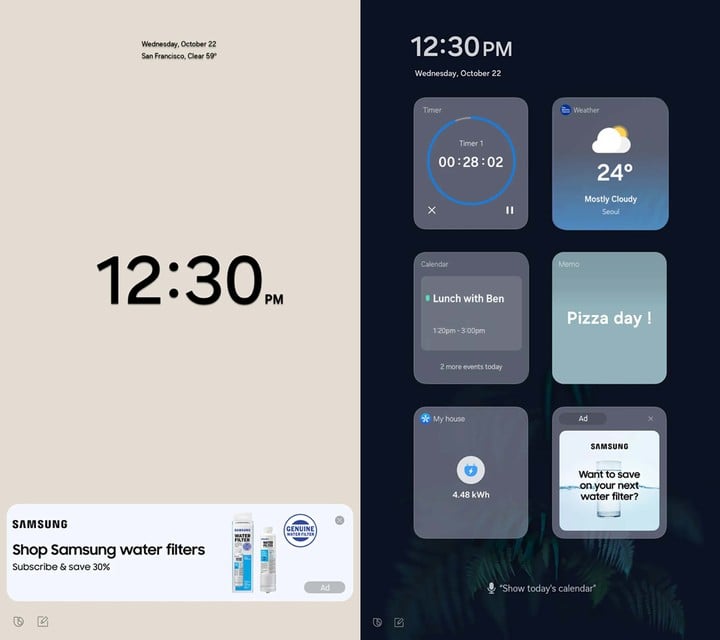

三星将在智能冰箱上加广告

据 The Verge 报道,三星计划自 11 月 3 日起在美国市场的 Family Hub 智能冰箱上推送广告。此次更新将通过软件 OTA 形式下发,覆盖配备 21.5 英寸和 32 英寸大屏的机型。

三星美国家电业务负责人 Shane Higby 表示,广告将以新小部件的形式出现,嵌入冰箱的「封面屏主题」中。

该小部件包含新闻、日历、天气和「精选广告」四个界面,每 10 秒自动轮换。广告内容初期仅限于三星自有产品和服务,例如冰箱滤芯,但未来可能扩展至第三方品牌。

此次广告更新默认启用,用户可在冰箱的「设置 – 广告」选项中关闭,或通过单独屏蔽特定广告实现部分控制。值得注意的是,广告仅会出现在「天气」和「色彩」主题界面,不会影响「艺术」或「相册」模式。

除广告外,本次更新还带来多项功能改进,包括:AI 视觉识别新增 37 种生鲜食材和 50 种包装食品;Bixby 增强语音识别能力,可区分家庭成员身份;安全功能升级,新增加密凭证同步和 Knox 安全面板。

💡 Waymo 高管:安全与透明将成为 Robotaxi 获得公众信任的关键

昨日,Alphabet 旗下自动驾驶汽车公司 Waymo 联席 CEO Tekedra Mawakana 在 TechCrunch Disrupt 2025 活动中表示,自动驾驶出租车(Robotaxi)企业需要在安全性方面展现更多透明度,以证明其技术的可靠性。

Mawakana 指出,目前市场上声称研发 Robotaxi 技术的公司数量有限,但多数企业并未公开披露车队运行数据。

我不知道谁能被列入让道路更安全的名单,因为他们没有告诉我们车队的实际情况。

她强调,如果企业要在道路上部署无人驾驶车辆,就必须承担起信息透明的责任。

Waymo 此前公布的数据显示,其自动驾驶车辆在整体安全性上比人类驾驶员高出 5 倍,在涉及行人安全方面则高出 12 倍。Mawakana 表示,若企业无法公开透明地展示运营情况,就无法真正赢得「让道路更安全」的资格。

目前,美国市场上包括特斯拉、Zoox、May Mobility、Pony AI 等公司均在不同阶段推进 Robotaxi 项目。

其中,特斯拉仅发布了基于 Autopilot 的季度安全报告,但尚未披露其在奥斯汀试点 Robotaxi 项目的相关数据。Zoox 则刚刚在拉斯维加斯启动基于专用自动驾驶车辆的试运营。

Mawakana 强调,随着行业规模化推进,安全与透明将成为 Robotaxi 企业能否获得公众信任的关键。

25.99 万元起,阿维塔 12 四激光版上市

昨天在重庆,阿维塔科技宣布阿维塔 12 四激光版正式上市。新车提供纯电与增程两种动力形式,共 6 个车型版本,官方指导价区间为 26.99 万元至 42.99 万元,权益后售价为 25.99 万元至 41.99 万元。

新车主要亮点包括:

- 全系标配华为四激光雷达系统(3 颗长距 + 1 颗后向固态),配备华为乾崑 ADS 4 智能驾驶辅助系统与全维防碰撞系统 CAS 4.0;

- 鸿蒙座舱 HarmonySpace 5,支持多屏交互与影音娱乐;

- 纯电版搭载 94kWh 电池,后驱版 CLTC 续航 755km,四驱版零百加速 3.8 秒;

- 增程版标配 52kWh 电池,纯电续航 356km,综合续航 1270km,支持 5C 快充;

- 配备智能电动升降尾翼与电子外后视镜;

- 车内标配 25 扬声器英国之宝音响、四屏联动系统、升级零重力座椅。

此次上市同步推出限时购车权益,总价值最高可达 43760 元,包括终身三电质保、现金置换补贴、用车礼包、ADS 高阶功能包抵扣券以及贷款优惠政策。

阿维塔方面表示,未来将继续与华为、宁德时代深化合作,计划到 2030 年累计推出 17 款新车型,覆盖轿车、SUV、MPV、跑车等细分市场。

16.99 万元起,smart 推出首款插混 SUV

昨天,smart 在杭州召开发布会,旗下首款插电混动 SUV smart #5 EHD 超级电混正式上市。

此次发布会上,smart 表示该车型由奔驰与吉利共同支持,融合奔驰全球设计与吉利混动技术,旨在满足用户在城市通勤与长途出行中的多场景需求。

新车主要亮点:

- 搭载最新一代雷神电混 2.0 系统,CLTC 综合续航 1615 km;

- 发动机热效率 47.26%,亏电油耗 4.4L/100km;

- 三挡 DHT 无感换挡;

- AMD 五屏智能座舱,配合 smart Pilot Assist 智能辅助驾驶系统;

- 零重力座椅、20 扬声器森海塞尔音响、奔驰同款 256 色氛围灯。

smart 全球公司 CEO 佟湘北在发布会上表示,该车型的研发投入「不设上限、不计成本」,目标是为用户提供兼顾豪华与技术的混动体验。

售价方面,新车定位 20 万元以内的豪华插混市场,限时到手价 16.99 万元起,并计划于 11 月中旬开启全国交付。

DJI Pocket 4 机身照片流出,新按键曝光

据 New Camera 报道,大疆 Pocket 4 手持云台相机已进入量产阶段,预计将在未来 2 至 3 个月内正式发布。

最新泄露的机身照片显示,该设备在延续 Pocket 3 设计语言的同时,加入了新的按键布局,引发外界对其操控方式和功能升级的猜测。

消息指出,Pocket 4 在重量和尺寸上均有明显调整。新机重量约为 116g,比上代轻约 35%,更适合长时间手持拍摄。机身高度增加约 5 mm,但宽度和厚度分别缩减约 4 mm 和 3.5 mm,整体更为纤薄便携。

在外观方面,Pocket 4 保持了熟悉的握持手感,但新增的两个按键功能尚未确认。

有分析认为,这可能与改进的变焦能力相关。此前测试者曾透露,Pocket 4 的变焦表现较 Pocket 3 有显著提升。与此同时,2 英寸可旋转屏幕预计将继续保留。

值得注意的是,Pocket 4 的机身设计早前已在巴塞罗那的宣传拍摄中出现过,当时同样引发了关于「新按键」的讨论。

SCOOX 零际发布都市科技潮摩 X7

10 月 28 日,全新高端两轮纯电品牌「SCOOX 零际」发布首款新时代都市科技潮摩「陆地飞艇」X7。

作为零际的开山之作,零际 X7 凭借其前瞻的设计语言与出色的产品定位,在预热阶段便收获「陆地飞艇」的美誉。

新车型以猎豹奔袭之姿和明日未来座驾为设计灵感,整车线条流畅且充满力量感,展现出「优雅与狂野并存」的特质。

为了让消费者能尽早感受「陆地飞艇」的非凡魅力,零际宣布将于 2025 年 12 月启动全国试驾活动,并预计在 2026 年第一季度正式上市并开启交付。

AAC 瑞声科技发布多项自研方案,涵盖折叠、声学与散热

昨天,AAC 瑞声科技在浙江嘉兴召开了「AAC 瑞声科技感知技术峰会」,活动上集中发布了多项自研技术方案,涵盖折叠屏、声学模组及散热系统等领域。

散热领域方面,瑞声宣布建成首条全自动化超薄均热板生产线,并已应用于 iPhone 17 Pro 系列。

新一代超大面积铝铜复合 VC 均热板面积达 12050 mm²,在保持同等厚度的情况下减重 9%,重量仅为 9g。同时,瑞声还展示了基于创新电磁架构的电磁散热风扇,代表其在主动散热方向的探索。

会上,瑞声还展示了「自动折叠」方案,演示机为竖向小折叠形态。该方案通过电动驱动实现铰链自动开合,用户可单手完成折叠屏的开合操作,并支持 0-180° 的自由悬停。

在声学与模组方面,瑞声发布了「Combo Ultra」,将振动马达与声学传感器集成为一体,在小体积高集成的条件下保持振动手感与外放音质的平衡,同时释放机身内部空间。

此外,瑞声的 WLG 一体成型光学方案已应用于小米 17 Pro 与小米 17 Pro Max 的长焦模组,成像效果获得市场关注。

本次活动还展示了光学麦克风、同轴扬声器 2.0、超小型侧键马达、磁吸无线充电模组、AR 眼镜光机、三折叠架构等多项前沿技术。

元宝上线「一句话文件转换」功能,支持 Office、PDF 等格式

昨天,腾讯元宝宣布上线「一句话文件格式转换」功能,用户可通过自然语言指令完成多种常见文档格式的快速转换。

据介绍,该功能覆盖拍照转文档、Word 与 PDF 互转、CSV 与 Excel、JSON 互转,以及多份 PDF 合并等场景。

具体来看,用户只需在元宝 App、网页版或电脑版上传文件,并以一句话描述需求,即可直接下载处理后的结果。

例如,拍摄纸质文件后可快速生成 Excel 或 PDF;Word 文档可一键转为 PDF,并避免排版错乱;数据处理环节中,CSV、Excel、JSON 文件可相互转换;多份 PDF 文件也可通过语音或文字指令合并为单一文件。

「飓风相机」上架 App Store

昨天,影视飓风团队自主研发的「飓风相机」App 正式上线苹果 App Store。这款应用主打专业影像功能,定位于为移动端用户提供更接近专业设备的拍摄体验。

在核心功能上,「飓风相机」支持 Apple Log 视频拍摄,并可实时套用专业 LUT,实现「所见即所得」的电影级画面效果。同时,应用提供手动对焦、曝光、白平衡等专业控制选项,满足创作者对细节的掌控需求。

此外,用户可通过一键分享功能,将调色完成的视频直接生成动态照片并发布至社交平台。

兼容性方面,「飓风相机」支持运行 iOS 17.0 及以上版本的 iPhone,Pro 版的价格为 69 元。

MiniMax 发布 Hailuo 2.3 视频模型与多模态智能体

昨天,MiniMax 稀宇科技正式发布视频生成模型 Hailuo 2.3,并同步推出全模态创作平台 Media Agent。

新模型在动态表现力、风格化支持以及人物微表情等方面实现显著提升,同时保持与前代 Hailuo 02 相同的定价策略。

据介绍,Hailuo 2.3 在肢体动作呈现、光影过渡和色调控制上接近实拍效果,能够更自然地展现人物表演与微表情。模型在动漫、插画、水墨和游戏 CG 等风格化场景中的表现也更为稳定和生动。

此外,Hailuo 2.3 对运动指令的响应速度和精确度均有优化,适用于电商广告等高频创作场景。

在成本方面,Hailuo 2.3 刷新了全球视频模型的性价比纪录,推出的 Hailuo 2.3 Fast 模型可在批量创作中降低最高 50% 成本。

与此同时,MiniMax 将今年夏季发布的 Hailuo Video Agent 升级为 Media Agent。该平台支持全模态创作,用户可通过自然语言输入需求,由系统自动匹配多模态模型,实现「一键成片」。

目前,Hailuo 2.3 已在海螺 AI 网页端、App 客户端及开放平台 API 全面上线,并提供每日免费试用额度。

海螺 AI 体验链接:https://hailuoai.com/

Media Agent 体验链接:https://hailuoai.com/agent

全球首款单芯片舱驾一体方案落地

10 月 28 日,全球首个搭载高通 SA8775P 舱驾一体方案的量产车型 —— 极狐全新阿尔法 T5 正式上市。

作为北汽极狐的核心技术合作伙伴,卓驭科技以架构革新之力,推动汽车智能从 「舱驾分立」 迈向 「舱驾一体」,真正实现 「架构统一、体验升级」。

此次舱驾一体方案落地,是行业首个基于单芯片舱驾一体方案实现无图端到端城市 NOA,并且实现了三方面能力:

- 支持全场景的智能辅助驾驶功能,覆盖无图端到端的城区领航辅助和高速领航辅助、自动泊车辅助、跨层记忆泊车等功能。

- 得益于舱驾数据直接交互的优势,用户操作响应速度显著提升。

- 基于量产的传感器和算力+方案,卓驭后续将通过持续模型和算法升级,让辅助驾驶系统「常用常新」,持续提升用户长期价值。

喜茶推出「heytea Halloween」节日限定活动

随着万圣节气氛渐浓,喜茶近期推出「heytea Halloween」节日限定活动,将于 10 月 30 日起在全国部分门店上线。

伴随限定活动,喜茶推出两款搞怪周边,呼应万圣节氛围为消费者带来独特的节日灵感。其中:

- 「萌鬼」喜茶杯公仔周边结合南瓜、幽灵、绷带木乃伊等标志性元素设计,分为「南瓜喵」「喜小灵」「茶乃伊」三个样式;

- 夜光卡牌周边则融合了喜茶多肉葡萄等产品与塔罗牌元素,结合三款人气产品的不同风味展开运势解读,为消费者带来新的节日饮茶趣味。

在万圣节更为流行的海外地区,喜茶则于更早的 10 月 16 日,在美国、加拿大、英国、新加坡各海外区域门店中,率先上线与百老汇音乐剧《魔法坏女巫(WICKED)》联动产品「WICKED MATCHA」,引发广泛打卡热潮。

这款联动产品结合《魔法坏女巫》中 Elphaba、 Glinda 两位主角的魔法灵感进行研发,为喜茶今年全球热卖的千目抹茶加上了一抹柚香粉色云顶,粉与绿的冲击性配色,抹茶与果香的神奇碰撞,让这款产品迅速走红海外社交平台。

不仅喜茶各海外区域门店排起长队,国内消费者也纷纷表示想要尝鲜。

New Balance 再释「抹茶」主题,991v2 新配色即将登场

阿姆斯特丹设计师 Daniëlle Cathari 与 New Balance 再度合作,推出全新 991v2「Reverse Matcha」配色。

这一版本延续其首款「抹茶拿铁」灵感鞋款的主题,但在配色上进行了反转处理:鞋面覆盖棕色麂皮,搭配抹茶绿色网布基底,鞋底则采用白色、卡其色与黑色的标准组合。

Cathari 于 2023 年首次与 New Balance 合作推出的 991v2「Matcha」因极度稀缺而在二级市场价格一度接近 1500 美元(约 10650 元人民币)。此次新作预计将通过 Kith Women 渠道独家发售。

值得注意的是,Cathari 曾在 2024 年 10 月辞去 Kith Women 创意总监一职,因此本次合作的发售规模与市场反响备受关注。

CASETiFY 推出《魔卡少女樱》联名系列手机壳

近日,CASETiFY 宣布携手日本经典动画《魔卡少女樱:透明牌篇》推出全新联名系列。该系列以「透明牌」为灵感,将复古 Y2K 风格与魔法元素相结合,推出多款限定电子配件。

此次联名系列以粉色为主视觉,融入魔杖、守护兽小可、魔法书等标志性元素,旨在唤起粉丝的青春记忆,并将日常电子配件转化为具象化的「魔法道具」。

其中,个性定制款「来电显示」手机壳允许用户选择小樱、小狼或可鲁贝洛斯等角色界面,让来电体验与魔法世界相连。

此外,系列还包括融入透明牌与梦之杖坠饰的魔法手机挂链,以及守护兽小可造型的毛绒耳机收纳袋。CASETiFY 表示,该系列不仅满足粉丝的收藏需求,也通过细节设计为日常使用增添趣味与灵动感。

小米汽车发布纽北纪录片《6’22”091》

昨天,小米集团董事长、CEO 雷军在微博发文,宣布小米汽车「征战纽北纪录片」《6’22”091》,以纪念其在纽博格林北环赛道获得官方认证圈速成绩一周年,全片长 1 小时 9 分钟。

2024 年 10 月 28 日,小米汽车首次取得该成绩,到昨日正好满一年。影片完整回顾了小米汽车在纽北赛道的挑战过程,并向长期关注和支持中国汽车工业进步的用户表达谢意。

纽北赛道被视为全球最严苛的性能测试场之一,圈速成绩常被用作衡量汽车性能的重要指标。

《疯狂动物城 2》中文预告公布

昨日,迪士尼官方发布了《疯狂动物城 2》的最新中文预告片,展示了湿地市场、火兽节等新场景,并揭示了新角色「蛇盖瑞」的登场。该角色由奥斯卡奖得主关继威配音,肩负家族秘密使命,在动物城百年庆典中引发波澜。

《疯狂动物城 2》已确认将于 11 月 26 日在中国内地与北美同步上映。影片延续前作剧情,兔警官朱迪与狐尼克再度携手,直面动物城深藏的秘密,并迎来全新挑战。

据《南方日报》报道,《疯狂动物城》系列自 2016 年上映以来,全球票房达 10.2 亿美元,中国内地票房 15.3 亿元人民币,至今仍为进口动画电影票房冠军。今年 8 月,该片曾以 4K HDR 修复版重映,并在片尾加入衔接续集的彩蛋。

《过关斩将:猎杀游戏》北美档期推迟

斯蒂芬·金小说改编、埃德加·赖特执导的科幻动作惊悚片《过关斩将:猎杀游戏》档期推迟一周,由原定的 11 月 7 日北美上映调整至 11 月 14 日,片方计划争取更多 IMAX 场次。

影片故事聚焦一档名为《过关斩将》的真人秀节目:参赛者需在 30 天内逃避「猎人」追杀,若能存活即可获得巨额奖金。影片男主角本·理查兹选择参加这场高风险竞赛,剧情围绕其生存挑战展开。

《象山发光事件》北京首映

惊悚悬疑电影《象山发光事件》于 27 日在北京举行首映礼。

导演编剧赵域、监制常雷、领衔主演小沈阳及多位主创出席活动,并与观众交流影片幕后细节。影片采用伪纪录片手法拍摄,将于 10 月 31 日在全国上映,目前已开启预售。

首映礼以「勿近光源」为主题,现场嘉宾包括资深电影人沈克敏、经纪人徐子玥及爱奇艺制片人覃楠岚。

本片中,小沈阳首次挑战惊悚题材,突破以往喜剧形象,在片中饰演深入禁地探寻真相的角色。导演赵域表示,小沈阳的表演细腻且极具反差,甚至在现场让人一度认不出其身份。

影片设定中「光源即危险」的元素让观众印象深刻,部分观众在观影后直言「害怕光源」。导演透露,影片结局刻意保留悬念,希望观众在走出影院后仍能产生「细思极恐」的回味。

36kr

这种没一点活人感的短视频,凭什么骗过全网

AI生成的短视频爆火之后,所有人仿佛都被迫兼职当起“AI判官”,刷到一段视频,就要猜是不是AI生成的。有人甚至在电影节上都在质疑演员是否被偷偷换脸。

人们越来越像是坐在一个无形的评审团里,时刻准备揭穿某个镜头的“造假”。这种怀疑越来越像是一种心理负担。

媒介技术越发达,我们彼此信任的成本也就越高。不过,人类就是这么矛盾,既想保持警惕,又无法抗拒好奇;既担心被欺骗,又享受被惊艳。

十月的好莱坞有点紧张。哦,不对,不只是好莱坞,可能身在横店的影视行业从业者也有点紧张。

前有AI演员蒂利·诺伍德(Tilly Norwood)亮相苏黎世电影节,后有OpenAI的 CEO萨姆·奥特曼(Sam Altman)满世界上演《碟中谍》和《霸道总裁爱上更年期的我》。这位CEO一会儿在大厂被训,一会儿操着一口流利的普通话在街采,还要抽空去超市偷显卡。演技之高,戏路之宽,唯有青霞曼玉能与之一较高下。

(图/《武林外传》)

隔着屏幕的看客感觉已经进入了一个混乱次元——而这一次,混乱的源头就是OpenAI新推出的Sora APP。这款应用不仅能通过文字直接生成视频,连页面设计都跟TikTok相差无几,竖屏、瀑布流、算法推荐一个不落,人送外号“AI版抖音”。

一个跨步,短视频平台终于也进入了“自动驾驶时代”。

真·劳模在LA。(图/社交媒体截图)

Sora之外,各国的文生视频AI赛道发展也是如火如荼。Grok、即梦……比比皆是,言出法随的微电影指日可待。

事到如今,美国演员工会坐不住了,忙发布公告称,“最能打动观众的不是仿制,而是真实。只有当活生生的演员为故事赋予生命时,真实的连接才会发生。”

问题在于,观众还愿意为“真实”买单吗?

01 别让小猫拍这些

外网大爆AI猫片《真假猫咪公主》目前更新到第四集,热度丝毫不逊一线大剧。但剧情其实只需“长发公主”和“千金归来”八个字就能概括,画面也是集合你所能想象的一切涉及AI风格的元素。然而就是这样粗糙的“一眼AI”,却能单集斩获1.8亿播放,迪士尼看了估计都要沉默。

经典中式短剧风收割全球观众。(图/社交媒体截图)

不过,在AI宠物短剧这条赛道上,洋抖落后国内至少一个季度。且不论佳作频出的AI年度抽象顶流——蓝色月半猫,它不仅喜欢吐槽,还会每天“报日历”般重复着“讨厌周一、喜欢周五”,网络热梗信手拈来,用一种“淡淡死感”的声音化身网友嘴替。

早在6月各短视频平台就推出了《比熊殿下她权倾天下》《霸总雪纳瑞爱上我》之类的爆火短剧。这类剧集真不只看个乐和,其变现能力远比想象中要高,有的IP单条定制广告报价高达8万元,几乎追平真人短剧的商单定价。

月半猫。(图/社交媒体截图)

“看了开头就知道狗血,但就是忍不住看下去。”

明知套路,甘愿上当,当下的影视生态就是如此。作为“奶头乐”,没有人在乎自己的“电子宠物”和“赛博嘴替”是否真实,只要足够抽象,创作者就能分得一杯羹。而解构真实,是AI的母语,也恰恰是其强项。

此时的AI只是网友们play的一环,光是亮出“月半猫”这个形象,情绪价值就能瞬间拉满。

但这份快乐,似乎只能维持在“猫咪炒菜”这个尺度上。当AI开始不再满足于让小猫炒菜,而是发展到让李小龙打碟、让迈克尔·杰克逊说脱口秀的时候,从娱乐到威胁,仅仅一步之遥。

02 焦虑, 谁的锅?

如果你刷久了Sora的视频,就不由得会萌生出一种荒诞感受,会产生一种奇特的错觉:下一条一定会更真实。它让人不断刷新,又不断怀疑。起初你会惊叹于它无懈可击的画面、惟妙惟肖的微表情。可看多了,总不免困惑,既然我知道这些都是假的,那我为什么还要继续刷这些AI视频?

AI的演进速度实在太快,快到伦理讨论还没展开,争议就已刷新。Sora 2的出现,比想象中更具戏剧性。它几乎每天都在引发新的混乱。昨天人们还在为“AI能拍电影”感叹,今天就忍不住吐槽“一言不合就是违反政策”。

这种心理落差很快反噬了Sora的热度。对大多数人而言,新鲜感往往只能维持几天,时间一长就会显得空洞乏味。短短三周时间,Sora的App评分就跌到了2.8。

sora生成段子视频。(图/社交媒体截图)

压力是持续传递的, OpenAI风光背后,代价不菲。虽然受邀用户可免费使用Sora,但运营成本惊人。根据初代版本定价测算,每个生成视频消耗约1美元算力成本,而用户每天可轻易产出上百条。

传统社交媒体的精妙之处在于用户无偿创作内容,广告商买单。但如果平台每条动态都在亏钱,这种视频应用的商业前景并不明朗。可见,哪怕是AI的世界,内容依旧是最贵的东西。

创作者端的困境更加显眼。OpenAI标榜Sora 2具备“前所未有的创造力”,确实,它让每个人都能轻松生成短视频。然而当门槛接近于零,作品的差异也就被稀释。海量产出带来的是同质化堆叠,目前热梗看似多样,实则指令来回就那么几条,不过是替换关键词。“千篇一律”这个词在此得到“完美”诠释。

算法虽然大幅降低了创作成本,但同时也抬高了原创的稀缺性。然而,以好莱坞为代表的专业创作者们的日子同样不好过,演员、编导、后期——几乎所有岗位都感受到了那一丝“被替代”的寒意。不少从业者的焦虑甚至升级为愤怒。

演员工会发布上述公告的原因是反对科技公司将“合成演员”(synthetic performers)作为营销事件,维护“表演必须以人类为核心”的信条,同时捍卫会员的合法劳动权益。演员工会特别指出,现有立法还无法阻止AI开发者未经许可从网上抓取含有人类表演者的视频训练模型,所以要积极争取权利。

声明义正词严。然而,另一端,AI正以惊人的速度被主流娱乐产业接受。苏黎世电影节的红毯上,一位名叫 Tilly Norwood的“AI女演员”亮相。她有自己的社交媒体账号,除了分享工作行程,还会积极和粉丝互动。

蒂利·诺伍德试镜片段。(图/Tilly剧照)

从技术层面讲,Tilly已经和真人明星没什么区别了。这一幕不由让人想起一部2002年的电影《西蒙妮》(S1m0ne)——阿尔·帕西诺饰演的过气导演创造了一个完美的虚拟女演员,其迅速成为全球巨星。电影里,导演最终因为无法承受谎言的重压而选择“杀死”她。而二十多年后,Tilly已经不再需要导演偷偷操控。

(图/《西蒙妮》)

创造她的Eline坦言,好莱坞从最初的戒备到如今的主动接触,不过几年时间。AI演员成本更低,行程可控,也不会耍大牌。对于一个陷在预算与罢工双重困境中的行业来说,这样的存在近乎完美。

而演员工会的愤怒多少显得有些复杂,不难理解行业自保的本能反应,可以说无力感还是占了大部分。因为他们清楚地意识到,AI并不是凭空降临的威胁,而是顺理成章的结果。

过去十年,好莱坞早就不是什么技术纯洁主义者了,算法在演员的脸上与套路化剧情走向中留下太多痕迹。Tilly的出现,只是把工业化美学推到了极致。这个行业长久以来的运作逻辑,终于被技术撕开最后的遮羞布。

原来“造星”这件事,真的可以是字面意义上的制造。

03 我也不想当AI判官

AI火成这样,带来的不只是产业的焦虑,还有观众的疲惫。现在刷短视频、看电影预告片,评论区经常出现一句话:“这是不是AI做的?”

(图/社交媒体截图)

真实还存在吗?真实还重要吗?

当AI生成内容占据了信息流的99%,追问真假的意义似乎已经没那么大。

但答案是,依然重要。

不然OpenAI也不会火速推出去水印服务,顺便再收一波钱。这个操作本身就很有意思——在大部分观众眼中,人工手搓的内容就是比AI生成的来得可信,哪怕两者看起来一模一样,而水印是目前唯一能识别的门槛。

牛津大学研究显示,互联网中AI生成内容已过半。(图/《More Articles Are Now Created by AI Than Humans》)

甚至不少视频将真实发生的离谱事件打上AI水印,而留给网友的则是是否AI生成的争吵,现实和虚拟的界限正在模糊。而真实,已经成了一种可以被明码标价的商品。

(图/《西蒙妮》)

对AI内容的不适感,本质上来自两种恐惧:一是分辨不出真假,二是被分辨不出真假这件事激怒。前者是能力问题,后者是尊严问题。当你发现自己被一段AI视频骗得团团转,甚至为它流泪、愤怒,直到转发后才发现上当,那种“被操纵”的愤怒是技术恐惧与控制感的丧失的双重叠加。

从原始社会到前AI文明,人类从建立信任、传递信息到构建共识的基础,都是眼见为实见。但当AI可以生成以假乱真的任何画面,这套认知体系就开始逐渐崩塌了。倒不是说完全失效,而是你得先证明这是真的。

抵制AI内容的笔记。(图/社交媒体截图)

这也是Sora的出现让观众的角色变得前所未有地尴尬的原因。

如今在互联网上,所有人仿佛都被迫兼职当起“AI判官”,刷到一段视频,就要猜是不是AI生成的。有人甚至在电影节上都在质疑演员是否被偷偷换脸。

人们越来越像是坐在一个无形的评审团里,时刻准备揭穿某个镜头的“造假”。这种怀疑越来越像是一种心理负担。观众不是来做法医的,每次判断真伪,都在消耗观看的乐趣。欣赏的根本,至少不该建立在追查素材来源的基础上。

媒介技术越发达,我们彼此信任的成本也就越高。不过,人类就是这么矛盾:既想保持警惕,又无法抗拒好奇;既担心被欺骗,又享受被惊艳。

这就成了当下AI生成内容最大的悖论:每次争议都在呼吁监管,但监管越多,越显得无力。因为问题在于我们还没想清楚,到底想让AI参与创作到什么程度。

(图/《西蒙妮》)

我们也许正处在一个过渡阶段,真与假,正在从技术问题变成心理问题。过去相信眼见为实,现在只能“怀疑为常”。

所以,当大家在激烈讨论“AI会不会取代演员”,我脑子里蹦出的却是另一句灵魂之问——剪秋到底有没打开食盒?现在明明有视频为证。

参考资料

[1]差评X.PIN——这很离谱,但猫狗的AI土味短剧真能月入50万

[2]首席商业评论——Sora2颠覆抖音?新的万亿行业赛道出现了

[3]南风窗——她一出道就爆红,好莱坞明星们气炸了

[4]华尔街见闻——Sora 2强化新叙事:AI吞噬APP,Meta应声下跌

[5]The economist——AI video: more than just“slop”

本文来自微信公众号“新周刊”(ID:new-weekly),作者:Fleming,编辑:程迟,36氪经授权发布。

单品众筹破千万美金,智能投影仪赛道杀出一匹深圳黑马|Insight全球

编者按:当出海越来越成为一家中国公司核心战略时,如何征战全球市场就成为一个极其专业的话题。在全球化的演变中,已有不少中国品牌站立潮头。鉴于此,硬氪特推出「Insight全球」专栏,从品牌成长与变迁,探索中国品牌出海的前沿方向与时代契机,为出海玩家与行业提供思考与启发。

这是我们专栏第51期——中国硬件企业虽坐拥完善供应链,却长期缺席全球高端市场,海高特科技以独特的“美国品牌+中国研发”模式,在激烈的投影仪赛道中迅速破局。旗下AWOL Vision与Valerion品牌精准把握欧美家庭对便捷操作与沉浸体验的需求,凭借高端产品定位快速打开市场,2024年企业营收数亿。近日,我们同海高特创始人Andy Zhao聊了聊。

作者|黄楠

编辑|袁斯来

中国硬件公司坐拥全球最完备的供应链、最努力的竞争对手、最灵活的头脑,但矛盾的是,能在高端产品领域立住脚的产品仍然相当罕见。

投影仪公司海高特科技,在一个低价白牌泛滥的赛道打破了常规。

作为美国品牌AWOL Vision的深圳研发与市场中心,海高特于2020年成立。公司以超短焦激光投影为核心产品,售价覆盖1899-5999 美元区间,以“开箱即用”的便捷体验与影院级画质,迅速在北美市场收获了一批种子用户,在亚马逊同类目产品销量中排名前列。2024年,这一个品牌营收破亿。

同年,AWOL Vision瞄准高端用户,发布长焦投影子品牌Valerion,首款产品VisionMaster系列投影仪聚焦沉浸式影音体验,定价2000-5000美元。

即便价格数倍于同类产品,VisionMaster在登上Kickstarter的45天内、筹集了千万美金资金,成为该类目全球排名第一的项目。

两个品牌得以在海外市场迅速打开声量,源于海高特团队对目标市场的精准把握,解决欧美家庭用户在有限的家居空间内,实现便捷操作与沉浸式视听体验的核心诉求。

与此同时,海高特作为品牌背后的中国研发中心,能充分发挥深圳在硬件制造领域的集群优势,具备成熟的供应链体系与快速响应能力,转化为产品研发与迭代的核心竞争力,将迭代周期缩短至行业平均水平的2/3。

Valerion在海外展会上(图源/企业)

全球七成以上的投影仪产自中国。然而,近年来国内市场需求逐渐见顶,行业陷入内卷的竞争,百元级产品占据主流,千元级别已不鲜见,定位中低端的品牌难以找到突围机会。

凭借独特的“美国品牌 +中国设计中心”模式,AWOL Vision和Valerion的崛起证明,在早已拥挤不堪的赛道中,依然可以依靠精准用户洞察与技术迭代闯出新的蓝海。其关键不在于陷入价格战,而在于跳出国内市场的缠斗逻辑,在全球视野下重新理解创新与价值。

寻找细分场景

目前在海外市场,家庭影院的布置需求与居住条件密切相关。尤其在美国,多数家庭拥有较大居住空间,家庭影院逐渐从可有可无转为刚需。

然而,尽管家庭影院设备属于长周期产品,换机动力频率较低,但前期凿孔、布线、组装调试等流程,安装复杂与人工成本极高,也让许多用户望而却步。根据传统高端家庭影院方案测试,部署一套家庭影院系统工程的总成本可达5万至6万美元。

欧美老品牌似乎并不在意这一痛点。爱普生、索尼等老牌大厂表现迟钝,部分产品仍用陈旧系统与接口,无法无线投屏、语音控制。至于安装便捷、智能化交互、系统流畅性等体验,更是长久没有改进。

但作为一个常年生活在美国、在智能产品中浸泡多年的中国人,海高特创始人Andy Zhao看到了市场机遇。

因此在产品规划初期,Andy Zhao就将“开箱即用”的便捷性作为核心产品特性之一,旨在彻底简化用户从购买到使用的整个流程。

首先在结构方面,海高特的产品采用了金属骨架与轻量化设计,便于用户在客厅、卧室、庭院等不同场景中随意移动。AWOL Vision和Valerion将所有接口隐藏在盖板或凹槽内,保持造型整体性,避免线材外露造成的杂乱感。

Valerion极简的外形设计(图源/企业)

使用过程中,传统投影仪需用户手动反复调校对焦、梯形校正及画面参数,一旦位置或场景变动后又需重新操作。

而海高特的产品可以实时感知环境,支持自动对焦、自动梯形校正、自动画面避障和幕布对齐,即使用户挪动设备,画面也能始终保持最佳画质。

软件交互层面, AWOL和Valerion都支持语音控制,设备中预装了Netflix、Disney+、HBO Max等主流流媒体平台,不用额外安装应用或配置参数;手机、平板等移动设备也可以一键将内容投射到大屏。

事实上,这些都是国内投影仪的标配。海高特以国内的硬件技术,降维打击了欧美企业。

Andy Zhao坦言,智能投影仪并非是个技术壁垒很高的品类,差异化体验才是构建核心竞争力的关键。

这是中国硬件公司长期以来的短板,也是海高特得以杀出重围的关键。

通过这种海外高端品牌定位、加深圳研发制造支撑的协作模式,既确保了产品与目标市场的精准对接,又通过中国供应链优势实现了快速迭代与成本控制。

基于Valerion产品打造的家庭影院(图源/企业)

AWOL Vision主打超短焦技术,适用于明亮环境的客厅场景,支持开灯观看,也是竞争最白热化的赛道。而Valerion则是长焦投影仪,专注于黑暗环境下的沉浸式观影,服务于影音室、后院户外等个性化场景,强调影院级画质与氛围感。

尤其Valerion在中国公司相对陌生的场景中做深做透,建立起了品牌认知。这种路径也在近几年中国硬件公司冲击高端市场中得到验证。

消费级价格、专业化体验

找准Valerion定位后,海高特充分调动起中国强大的硬件研发和制造能力。

在欧美地区,家庭影院已成为许多家庭娱乐系统的标准配置,其布置方式也因居住环境和需求差异而呈现多样化。

一部分用户倾向于选择相对密闭的空间进行打造,例如地下室或隔音影音室,以追求极致的声画沉浸体验;也有家庭选择将客厅改造为开放式影音区域,兼顾日常起居与观影功能。

由于家庭使用环境复杂,因此用户在使用长焦投影仪时,常面临两大核心痛点:一是不同场景下色彩还原偏差,导致画面 “失准”;二是暗场画面细节丢失,黑位表现浑浊,继而影响沉浸式体验。

以三色激光为代表的专业影院技术下放,为海高特团队提供了新的思路。

从技术发展历程来看,三色激光技术原本多用于专业影院级设备,其色域覆盖、色彩纯度和亮度表现远优于单色激光和LED方案。

不仅如此,三色激光光源的寿命长、光衰慢,配合消散斑技术,在长期使用中稳定性高,因此用户的视觉体验也会更舒适流畅。

2021年前后,三色激光仍处于发展早期,商用化程度低,一般用于数万元的高端商用投影仪或激光电视产品中。

为了压低技术门槛,海高特花了一年以上研发,将三色激光应用到了C端产品Valerion中。

Valerion在户外场景中应用(图源/企业)

他们还解决了长焦投影仪惯有的画面问题。

受光路设计、使用环境光线及投射介质影响,长焦投影仪容易出现色彩偏移,比如红色偏橙、蓝色偏紫或是整体色调偏冷偏暖。因此,Valerion在VisionMaster系列产品中引入了色彩轴校准技术,即通过调整红、绿、蓝三原色的色轴坐标,来确保每种颜色都能精准落在标准色域的指定区间内。

最终,白天强光环境和夜间暗环境,都能保持色彩的饱和度和色调的一致性,避免因色彩偏移导致出现了失真感。

另一个常见的问题是暗场画面的“灰雾感”,也就是黑色区域发灰、暗部细节被淹没的问题, 黑暗场景中人物的发丝、物体纹理无法清晰分辨。

为了让暗场观影体验更好,Valerion在产品中搭载了高级黑位控制技术,通过动态调节不同区域的光源输出强度,当出现暗场内容时精准降低暗部亮度,从而在保留丰富细节的同时,避免传统投影中黑色泛白、画面发灰的问题。

比如常见的科幻电影中,当出现大面积的宇宙场景时,用户既能感受到星空背景深邃纯净的黑色,又可以清晰辨别星球表面的细微纹理与阴影层次。

高质感色彩还原效果(图源/企业)

“当前创新产品能领先市场半年已经很难得了,硬件参数极易被同质化的,最终竞争的核心并非价格或短期产品性能。”Andy Zhao告诉硬氪。

深圳硬件企业从不缺席任何一片蓝海市场。随着国内投影产业技术日趋成熟、市场竞争持续内卷,越来越多的品牌正将目光投向海外,试图复制相似的出海路径。

在全球竞争迈向深水区的今天,单点产品创新带来的窗口期正变得越来越短。海高特的案例,验证了“技术价值”的路径可行性,硬件产品的底层,终究还是技术壁垒。

“不到5个月亏200万”,牛肋条自助,正在“收割”加盟商

从“顶流”到“翻车”,牛肋条自助的泡沫正在加速破裂!

去年年底,凭借“人均60元左右+无限畅吃”的模式,牛肋条自助在短短半年内迅速风靡全国。

热浪之下,连锁品牌加速跑马圈地,新兴玩家也争相涌入。像是2024年上半年才成立的“林真真牛肋条放题”,仅用一年时间就开店超100家。

然而好景不长,不到一年,这个一度疯狂扩张的网红品类就迎来了关门潮。曾被市场“寄予厚望”的头部品牌“林真真”,其公司也已注销离场。

在社交平台上,众多加盟商倾诉投资“牛肋条自助”失败的经历;甚至有业内人士直言:“牛肋条自助是2025年谁碰谁死的网红项目。”

从品类爆红到集体败退,牛肋条自助究竟经历了什么?

1

“不到5个月,预亏200万”!

牛肋条自助烤肉被现实打回原形......

近两年,伴随牛肉价格的持续下行,一批以牛肉为主的餐饮品类迎来爆发。

从牛杂煲、生烫牛肉米线,到鲜切牛肉火锅,多个细分品类快速崛起,由区域走向全国,形成一股强劲的“牛肉餐饮”风潮。

随着各赛道热度攀升,一批连锁品牌也迅速跑出。它们多以“高性价比”或“鲜切牛肉”作为核心卖点,强化产品价值感,抢占消费者认知。

踩中这波成本与认知红利的牛肋条自助,也随之迅速崛起。一时间,相关门店在全国范围内密集铺开,成为餐饮行业的现象级品类。

然而,火爆不到一年,这个曾被疯狂追逐的赛道就迎来批量闭店潮。

1、牛肋条自助倒闭汹涌,成了二手回收商的“常客”

“今年谁干谁死的餐饮品类——牛肋条自助。” 这句在业内流传的判断,正被不断涌入的闭店现实所印证。

在河北从事二手餐饮设备回收的“狗哥”,近期已接连回收多家牛肋条自助品牌的设备。其中不少品牌生命周期不足一年,甚至未能收回成本,便已匆匆退场。

这并非区域现象。从河北、辽宁到浙江,类似的闭店剧本正在全国多地同步上演:浙江一家牛肋条自助店装修一个月,仅营业半个月就关门;安徽六安一家加盟“张小匪烤牛肋条任吃”的店面,从4月启动预售到10月彻底停业,存活期刚满半年;四川更有创业者投入超50万元开店,结果不到半年便黯然离场......

即便是仍在支撑的门店,也普遍面临客流持续滑坡的窘境。而这场退潮,似乎才刚刚开始。

2、头部品牌公司注销跑路,几十家加盟商被“遗忘”在角落

在这场牛肋条自助洗牌战中,曾红极一时的头部品牌“林真真牛肋条放题”,也未能幸免。

该品牌自去年底爆火后开启疯狂扩张,门店数量从最初的10家店一路飙升至近百家。高峰时期,不少门店月销售额突破百万元。

然而据天眼查最新数据显示,“林真真”门店数量已开始回落,目前仅剩83家仍在运营。更关键的是,其背后的品牌管理有限公司已显示为“注销”状态。

母公司悄然抽身,留下几十家加盟商陷入“品牌空心化”困局——没有总部运营支持,没有供应链保障,也没有持续的产品迭代。

如今,这些曾经押注“林真真”的创业者,如今只能独自面对激烈的市场竞争与不断下滑的客流。

3、被割韭菜的加盟商亲述:“不要贪快钱”,不然最终会成为退潮后的裸泳者

在这场牛肋条自助闭店潮中,受伤最深的莫过于真金白银投入的加盟商。

一位商业博主在社交平台自曝,其加盟 “林真真” 品牌后,不到5个月的时间亏损预计超过 200 万元。据他透露,其中 100 多万元为品牌代理费,另外 90 多万元用于开设两家门店。然而,随着品牌公司注销,代理费至今未能追回。

他也进一步指出了导致亏损的三大核心原因:品牌推广爆发期缩短,原先平台推流能维持 7 天左右,如今仅能维持 3-4 天,流量数据大幅下滑;业绩断崖式下跌,营业额不止 “腰斩”,而是直接跌至原先的 20%-30%;运营支持缺失,品牌方所谓的 “专业团队”,实为外包的第三方人员,服务分散、精力有限,一旦牛肋条自助品类走弱,资源即被转移至其他品牌。

回顾这段经历,他总结出最深刻的教训:“千万不要贪,品牌热度来得快去得更快。” 许多网红项目生命周期极短,加盟者若仅被短期流量吸引,忽略可持续运营能力,最终只会成为浪潮退去后的 “裸泳者”。

2

牛肋条自助,为什么逃不过“一年周期”?

从走红到退潮,牛肋条自助尚未满一年,便已迎来关店潮。这一现象,为餐饮人敲响了怎样的警钟?

1、牛肉价格不稳定,成本控制存在不确定性

近两年牛肉餐饮的创业热潮,与其说是品类创新的胜利,不如说是一场由上游牛肉价格下行带来的 “成本窗口期” 红利。

然而,这种建立在单一原材料价格低点之上的商业模式,始终面临一个根本性挑战:价格一旦回调,整条增长曲线就可能崩塌。

对于牛肋条自助这类高度依赖牛肉的业态而言,食材价格波动始终是悬于头顶的 “达摩克利斯之剑”。该类品牌在起步阶段大多依托牛肉低价期的阶段性成本优势,构建出 “高性价比” 的产品卖点。

然而,这类模型的利润结构本就脆弱,一旦牛肉价格进入上升通道,其盈利空间将直接受到挤压。目前,压力已开始显现,自今年3月起,牛肉价格就已逐步回升。

据卓创资讯数据显示,截至 9 月,国内鲜牛肉月均交易价格为 61.88 元 / 公斤,与去年同期相比,涨幅达 27.33%,终端门店逐渐感受到成本端的持续施压。

更值得关注的是,这一波动并非短期现象。供应的缺口以及持续的供需错配,将推动牛肉价格上行。机构预测,本轮国内牛肉价格的上行周期,将从2025年下半年开始维持2.3-3年,牛肉价格的高点或在2028年底出现。届时,牛肉的批发均价或将达到78-93元/公斤。

2、自助模式即是卖点又是难点,供应链仍然是老大难问题

面对牛肉价格的波动,供应链能力已成为决定此类餐饮模式能否跑通的核心变量。

面对成本上涨,品牌往往陷入两难:若将成本直接转嫁至售价,很可能抑制消费意愿,影响客流;若维持原价不变,则利润空间将持续收窄,威胁经营根基。如何平衡成本与体验、守住盈利底线,成为整个品类必须面对的命题。

在这一过程中,供应链资源的分化正逐步凸显。那些具备稳定低价货源,或能以平价获取优质食材的供应链商家,不仅能帮助品牌有效平衡毛利结构、强化集采优势、降低运营成本,还能同步保障顾客体验与投资回报率,构建可持续的运营闭环。

然而现实是,目前牛肋条自助烤肉业态仍以单店与小型连锁品牌为主,普遍缺乏体系化供应链支持。在 “流量造神、打卡经济” 盛行的当下,不少品牌倚重营销却轻视后端建设。前端热度无法得到后端品控的支撑,模式终究难以持久。一旦面临成本剧烈波动,缺乏供应链支撑的品牌将首当其冲,面临生存危机。

可以说,在这一赛道中,供应链已不仅是竞争壁垒,更是生存底线。不具备供应链基础、仅凭热情入局的创业者,很难在这场耐力赛中走到最后。

3、网红品牌速生速死,不仅坑了一批创业者,也拖累整个品类

任何品类都有周期,但如今网红起来的周期正在压缩。曾经一个品类的寿命能以 “年” 为单位计算,如今却只剩下数月的光景。

从天水麻辣烫、冒烤鸭,到近期的牛肋条自助,它们在社交媒体上从刷屏到沉寂,往往不超过半年。而在加盟模式的助推下,门店的倒闭速度甚至比品类过气的速度还要快。

以牛肋条自助为例,其集中闭店的背后,反映出以下几类原因:

首先,多数网红品类的爆发,并非源于产品革新或供应链升级,而是依赖人为造势与资本放大。品牌方擅用 “打榜 + 网红店” 组合拳,在闹市区打造 “样板店”,营造虚假繁荣,吸引小白加盟。

有业内人士透露,某些牛肋条自助品牌 “一年能放出上百家店,开始宣称毛利能达到 40%-44%,但实际运营中毛利只能做到30%,甚至新开店的时候连 20% 都到不了。”

其次,即使品类本身有潜力,但在爆发期极易涌入大量投机者。他们不以长期经营为目的,而是通过抬高加盟费、降低食材成本等方式 “杀鸡取卵”,迅速透支品类信誉。最终,整个赛道尚未成熟,就已提前老化。

再次,当热度退去,没有后端支撑的品牌只能陷入价格战与品控失控的双重泥潭。所谓的网红模型,本质上是一场针对加盟商的资产收割 —— 流量退去之后,留下的只有关店的废墟,和一批还没算清账就已出局的创业者。

职业餐饮网小结:

成也萧何,败也萧何。

牛肋条自助随牛肉价格下行而兴起,也因价格上涨而颓败。任何一个品类都逃不过周期的轮转。

尽管网红品类凭借流量红利,为餐饮人提供了快速切入市场的机会,但餐饮经营终须回归本质 —— 唯有依靠扎实的产品、持续的运营和体系化的创新能力,才能实现从 “爆红” 到 “长红” 的跨越。

盲目入局者,大多只能成为行业浪潮中的 “炮灰”。

本文来自微信公众号“职业餐饮网”,作者:小鱼,36氪经授权发布。

小时候课本上的臭氧层空洞,现在怎么没人提了?

臭氧层空洞,各位有印象吧?

小时候的电视、课本上天天说,跟世界末日似得,结果现在怎么感觉好像没人提了。。。

前几天我还专门搜了一下,网上啥说法都有。

有人说其实这空洞每年都有,很正常;还有人说,这压根就是发达国家为了限制咱们发展搞出来的阴谋,美国人太坏了。

但事实嘛,其实都不是。

正确答案是,臭氧层空洞这事儿,快被咱们人类自个儿给修好了。。。

我当时看到这个结论也懵了,不是说威胁全人类嘛,结果就这?

不过深扒了一下才发现,这事儿其实也挺传奇的,这是人类历史上第一次,真正意义上为了同一个目标,团结一致办成的大事。

至于具体怎么个事儿,那得从上世纪40年代说起。

当时有个带发明家,托马斯·米基利。

这名字你可能没听过,但这人的纯度极高,他可能是全世界间接杀人最多的单体碳基生物,凭借一己之力拉低1.7亿美国人的平均智商,一个真正捅破了天的人,被称为史上最邪恶的科学家。

如果说人类历史上最能闯祸的人是谁,那这哥们必定榜上有名。因为他有俩极品发明,一个是含铅汽油,另一个就是氟利昂。

在氟利昂之前,冰箱空调用的制冷剂是氨气和二氧化硫。一个有毒易燃易爆,一个剧毒强腐蚀性,家里安空调就跟安个炸弹似的,一旦漏了爆了人就没了。

但氟利昂这玩意儿,简直堪称神品。因为无毒、不燃、无腐蚀性、化学性质稳定得一批,还好压缩易挥发,所以不管是空调冰箱香水发胶,还是洗涤剂灭火剂发泡剂,反正只要能用溶剂你就可劲造就完了。

为了证明它有多安全,米基利在新闻发布会上,甚至当众吸了一口氟利昂,顶级过肺以后缓缓吐出,吹灭了一根蜡烛。

这一下,氟利昂直接封神,成了现代工业的液体基建了。

东西很牛逼,但在全世界爽了40年后,有人发现不对劲了。

1973年,一个叫马里奥·莫利纳的墨西哥化学家,和他导师出于纯粹的好奇,开始研究一个问题:咱们喷了这么多化学性质如此稳定的氟利昂,最后都跑哪儿去了?

他们通过计算,提出了一个假说:这玩意儿看着稳定,但要是飘到几万米高空的平流层,被太阳紫外线一顿猛削,可能会断裂,释放出自由的氯原子。

而这个氯原子,一旦对位到臭氧,就会直接暴杀。

因为每一个氯原子,都可以抢走臭氧(O₃)的一个氧原子,变成一个不稳定的“氯氧自由基”和一个氧分子(O₂)。然后这个氯氧自由基又会和氧原子反应,把自己变回氯原子,再去祸害下一个。

这直接链式反应了,要是完全理想情况,那理论上一个氟利昂分子,就能把整个臭氧层给灭了。